Dec 18, 2025

Ana P.

8min Ler

Por padrão, o Ollama executa modelos de linguagem de grande escala (LLMs) por meio de uma interface de linha de comando (CLI). No entanto, você pode combiná-lo com o Open WebUI — uma ferramenta de interface gráfica do usuário (GUI) — para interagir com esses modelos de forma visual.

Essa configuração reduz as entradas complexas e propensas a erros da linha de comando, tornando-a ideal para usuários não técnicos e para equipes que precisam de uma maneira mais colaborativa e visual de trabalhar com LLMs e implantar aplicações de IA.

Neste artigo, você vai aprender a configurar o Ollama e o Open WebUI da maneira mais simples: usando um template de servidor privado virtual (VPS) pré-configurado. Nós também vamos te guiar pelo painel do Open WebUI, mostrando como personalizar as saídas do modelo e explorar os recursos de colaboração.

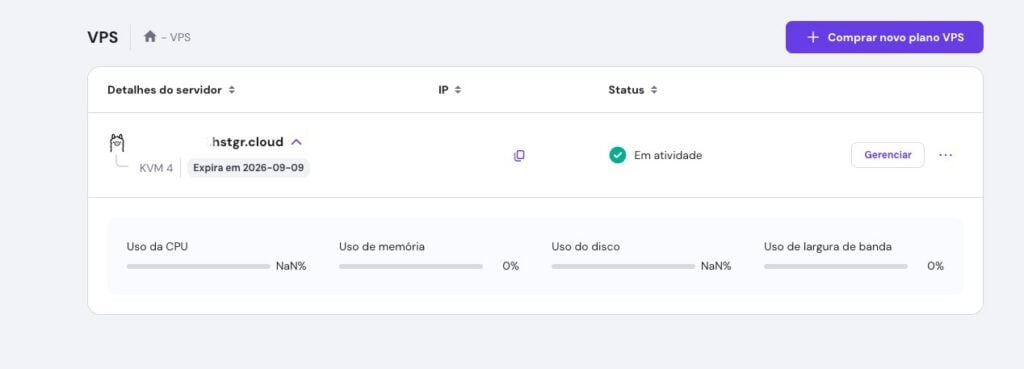

A maneira mais fácil de usar o Ollama com o Open WebUI é escolhendo um plano de Hospedagem LLM da Hostinger. Dessa forma, todos os componentes necessários — Docker, Ollama, Open WebUI e o modelo Llama 3.1 — já vêm pré-configurados.

Com base nos requisitos de sistema do Ollama, recomendamos o plano KVM 4, que oferece quatro núcleos de vCPU, 16 GB de RAM e 200 GB de armazenamento NVMe a partir de R$ 54,99/mês. Esses recursos garantirão que seus projetos sejam executados sem problemas.

Depois de comprar o plano, você pode acessar o painel do Open WebUI digitando o endereço IP do seu VPS seguido por :8080 no navegador. Por exemplo:

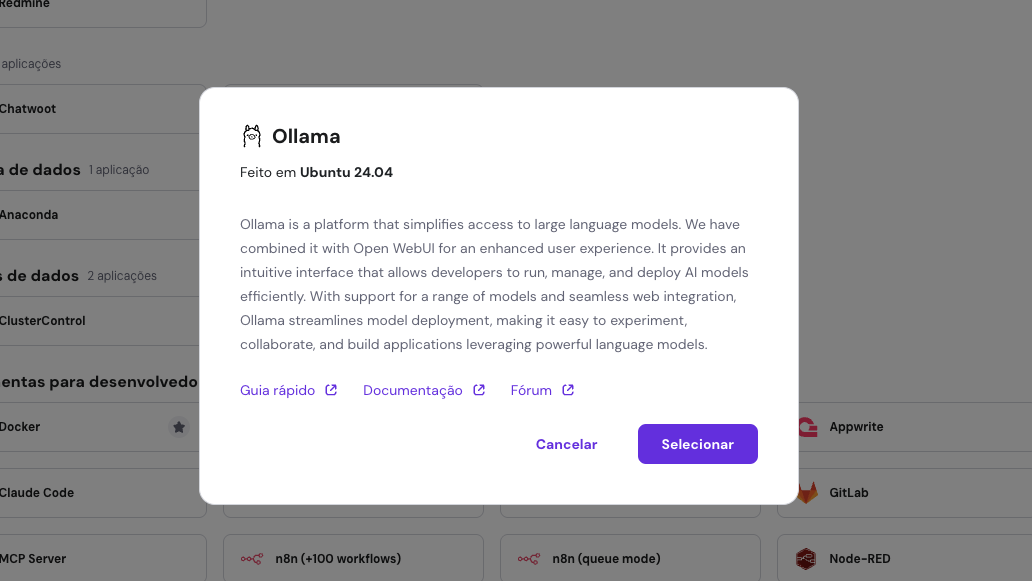

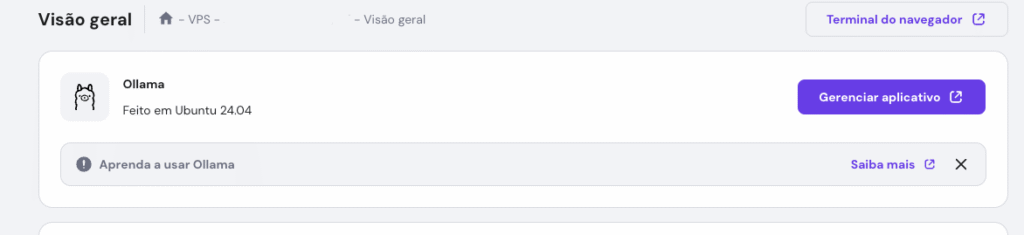

http://22.222.222.84:8080No entanto, se você trocou seu sistema operacional desde a configuração inicial ou usa um plano VPS regular da Hostinger, ainda poderá instalar o Ollama como um modelo seguindo estes passos do tutorial ollama gui:

Aguarde cerca de 10 minutos para que o processo de instalação seja concluído. Depois, role para cima e clique em Gerenciar aplicativo para acessar o Open WebUI.

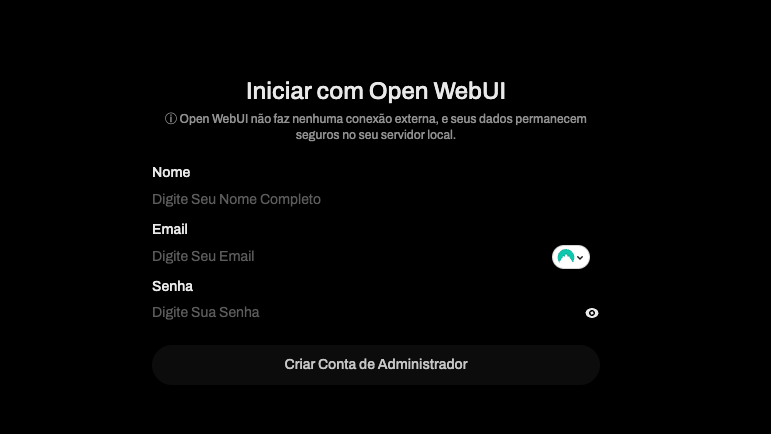

Na sua primeira visita, você precisará criar uma conta no Open WebUI. Siga as instruções na tela e salve o login e senha para acessos futuros.

Nesta seção, você vai conhecer os principais recursos do Open WebUI, desde a navegação no painel até o uso de modelos multimodais.

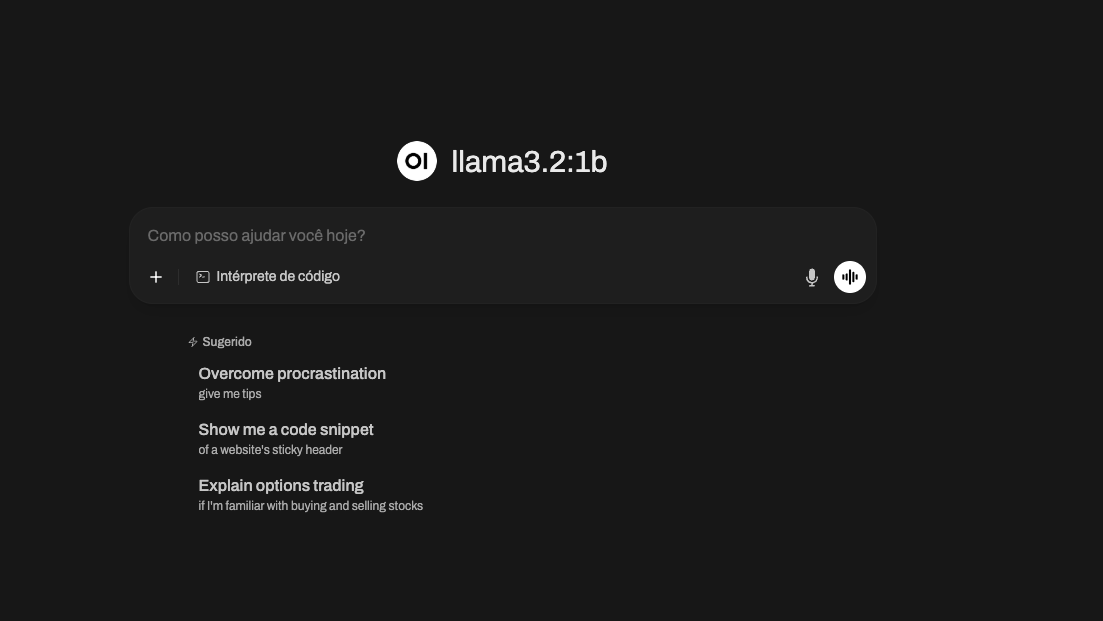

O Open WebUI conta com um layout acessível e intuitivo, ideal para iniciantes. Se você já usou o ChatGPT, a adaptação será ainda mais fácil, já que as interfaces são bem parecidas.

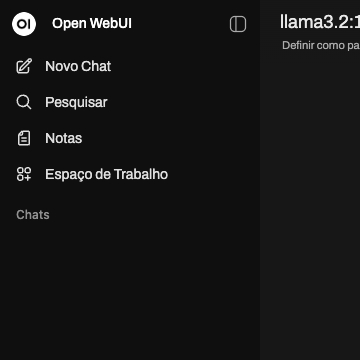

O painel é dividido em duas áreas principais:

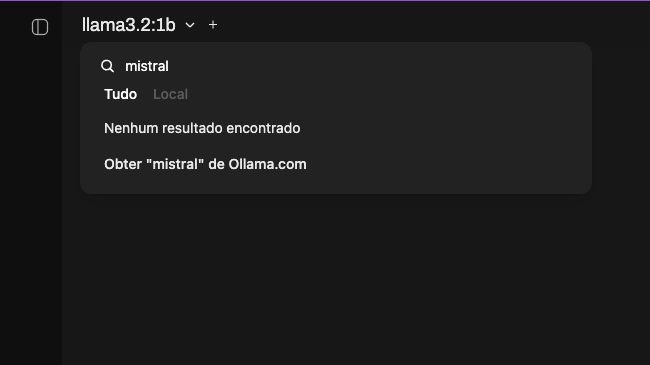

Como você instalou o Ollama e o Open WebUI com o template da Hostinger, o Llama 3.1 já está disponível para uso. Mas, se preferir, é possível baixar outros LLMs (EN) no painel de seleção de modelos, no canto superior esquerdo do painel de dados.

Basta digitar o nome do modelo na barra de pesquisa e clicar em Obter [modelo] de Ollama.com. Se não tiver certeza de qual escolher, consulte a biblioteca de modelos do Ollama para ver descrições detalhadas e casos de uso recomendados.

Entre as opções populares estão o Mistral, conhecido pela eficiência em tradução e resumo de textos, e o Code Llama, ideal para geração de código e tarefas de programação.

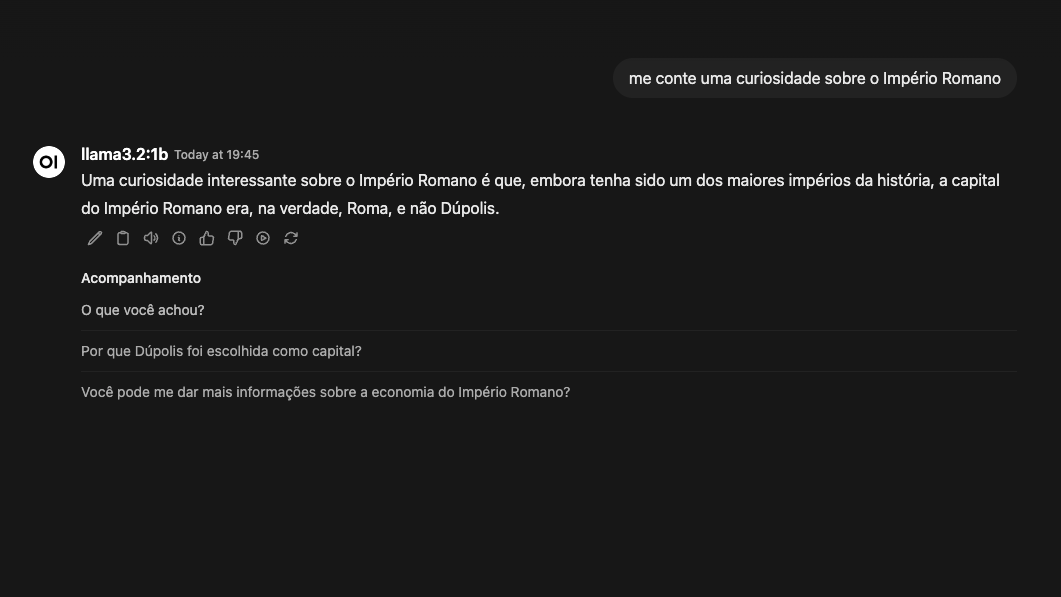

Depois de baixar um modelo, clique em Novo Chat para iniciar uma conversa. Escolha o modelo desejado, insira seu prompt e aguarde a resposta. Assim como no ChatGPT, você pode copiar o resultado, dar feedback ou pedir para regenerar a resposta, caso necessário.

Diferente do uso do Ollama pela CLI (EN), ao combinar esse LLM com o Open WebUI, você pode alternar entre modelos durante a mesma conversa. Isso é ótimo para explorar diferentes perspectivas em um único chat. Por exemplo, você pode começar com o Llama para uma discussão geral e, em seguida, mudar para o Vicuna para ter uma resposta mais especializada.

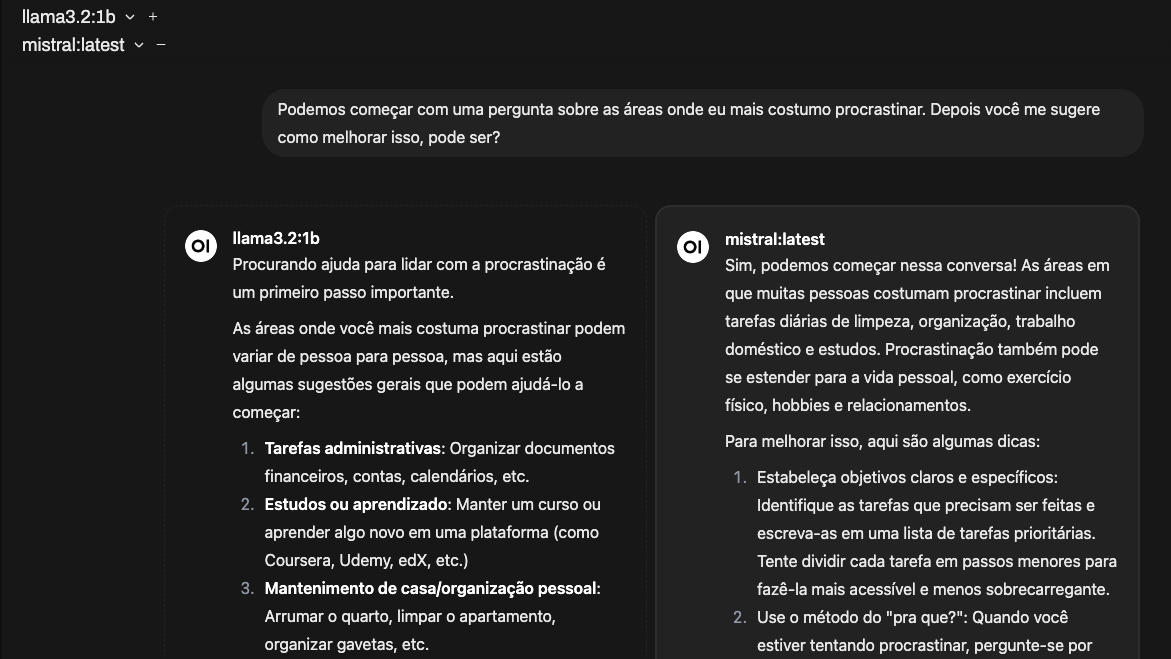

Outro recurso interessante é a possibilidade de carregar vários modelos no mesmo tempo de execução, facilitando a comparação de respostas. Basta selecionar um modelo inicial e, depois, clicar no botão + para adicionar outros. Ao inserir seu prompt, cada modelo exibirá sua resposta lado a lado.

Quer melhorar ainda mais seus resultados? Confira nosso guia completo sobre técnicas de construção de prompts em IA (EN).

Ajustar as respostas do modelo de inteligência artificial permite que ele interprete melhor os prompts, otimizando seu desempenho para diferentes tarefas, estilos de comunicação ou necessidades específicas. Para isso, clique em Controle de chat e explore os parâmetros disponíveis, que ajustam o comportamento, o estilo e a eficiência das respostas:

No mesmo menu, você também pode personalizar as opções Válvulas, que inclui ferramentas e funções personalizadas, e Prompt do sistema, que define o tom e o comportamento do modelo. Esses recursos serão explicados em mais detalhes na seção sobre colaboração.

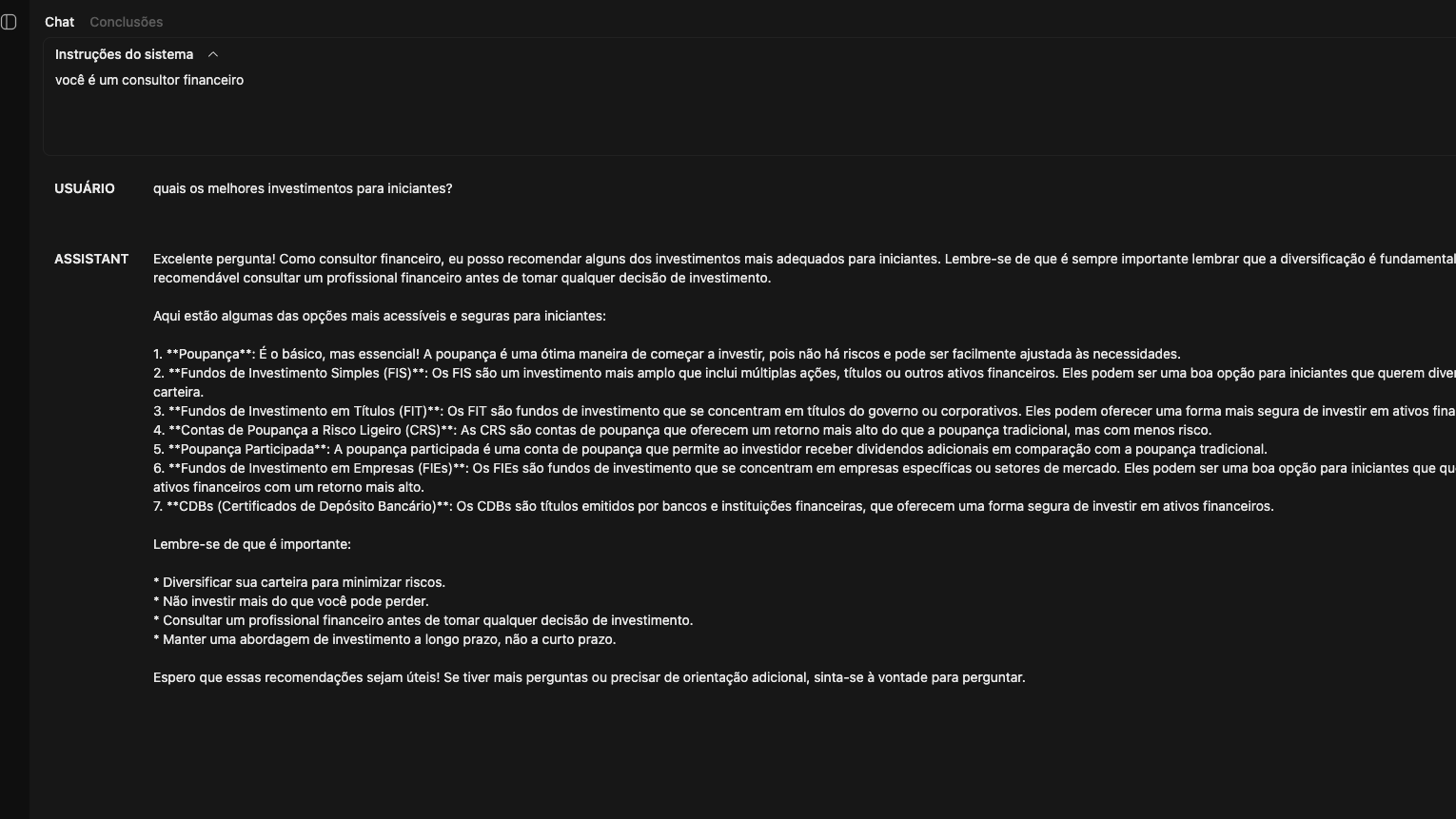

Além disso, o modo Playground, acessível no canto superior direito, permite experimentar diferentes combinações de parâmetros e tipos de prompts. Na aba de Chat, você pode testar configurações de conversação:

Por exemplo, se você definir as instruções como “você é um consultor financeiro” e inserir uma dúvida, o modelo responderá a partir dessa perspectiva.

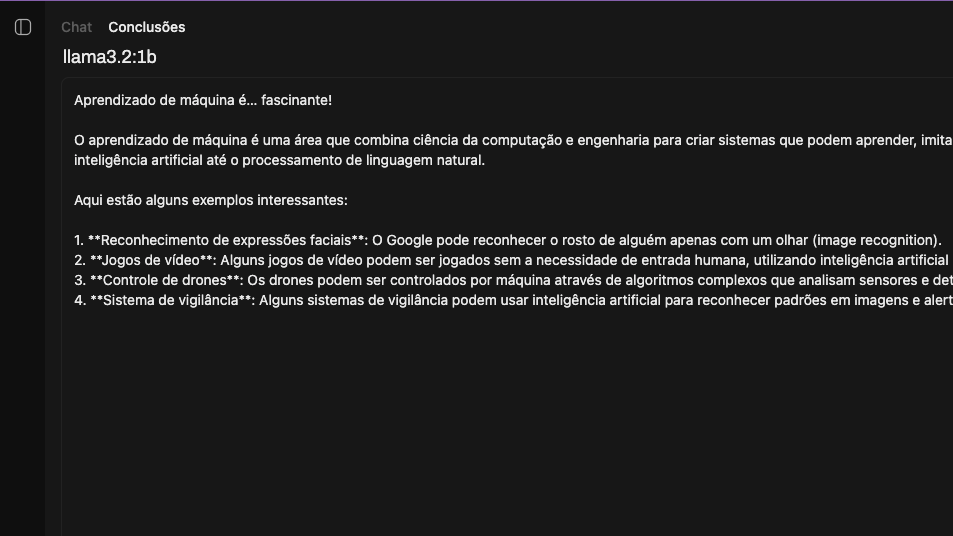

Enquanto isso, a aba Conclusão solicita que o modelo continue a partir do texto fornecido. Por exemplo, ao digitar “Aprendizado de máquina é…”, o modelo completará a frase explicando o conceito.

O Ollama e o Open WebUI oferecem suporte à Geração Aumentada de Recuperação (RAG), um recurso que aprimora as respostas do modelo ao buscar informações em tempo real em fontes externas, como documentos ou páginas da web.

Isso permite que o modelo forneça respostas mais atualizadas e relevantes para o contexto.

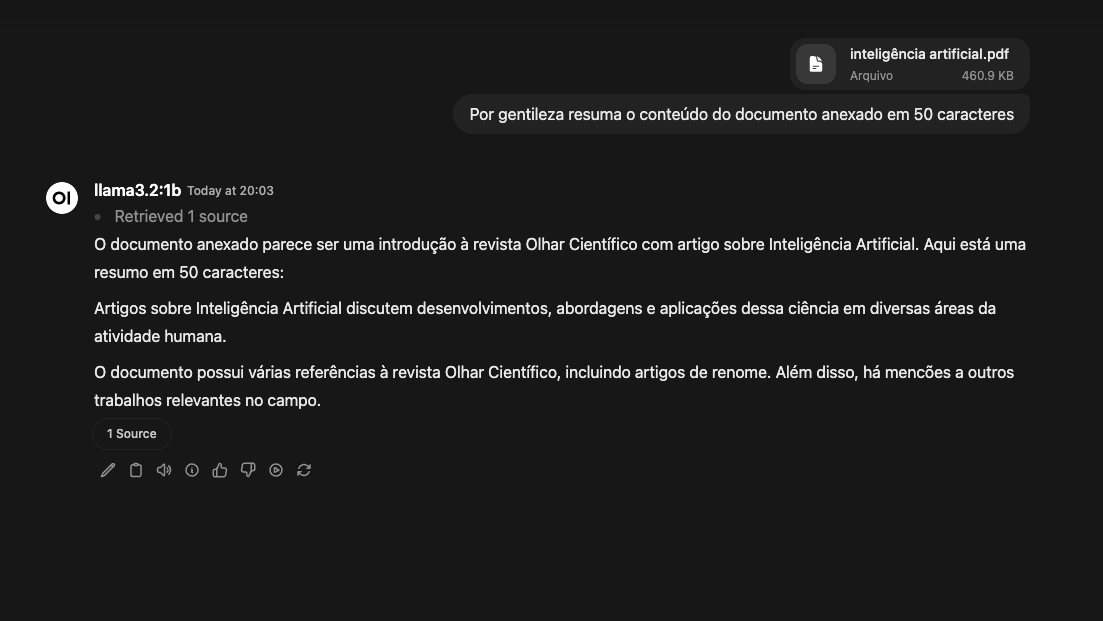

O Open WebUI permite que você faça upload de documentos nos formatos DOC, PDF, TXT e RTF. Clique no botão + no campo de prompt e selecione Upload de arquivos. Escolha o documento que deseja enviar, depois digite uma instrução, como:

“Por favor, resuma o conteúdo do arquivo anexado em 50 palavras.”

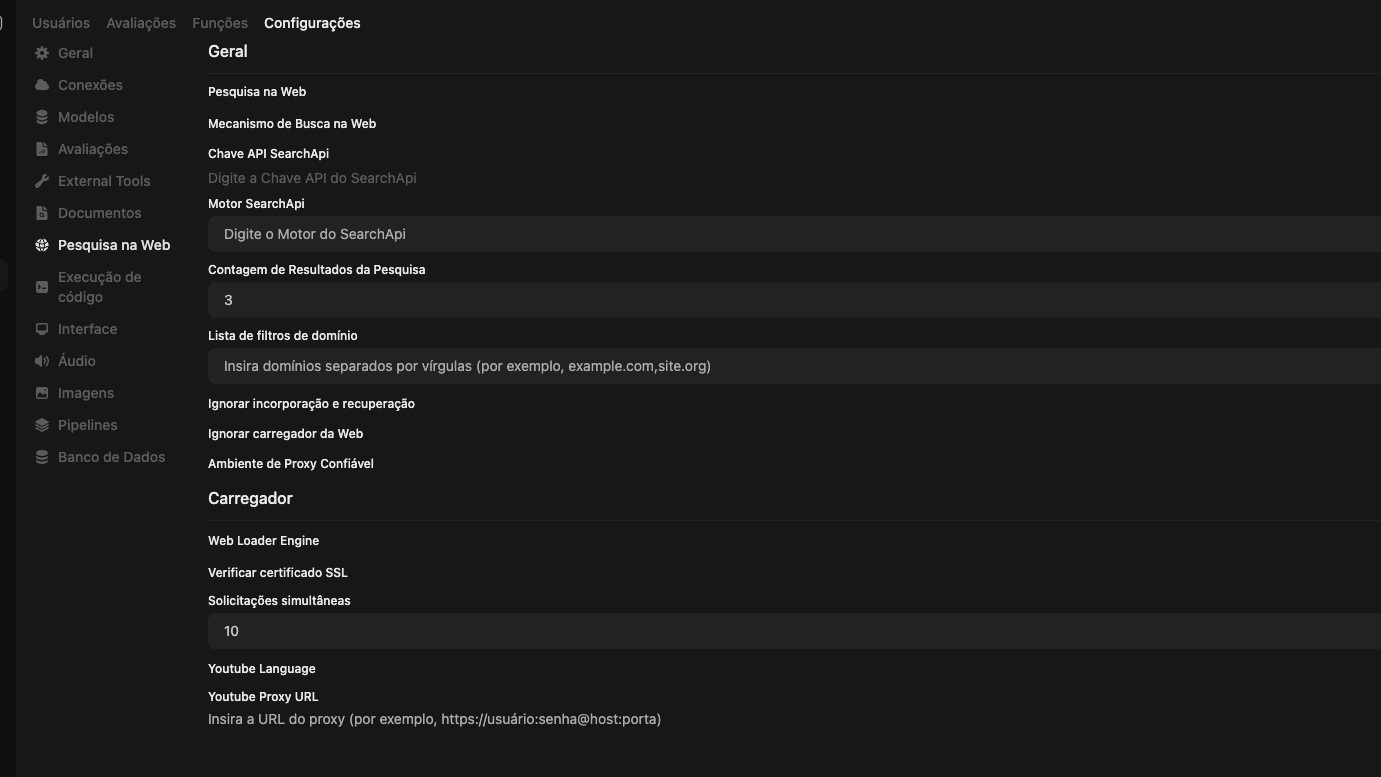

Se preferir que o modelo faça buscas diretamente na internet, você pode integrar o Open WebUI à SearchAPI, uma API que recupera informações a partir dos resultados de pesquisa. Siga o passo a passo para configurar:

Após concluir a configuração, volte para a interface do chat, clique no botão + no campo de mensagem e ative a opção Busca na web. Agora você pode solicitar que o modelo acesse informações diretamente da internet. Por exemplo:

“Encontre as últimas notícias sobre energia renovável e resuma os principais pontos.”

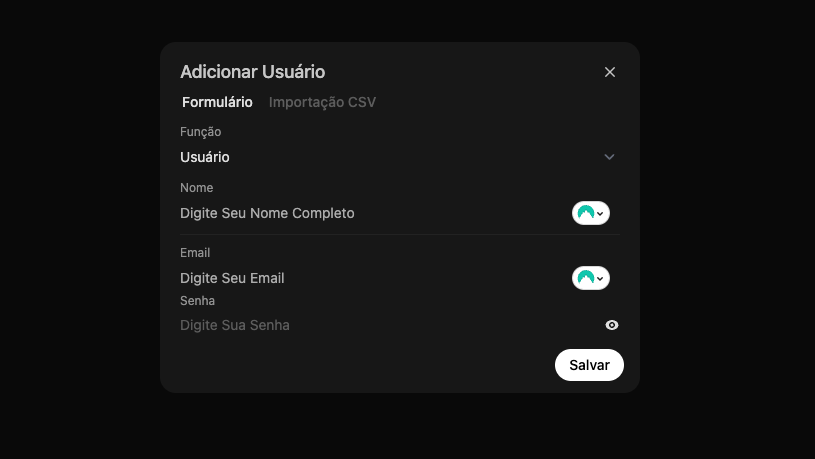

Para equipes que desejam colaborar, o Open WebUI permite gerenciar múltiplos usuários. Para adicionar um novo usuário:

Depois, compartilhe as credenciais para que o novo usuário possa acessar a plataforma. Importante: usuários sem privilégios de administrador não têm acesso à área de trabalho nem ao painel de administração.

Em seguida, explore a área de trabalho através da barra lateral esquerda. Você pode acessar a aba Modelos para: criar novos modelos baseados em modelos existentes, importar modelos personalizados da comunidade Open WebUI e excluir modelos que não usa mais.

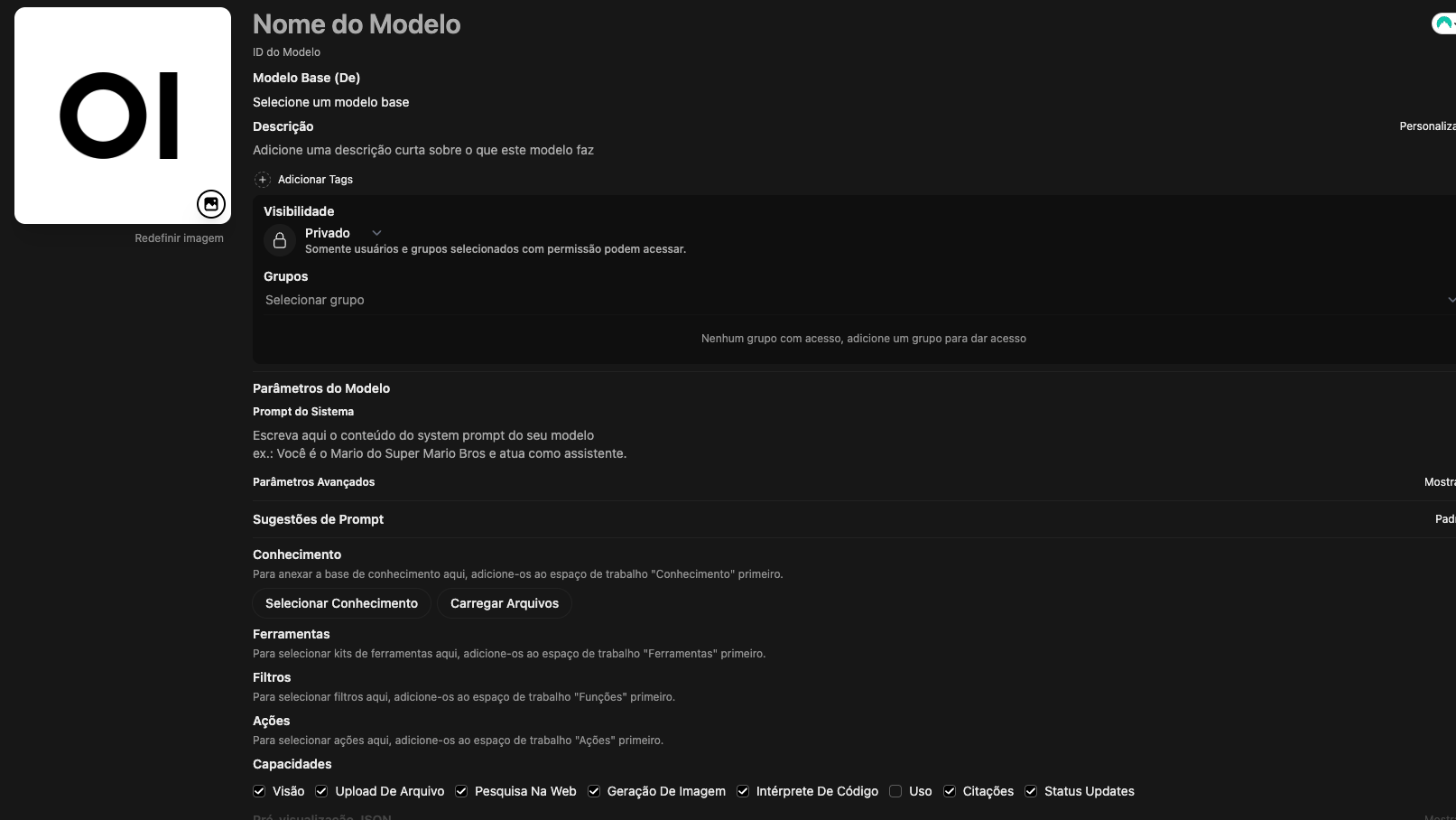

Para criar um modelo personalizado, clique em Criar um modelo e preencha informações como nome, ID e modelo base. Também é possível adicionar um prompt de sistema para orientar o comportamento do modelo, como instruí-lo a atuar como consultor financeiro e evitar perguntas fora do tema.

Nas opções avançadas, você pode: ajustar parâmetros, adicionar sugestões de prompts ou importar recursos de conhecimento. Depois de concluir a configuração, clique em Salvar e criar.

Se ainda não tiver criado recursos de conhecimento, vá até a aba Conhecimento. Clique em +, siga as instruções para importar seu conjunto de dados. Depois, volte ao seu novo modelo e importe o que você acabou de adicionar.

Além disso, você pode aplicar personalizações nas abas Prompts, Ferramentas e Funções. Caso esteja começando, é possível importar predefinições criadas pela comunidade se preferir.

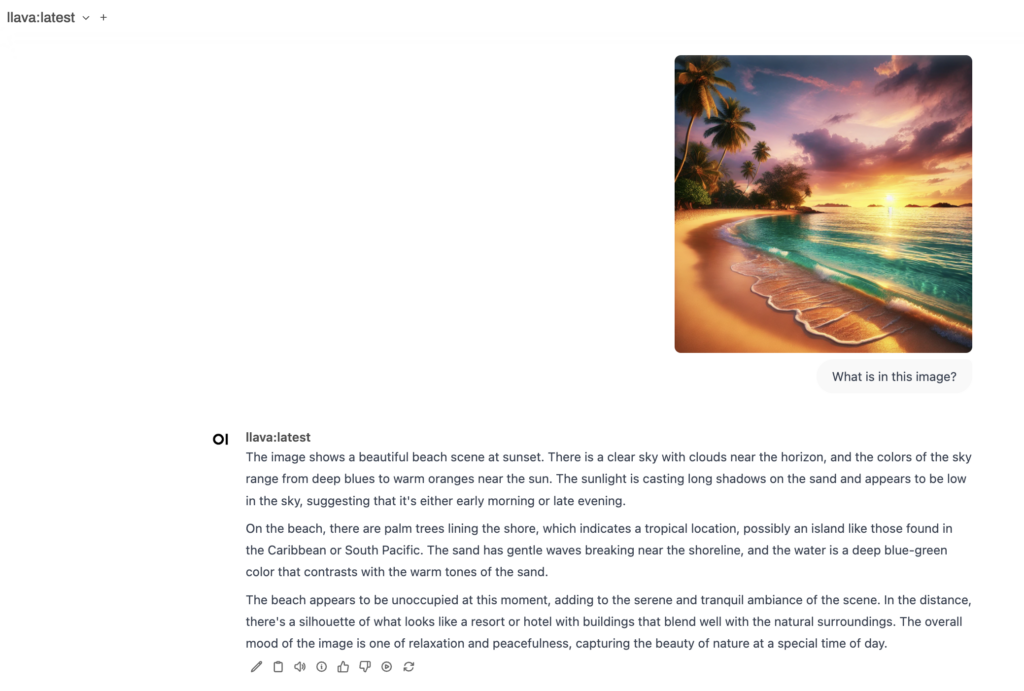

Por último, mas não menos importante, vamos demonstrar como trabalhar com modelos multimodais, que podem gerar respostas baseadas em texto e imagens. O Ollama também oferece suporte a vários modelos multimodais, como LlaVa, BakLLaVA e MiniCPM-V.

No exemplo a seguir, usaremos o LLaVA. Depois de baixar o modelo no painel de seleção, você pode usá-lo para diversas tarefas. Por exemplo, você pode enviar uma imagem pelo campo de prompt de comando e fazer perguntas relacionadas, como “O que há nesta imagem?”.

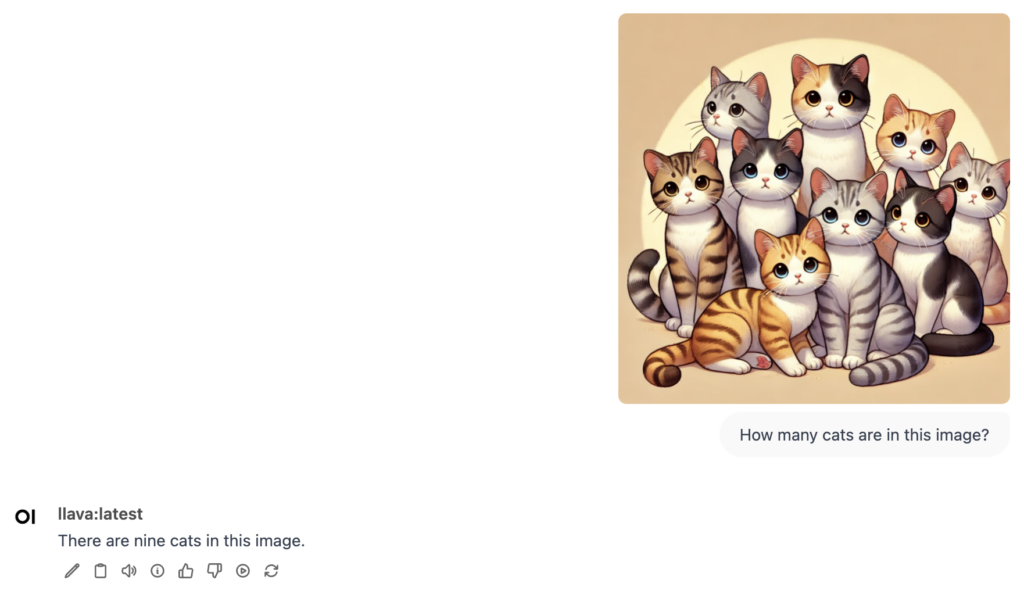

O modelo também pode criar legendas descritivas e identificar objetos dentro de uma imagem. Por exemplo, se você fizer upload de uma foto de gatos, pode perguntar: “Quantos gatos há nesta imagem?

Mas atenção, o LLaVA ainda não gera imagens. Ele é voltado apenas para análise e interpretação de imagens existentes.

Usando o Ollama com o Open WebUI você pode executar modelos em uma interface visual simples e intuitiva. O template Ollama VPS da Hostinger facilita a instalação dessas ferramentas, mesmo para quem não tem experiência técnica.

Depois de instalado, você pode navegar pelo painel, selecionar e executar modelos, além de explorar recursos de colaboração para aumentar a produtividade. As ferramentas avançadas do Open WebUI — como pesquisa na web e personalização de parâmetros — tornam a experiência ainda mais flexível para quem quer adaptar as interações do modelo às suas necessidades.

Para quem deseja implantar modelos próprios, é possível importar conjuntos de conhecimento, experimentar diferentes instruções e combiná-las com templates de prompts personalizados ou funções criadas pela comunidade.

Se tiver alguma dúvida, deixe sua pergunta nos comentários abaixo!

Usar a GUI com o Open WebUI simplifica as interações com o modelo ao oferecer um ambiente visual intuitivo. Isso a torna ideal para iniciantes, equipes e fluxos de trabalho colaborativos, sem a necessidade de usar comandos no terminal.

u003cbr /u003eVocê pode utilizar todos os modelos disponíveis no Ollama, tanto na versão CLI quanto na GUI. No entanto, a interface gráfica facilita especialmente o uso de modelos multimodais, ideais para tarefas como análise de imagens.

Sim. u003ca href=u0022https://www.hostinger.com/tutorials/how-to-install-docker-on-ubuntuu0022 target=u0022_blanku0022 rel=u0022noreferrer noopeneru0022u003eO Docker é necessáriou003c/au003e para configurar o Ollama com o Open WebUI. Mas, se você optar pelo template Ollama da Hostinger, todos os componentes essenciais — incluindo o Docker — já vêm pré-instalados.

Todo o conteúdo deste tutorial segue os rigorosos padrões editoriais e valores da Hostinger (EN).

Todo o conteúdo dos tutoriais deste site segue os rigorosos padrões editoriais e valores da Hostinger.