Feb 13, 2026

Faradilla A.

8min di lettura

Ollama è uno strumento potente per eseguire modelli linguistici di grandi dimensioni (LLM) in locale e offre a sviluppatori, data scientist e utenti tecnici maggiore controllo e flessibilità nella personalizzazione dei modelli.

Anche se puoi usare Ollama con interfacce grafiche di terze parti come Open WebUI per interazioni più semplici, eseguirlo tramite l’interfaccia a riga di comando (CLI) ti consente di registrare le risposte nei file e automatizzare i flussi di lavoro tramite script.

Questa guida ti accompagnerà nell’utilizzo di Ollama tramite la CLI, illustrando i comandi di base, come interagire con i modelli, automatizzare attività e creare modelli personalizzati. Alla fine, sarai in grado di personalizzare Ollama per i tuoi progetti basati sull’intelligenza artificiale.

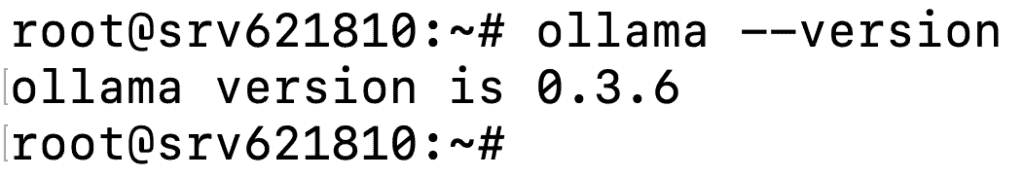

Prima di usare Ollama tramite la CLI, assicurati di averlo installato correttamente sul tuo sistema. Per verificarlo, apri il terminale ed esegui il seguente comando:

ollama --version

Dovresti vedere un output simile a questo:

Successivamente, familiarizza con i seguenti comandi essenziali di Ollama:

| Comando | Descrizione |

| ollama serve | Avvia Ollama sul tuo sistema locale. |

| ollama create <new_model> | Crea un nuovo modello a partire da uno esistente per personalizzarlo o addestrarlo. |

| ollama show <model> | Mostra i dettagli di un modello specifico, come la configurazione e la data di rilascio. |

| ollama run <model> | Esegue il modello specificato, rendendolo pronto per l’interazione. |

| ollama pull <model> | Scarica il modello specificato sul tuo sistema. |

| ollama list | Mostra tutti i modelli scaricati. |

| ollama ps | Mostra i modelli attualmente in esecuzione. |

| ollama stop <model> | Ferma il modello specificato in esecuzione. |

| ollama rm <model> | Rimuove il modello specificato dal tuo sistema. |

Questa sezione spiega come usare Ollama tramite la CLI, dall’interazione con i modelli al salvataggio dei risultati generati nei file.

Per iniziare a utilizzare i modelli in Ollama, devi prima scaricare il modello di interesse utilizzando il comando pull. Ad esempio, per scaricare Llama 3.2, esegui il seguente comando:

ollama pull llama3.2

Aspetta che il download sia completato; il tempo di attesa può variare a seconda delle dimensioni del file del modello.

Se non sei sicuro di quale modello scaricare, consulta la libreria ufficiale dei modelli di Ollama. Troverai informazioni utili su ogni modello, come le opzioni di personalizzazione, il supporto linguistico e i casi d’uso consigliati.

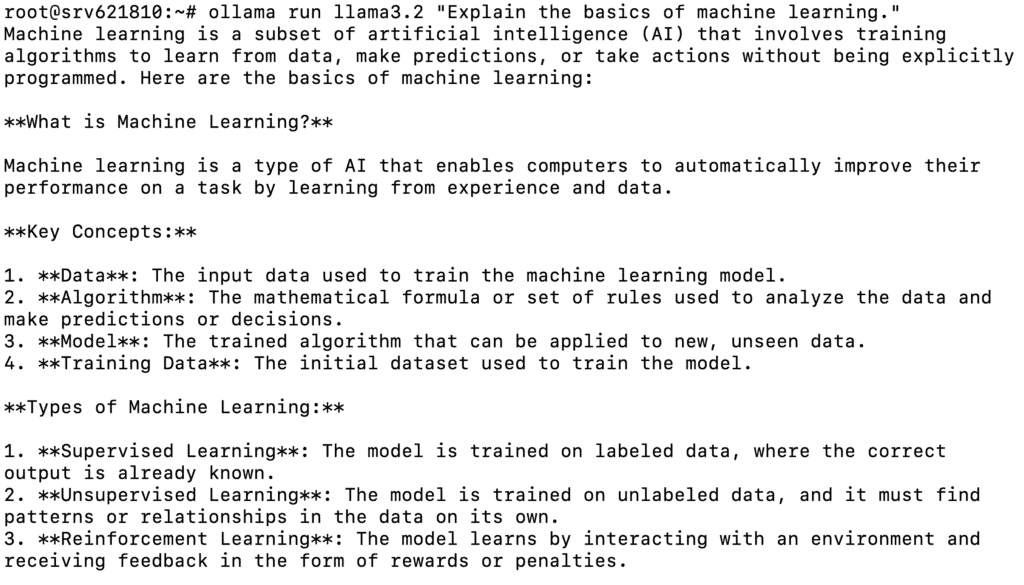

Dopo aver scaricato il modello, puoi eseguirlo con un prompt predefinito come il seguente:

ollama run llama3.2 "Spiega le basi del machine learning."

Ecco il risultato che dovresti ottenere:

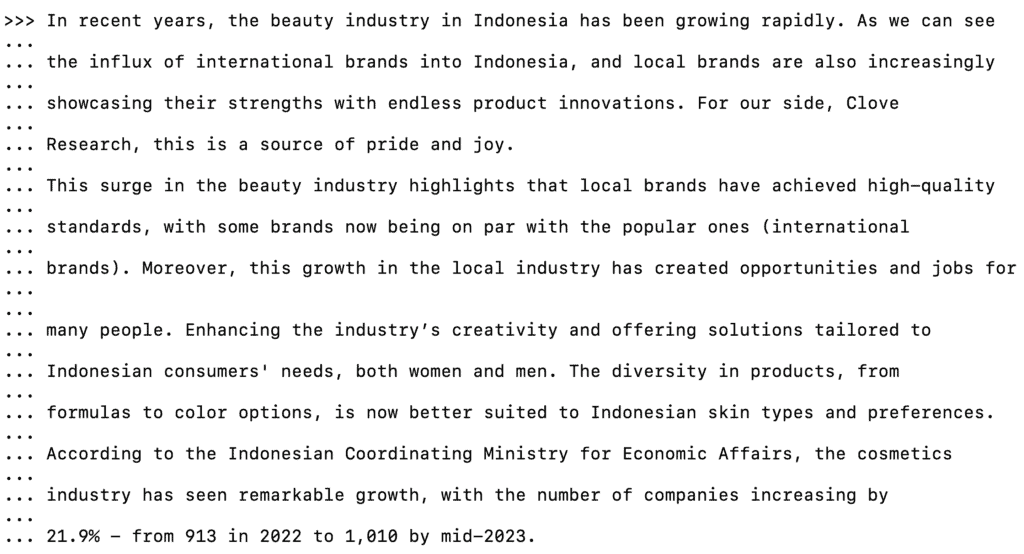

In alternativa, puoi eseguire il modello senza un prompt per avviare una sessione interattiva:

ollama run llama3.2

In questa modalità, puoi inserire le tue domande o istruzioni, e il modello genererà le risposte. Puoi anche fare domande di approfondimento per ottenere informazioni più dettagliate o chiarire una risposta precedente, ad esempio:

Puoi spiegarmi meglio come viene usato il machine learning nel settore sanitario?

Quando hai finito di interagire con il modello, scrivi:

/bye

Questo ti farà uscire dalla sessione e ti riporterà alla normale interfaccia del terminale.

Scopri come creare prompt AI per migliorare i tuoi risultati e le interazioni con i modelli di Ollama.

Anche se i modelli open-source pre-addestrati come Llama 3.2 funzionano bene per compiti generici come la generazione di contenuti, potrebbero non soddisfare sempre le esigenze di casi d’uso specifici. Per migliorare la precisione di un modello su un determinato argomento, è necessario addestrarlo utilizzando dati rilevanti.

Tieni presente che questi modelli hanno limitazioni di memoria a breve termine, quindi i dati di addestramento vengono conservati solo durante la conversazione attiva. Quando chiudi la sessione e ne avvii una nuova, il modello non ricorderà le informazioni con cui l’hai addestrato in precedenza.

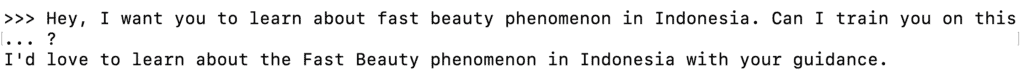

Per addestrare il modello, avvia una sessione interattiva. Poi, inizia l’addestramento digitando un prompt del tipo:

Ehi, voglio che impari qualcosa su [argomento]. Posso addestrarti su questo?

Il modello risponderà con un messaggio simile al seguente:

Puoi quindi fornire informazioni di base sull’argomento per aiutare il modello a comprendere meglio:

Per continuare l’addestramento e fornire più informazioni, chiedi al modello di farti delle domande sull’argomento. Per esempio:

Puoi farmi qualche domanda su [argomento] per aiutarti a capirlo meglio?

Una volta che il modello ha acquisito abbastanza contesto sull’argomento, puoi concludere l’addestramento e verificare se il modello ha acquisito correttamente le informazioni.

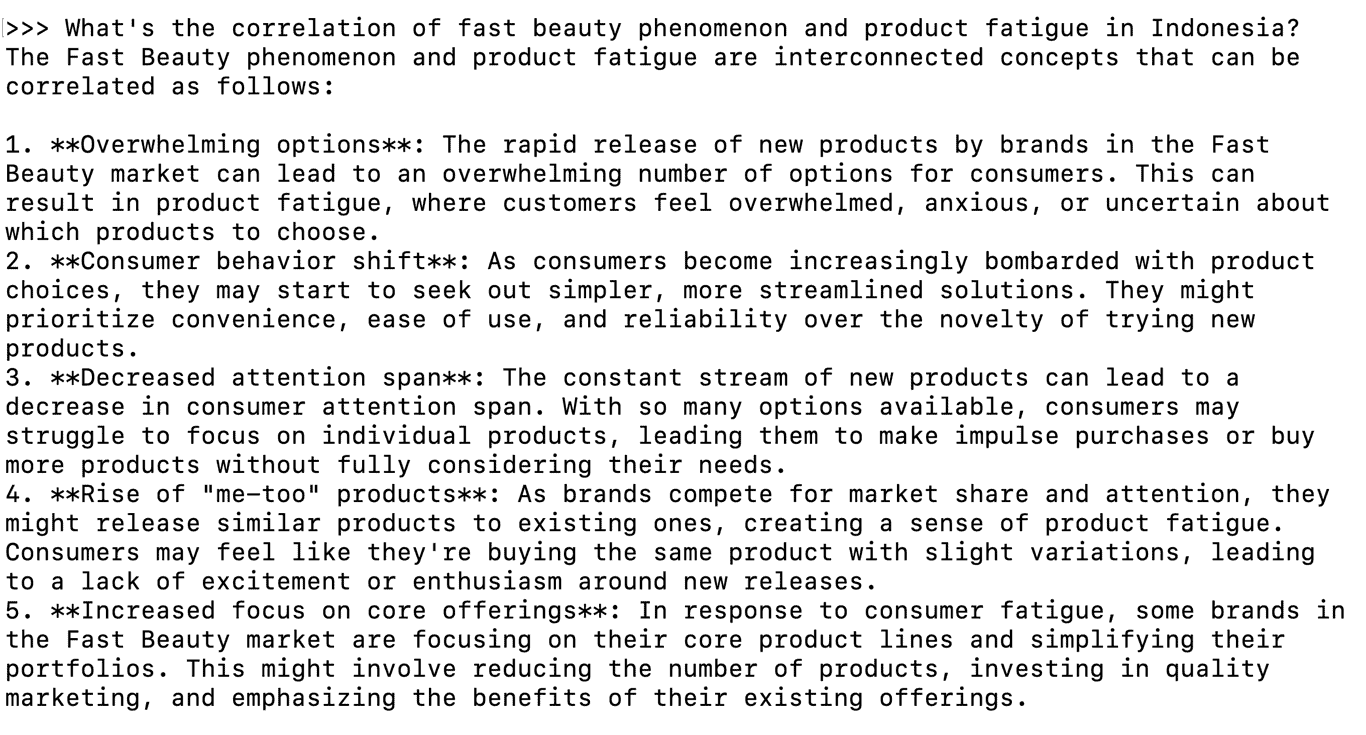

In Ollama, puoi chiedere al modello di eseguire operazioni utilizzando il contenuto di un file, come riassumere un testo o analizzare delle informazioni. Questo è particolarmente utile per documenti lunghi, in quanto elimina la necessità di copiare e incollare il testo quando dai istruzioni al modello.

Ad esempio, se hai un file chiamato input.txt con le informazioni che desideri riassumere, puoi eseguire il seguente comando:

ollama run llama3.2 "Riassumi il contenuto di questo file in 50 parole." < input.txt

Il modello leggerà il contenuto del file e genererà un riassunto:

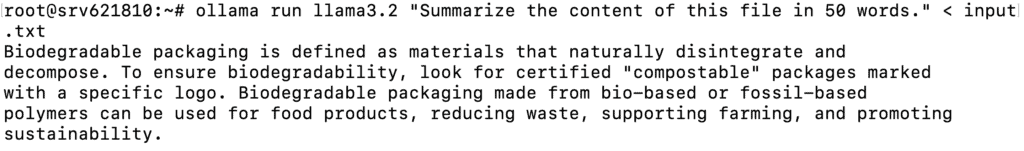

Ollama ti permette anche di registrare le risposte del modello in un file, facilitando la revisione o il perfezionamento in un secondo momento. Ecco un esempio di come porre una domanda al modello e salvare l’output in un file:

ollama run llama3.2 "Parlami delle energie rinnovabili." > output.txt

Questo comando salverà la risposta del modello nel file output.txt:

Ora che hai capito le basi, vediamo come usare Ollama in modo più avanzato tramite la CLI.

Usando Ollama tramite la CLI, puoi creare un modello personalizzato in base alle tue esigenze.

Per farlo, crea un Modelfile, che è il progetto del tuo modello personalizzato. Il file definisce impostazioni chiave come il modello di base, i parametri da regolare e il comportamento del modello rispetto ai prompt.

Segui questi passaggi per creare un modello personalizzato in Ollama:

1. Crea un nuovo Modelfile

Usa un editor di testo come nano per creare un nuovo Modelfile. In questo esempio, chiameremo il file custom-modelfile:

nano custom-modelfile

Poi, copia e incolla questo Modelfile di base, che personalizzerai nel passaggio successivo:

# Usa Llama 3.2 come modello base

FROM llama3.2

# Regola i parametri del modello

PARAMETER temperature 0.7

PARAMETER num_ctx 3072

PARAMETER stop "assistant:"

# Definisci il comportamento del modello

SYSTEM "Sei un esperto di sicurezza informatica."

# Personalizza il modello di conversazione

TEMPLATE """{{ if .System }}Advisor: {{ .System }}{{ end }}

Client: {{ .Prompt }}

Advisor: {{ .Response }}"""2. Personalizza il Modelfile

Ecco gli elementi chiave che puoi personalizzare nel Modelfile:

FROM llama3.2

PARAMETER temperature 0.9

PARAMETER num_ctx 4096

SYSTEM "Sei un esperto di sicurezza informatica. Rispondi solo alle domande relative alla sicurezza informatica. Se ti viene chiesto qualcosa di non pertinente, rispondi con: 'Rispondo solo alle domande relative alla sicurezza informatica.’"

TEMPLATE """{{ if .System }}<|start|>system

{{ .System }}<|end|>{{ end }}

<|start|>user

{{ .Prompt }}<|end|>

<|start|>assistant

"""Dopo aver fatto le modifiche che servono, salva il file ed esci da nano premendo Ctrl + X → Y → Invio.

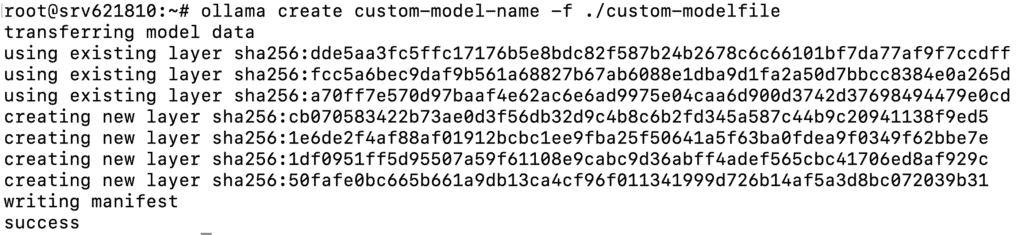

3. Crea ed esegui il modello personalizzato

Una volta che il tuo Modelfile è pronto, usa il comando qui sotto per creare un modello basato sul file:

ollama create custom-model-name -f ./custom-modelfile

Dovresti vedere un messaggio che dice che il modello è stato creato con successo:

Dopo, esegui il modello come faresti con qualsiasi altro:

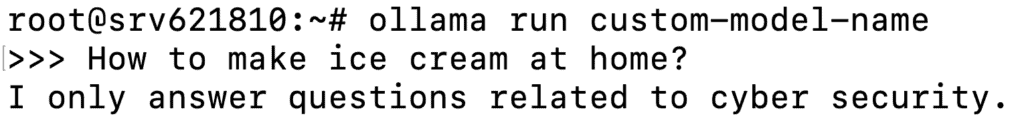

ollama run custom-model-name

Questo avvierà il modello con le personalizzazioni che hai fatto e potrai interagire con esso:

Puoi continuare a modificare e perfezionare il Modelfile regolando i parametri, modificando i messaggi di sistema, aggiungendo template più avanzati o persino includendo i tuoi set di dati. Salva le modifiche e riesegui il modello per vedere gli effetti.

Automatizzare le attività ripetitive in Ollama può farti risparmiare tempo e garantire la coerenza del flusso di lavoro. Usando gli script bash, puoi eseguire i comandi automaticamente. Con i cron job, puoi programmare l’esecuzione delle attività in orari specifici. Ecco come iniziare:

Creare ed eseguire script bash

Puoi creare uno script bash che esegue i comandi di Ollama. Ecco come:

nano ollama-script.sh

#!/bin/bash # Esegui il modello e salva il risultato in un file ollama run llama3.2 "Quali sono le ultime tendenze nell'IA?" > ai-output.txt

chmod +x ollama-script.sh

./ollama-script.sh

Configura i cron job per automatizzare le attività

Puoi combinare il tuo script con un cron job per automatizzare attività come l’esecuzione regolare dei modelli. Ecco come impostare un cron job per eseguire automaticamente gli script Ollama:

crontab -e

0 0 * * 0 /path/to/ollama-script.sh

Ecco alcuni esempi reali di come usare la CLI di Ollama.

Generazione di testo

Puoi usare modelli pre-addestrati per creare riassunti, generare contenuti o rispondere a domande specifiche.

ollama run llama3.2 "Riassumi il seguente testo:" < long-document.txt

ollama run llama3.2 "Scrivi un breve articolo sui vantaggi dell'uso dell'IA nel settore sanitario."> article.txt

ollama run llama3.2 "Quali sono le ultime tendenze nell'intelligenza artificiale e come influenzeranno la sanità?"

Elaborazione, analisi e previsione dei dati

Ollama ti permette anche di gestire attività di elaborazione dei dati come la classificazione dei testi, l’analisi del sentiment e la previsione.

ollama run llama3.2 "Analizza il sentiment di questa recensione del cliente: 'Il prodotto è fantastico, ma la consegna è stata lenta'."

ollama run llama3.2 "Classifica questo testo nelle seguenti categorie: Notizie, Opinioni o Recensioni." < textfile.txt

ollama run llama3.2 "Prevedi l'andamento del prezzo delle azioni per il prossimo mese in base ai seguenti dati:" < stock-data.txt

Integrazione con strumenti esterni

Un altro uso comune della CLI di Ollama è combinarla con strumenti esterni per automatizzare l’elaborazione dei dati e ampliare le capacità di altri programmi.

curl -X GET "https://api.example.com/data" | ollama run llama3.2 "Analizza i seguenti dati API e riassumi le informazioni chiave."

import subprocess result = subprocess.run(['ollama', 'run', 'llama3.2', 'Dammi le ultime tendenze del mercato azionario'], capture_output=True) print(result.stdout.decode())

In questo articolo hai imparato le basi per usare Ollama tramite CLI, come eseguire comandi, interagire con i modelli e registrare le risposte dei modelli nei file.

Con l’interfaccia a riga di comando, puoi anche eseguire operazioni più avanzate, come creare nuovi modelli basati su quelli esistenti, automatizzare flussi di lavoro complessi con script e cron job e integrare Ollama con strumenti esterni.

Puoi esplorare le funzionalità di personalizzazione di Ollama per sfruttarne appieno il potenziale nei tuoi progetti di AI. Se hai domande o desideri condividere la tua esperienza con Ollama nella CLI, non esitare a utilizzare la casella dei commenti qui sotto.

Con la versione CLI di Ollama, puoi eseguire modelli, generare testo, eseguire attività come l’analisi del sentiment, automatizzare i flussi di lavoro con gli script, creare modelli personalizzati e integrare Ollama con strumenti esterni o API per applicazioni avanzate.

Per installare i modelli tramite la CLI, prima assicurati di aver scaricato Ollama sul tuo sistema. Poi, usa il comando ollama pull seguito dal nome del modello. Per esempio, per installare Llama 3.2, esegui ollama pull llama3.2.

Anche se tecnicamente puoi usare modelli multimodali come LlaVa nella CLI di Ollama, non è molto pratico perché la CLI è pensata per le attività basate sul testo. È consigliabile usare Ollama con strumenti GUI per gestire il lavoro legato alle immagini.

Tutti i contenuti dei tutorial presenti su questo sito web sono soggetti ai rigorosi standard editoriali e ai valori di Hostinger.