Feb 13, 2026

Faradilla A.

11min di lettura

Integrare n8n con Ollama ti consente di sfruttare diversi modelli di AI nel tuo flusso di automazione, permettendoti di eseguire operazioni complesse che altrimenti sarebbero difficili o impossibili da automatizzare.

Tuttavia, il processo può risultare complesso, poiché è necessario configurare diverse impostazioni su entrambi gli strumenti affinché funzionino correttamente insieme.

Se hai già n8n e Ollama installati sul tuo server, puoi integrarli in quattro semplici passaggi:

Dopo aver completato questi passaggi, avrai un flusso di elaborazione AI funzionante basato su Ollama, che potrai integrare in un sistema di automazione più completo. Ad esempio, puoi collegare applicazioni di messaggistica come WhatsApp per creare un chatbot AI operativo.

Inoltre, eseguire tutto in locale su un server privato, come un VPS Hostinger, ti offre un maggiore controllo sui tuoi dati. Questo rende l’integrazione particolarmente adatta all’automazione di attività che coinvolgono informazioni sensibili, come il riepilogo di documenti interni o la creazione di un chatbot aziendale.

Vediamo nel dettaglio come collegare Ollama a n8n e creare un chatbot basato su questa integrazione. Nella parte finale, analizzeremo anche i casi d’uso più comuni e come ampliare le funzionalità utilizzando i nodi LangChain.

Per integrare n8n con Ollama, assicurati di soddisfare i seguenti prerequisiti:

Importante! Consigliamo vivamente di installare sia n8n sia Ollama nello stesso container Docker per garantire un migliore isolamento. Questo è il metodo utilizzato per testare il tutorial, ed è stato verificato come funzionante.

Se utilizzi un VPS Hostinger, puoi iniziare installando n8n oppure Ollama in un container Docker semplicemente selezionando il template del sistema operativo corrispondente: l’applicazione verrà installata in un container per impostazione predefinita. Successivamente, dovrai installare anche l’altra applicazione all’interno dello stesso container.

Collegare Ollama a n8n richiede l’aggiunta del nodo corretto e la configurazione di diverse impostazioni. In questa sezione vedremo i passaggi nel dettaglio, inclusa la procedura per testare il corretto funzionamento dell’integrazione.

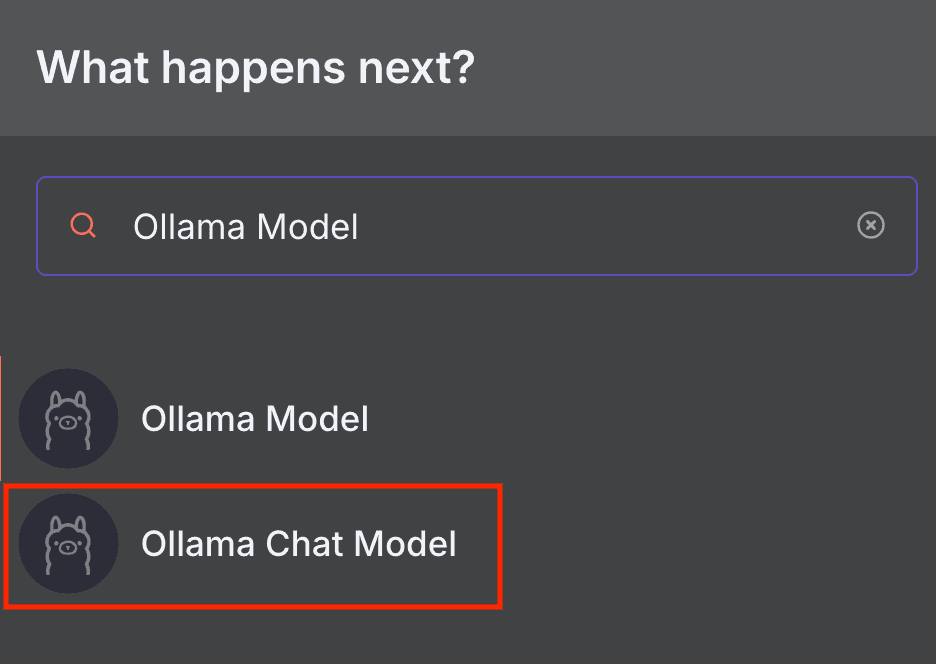

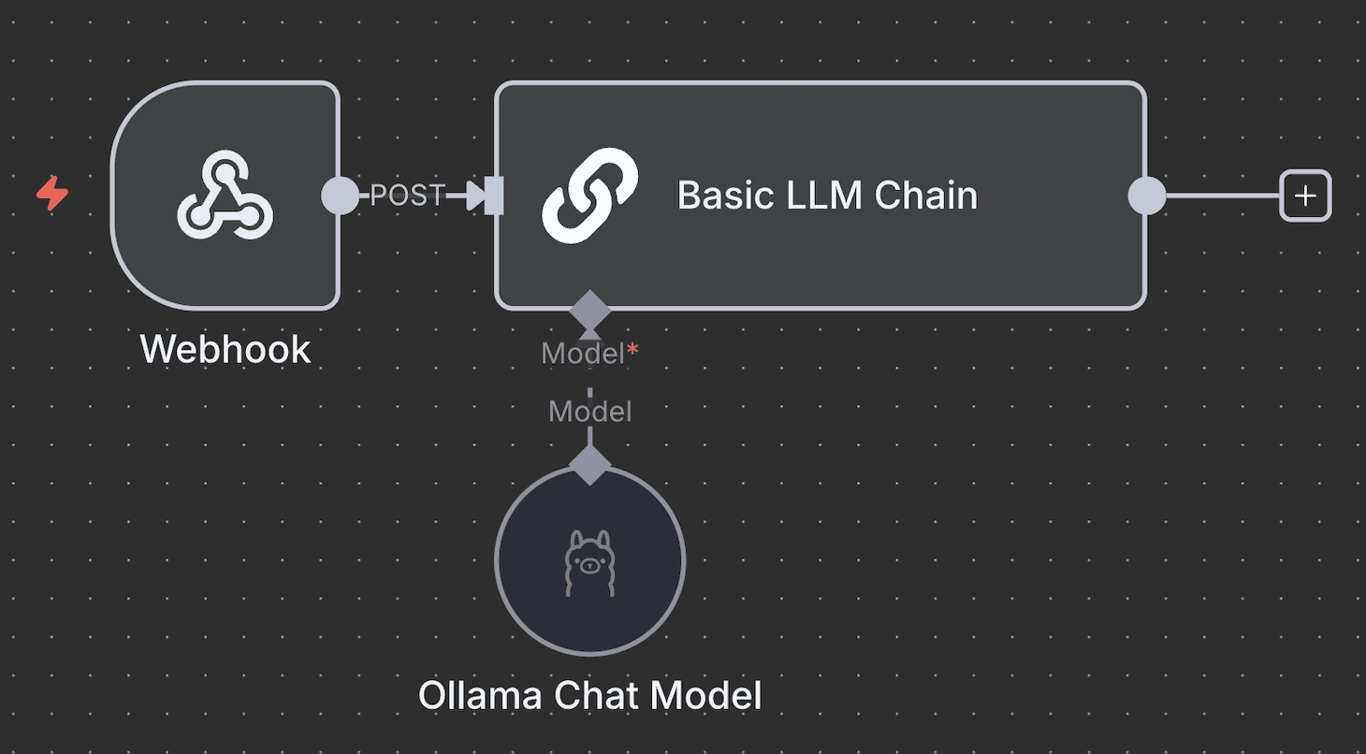

L’aggiunta del nodo Ollama Chat Model consente a n8n di connettersi ai modelli linguistici di grandi dimensioni (LLM) eseguiti su Ollama tramite un agente conversazionale.

n8n offre due nodi dedicati a Ollama: Ollama Model e Ollama Chat Model. Il nodo Ollama Chat Model è progettato specificamente per le conversazioni e include un nodo Basic LLM Chain integrato che inoltra il messaggio al modello selezionato. Il nodo Ollama Model, invece, è più adatto a casi d’uso generici in combinazione con altri nodi Chain: approfondiremo questo aspetto nella sezione dedicata a LangChain.

In questo tutorial utilizzeremo il nodo Ollama Chat Model perché è più semplice da configurare e integrare in un workflow di automazione più completo. Ecco come aggiungerlo in n8n:

Si aprirà la finestra di configurazione del nodo selezionato. Passa al passaggio successivo per configurarlo.

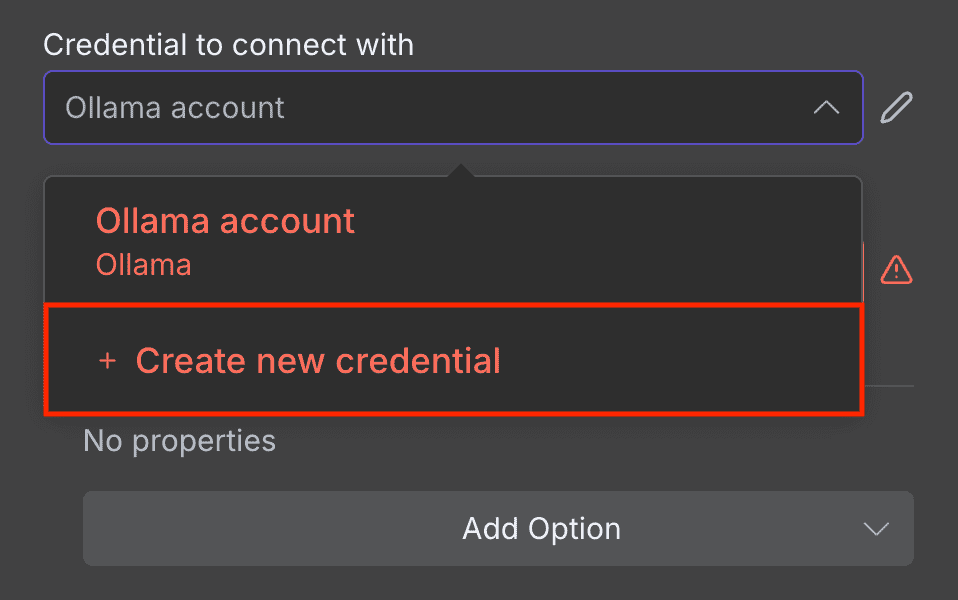

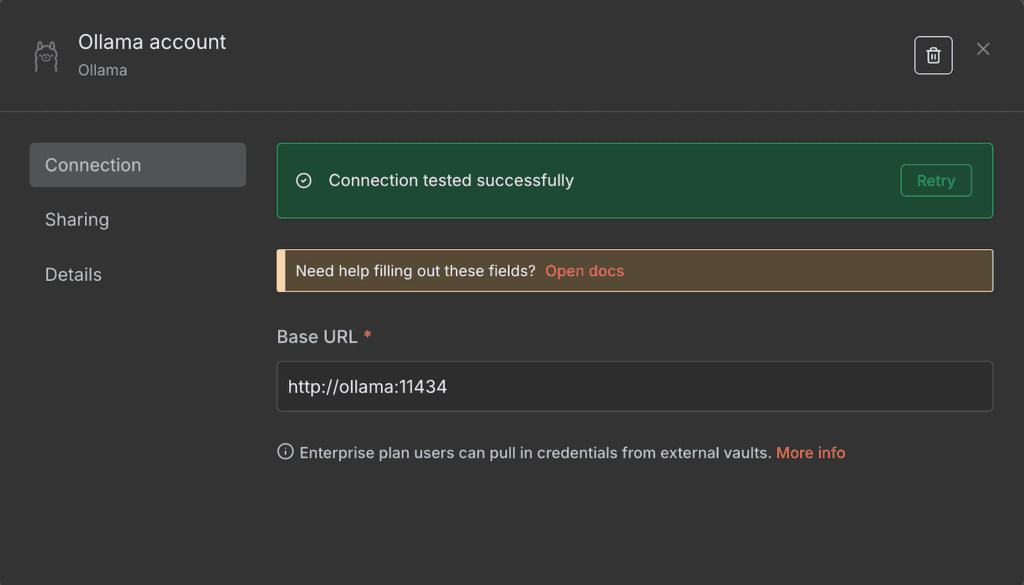

Prima di selezionare un modello AI e configurarne le impostazioni di runtime, devi collegare n8n alla tua istanza Ollama self-hosted. Ecco come fare:

Se la connessione va a buon fine, vedrai un messaggio di conferma. In caso contrario, verifica che l’indirizzo sia corretto e che Ollama sia in esecuzione.

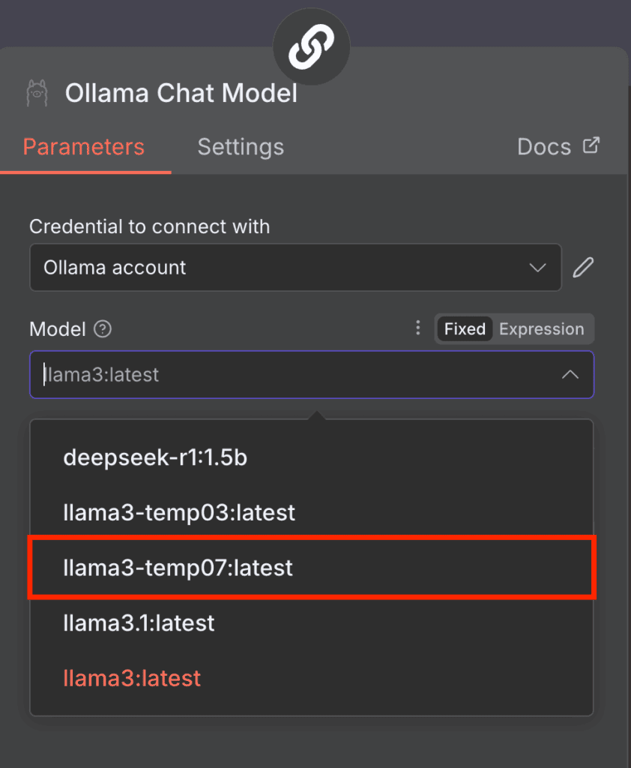

Una volta stabilita la connessione, puoi selezionare l’LLM da utilizzare nel nodo Ollama. Espandi il menu a discesa Model e scegli il modello dall’elenco. Se il menu risulta disabilitato, aggiorna la pagina di n8n per risolvere il problema.

Tieni presente che attualmente n8n supporta solo alcuni modelli, come Llama 3 e DeepSeek R1. Se il menu Model mostra un errore o un elenco vuoto, è probabile che nella tua installazione di Ollama siano presenti solo modelli non compatibili.

Per risolvere il problema, scarica un modello compatibile tramite la CLI di Ollama, eseguendo il seguente comando nel tuo ambiente Ollama:

ollama run model-name

Puoi anche utilizzare un modello con impostazioni di runtime personalizzate, ad esempio una temperatura più alta. Ecco come crearne uno tramite Ollama CLI:

docker exec -it ollama bash

echo "FROM llama3" > Modelfile

echo "PARAMETER temperature 0.7" >> Modelfile

ollama create llama3-temp07 -f Modelfile

Dopo aver completato questi passaggi, n8n dovrebbe rilevare il nuovo modello Llama 3 con temperatura personalizzata 0,7.

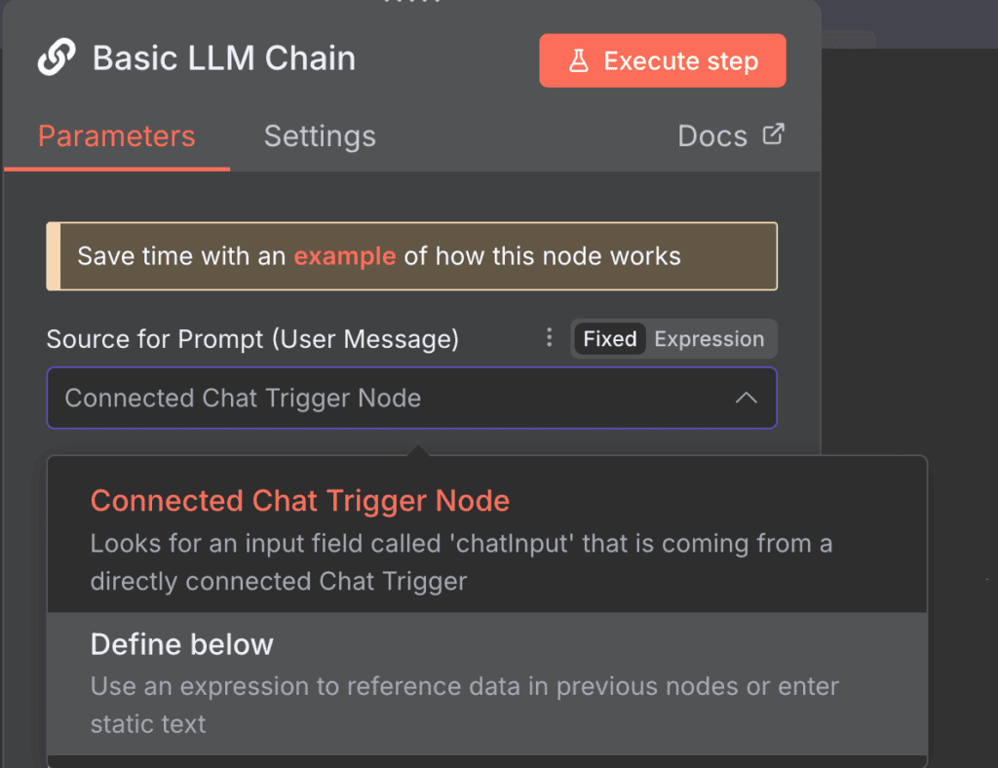

Configurando le impostazioni del prompt puoi definire in che modo il nodo Basic LLM Chain elaborerà l’input prima di inviarlo a Ollama. Puoi utilizzare le impostazioni predefinite, ma è consigliabile personalizzarle in base al tuo caso d’uso.

Di seguito trovi due modalità principali per configurare il prompt e i relativi esempi di utilizzo.

Nodo Connected Chat trigger

L’opzione Connected Chat trigger utilizza i messaggi del nodo Chat predefinito come input per Ollama. È la modalità attiva per impostazione predefinita e inoltra i messaggi senza modificarli.

Puoi comunque aggiungere prompt supplementari per influenzare l’output del modello. Per farlo, fai click su Add Prompt nella sezione Chat Messages (if Using a Chat Model) e scegli una delle seguenti opzioni:

Define below

L’opzione Define below è adatta se vuoi inserire un prompt riutilizzabile già scritto. È particolarmente utile quando devi elaborare dati dinamici, che puoi richiamare tramite Expressions, una libreria JavaScript che consente di manipolare l’input o selezionare campi specifici.

Ad esempio, se il nodo precedente recupera dati sull’utilizzo delle risorse del tuo VPS e vuoi analizzarli con un modello AI, il prompt rimane invariato mentre i dati cambiano.

Il prompt potrebbe essere strutturato così, dove {{ $json.metric }} rappresenta il campo contenente i dati dinamici:

L’ultimo utilizzo del mio server è {{ $json.metric }}. Analizza questi dati e confrontali con lo storico precedente per verificare eventuali anomalie.Anche in questa modalità puoi aggiungere ulteriori prompt per fornire più contesto al modello.

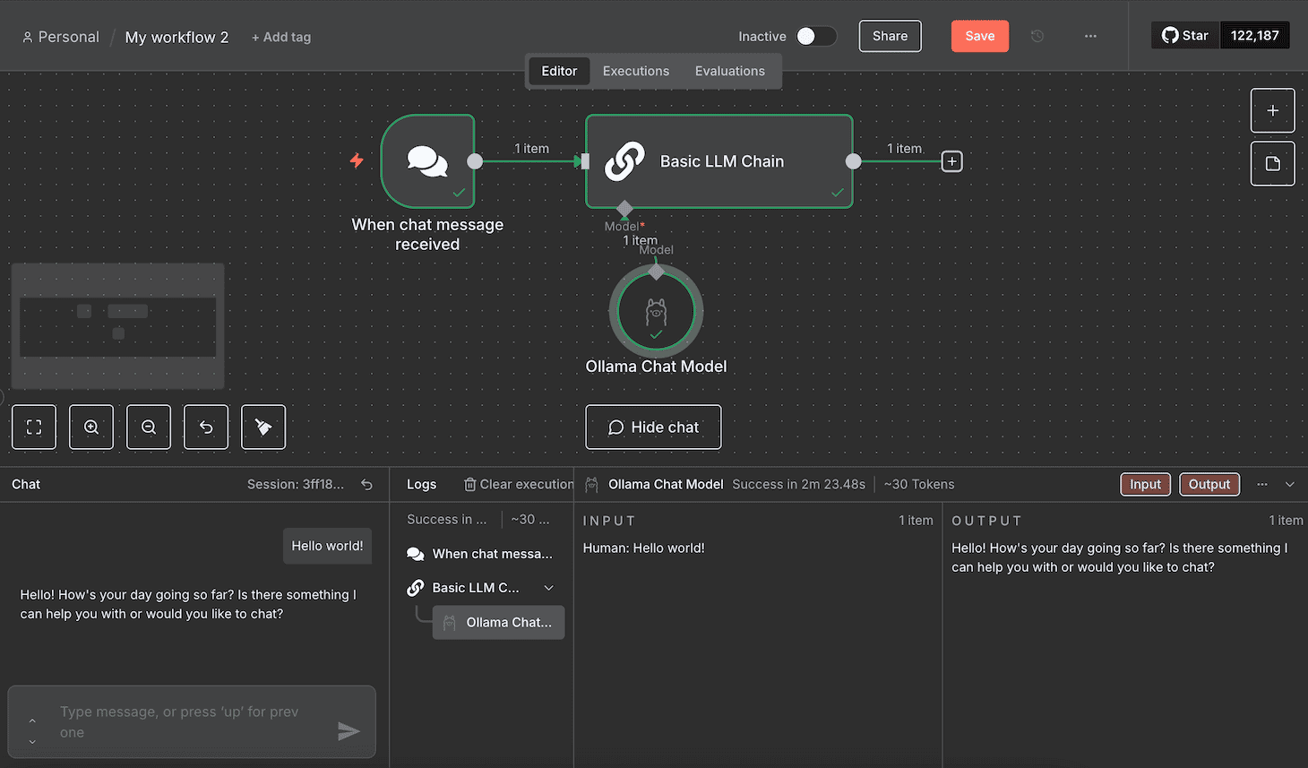

Inviare un prompt di test ti permette di verificare che il modello Ollama funzioni correttamente quando riceve input tramite n8n. Il modo più semplice è inviare un messaggio di esempio seguendo questi passaggi:

Attendi che il workflow completi l’elaborazione del tuo messaggio. Durante i test, il flusso si è bloccato occasionalmente. Se riscontri lo stesso problema, ricarica n8n e invia nuovamente il messaggio.

Se il test va a buon fine, tutti i nodi diventeranno verdi. Puoi visualizzare l’input e l’output JSON di ciascun nodo facendo doppio click su di esso e controllando i pannelli laterali nella finestra di configurazione.

Integrare Ollama in n8n ti consente di automatizzare diverse attività con gli LLM, tra cui la creazione di un flusso di lavoro in n8n basato sull’AI che risponde alle richieste degli utenti, come un chatbot. In questa sezione vedremo i passaggi necessari per svilupparne uno.

Se vuoi creare un sistema di automazione per altre attività, dai un’occhiata ai nostri esempi di workflow n8n per trovare ispirazione.

In n8n, il nodo trigger definisce l’evento che avvia il flusso di lavoro. Tra le varie opzioni disponibili, ecco le più comuni per creare un chatbot:

Trigger della chat

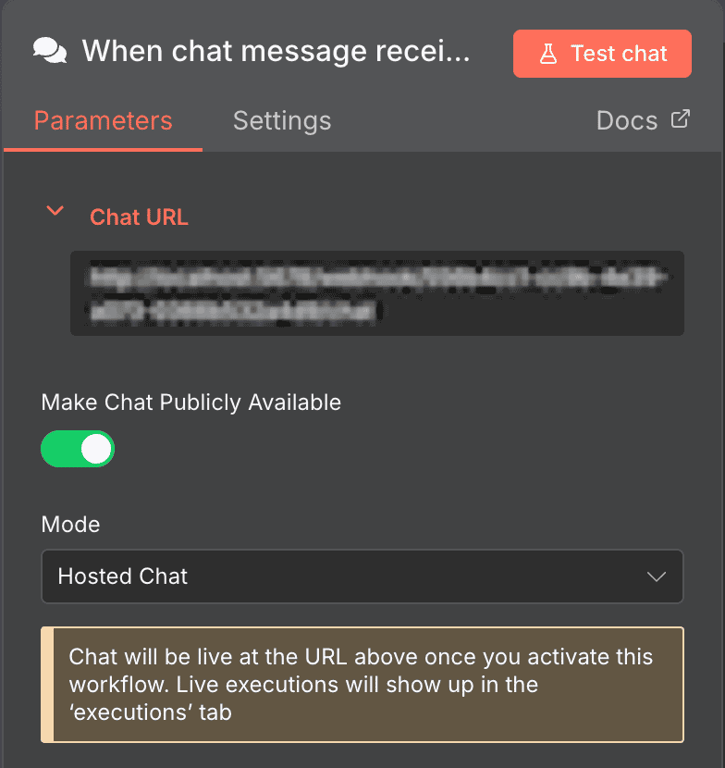

Per impostazione predefinita, il nodo Ollama Chat Model utilizza Chat message come trigger, che avvia il flusso di lavoro alla ricezione di un messaggio.

Il nodo Chat predefinito è ideale per sviluppare un chatbot. Per farlo funzionare, è sufficiente rendere pubblicamente disponibile l’interfaccia della chat.

Per farlo, apri il nodo Chat e fai click sull’interruttore Make Chat Publicly Available. Potrai quindi integrare questa funzionalità di chat nel tuo chatbot personalizzato con un’interfaccia utente dedicata.

Nodi trigger per app di messaggistica

n8n offre nodi trigger che ricevono input da applicazioni di messaggistica popolari come Telegram e WhatsApp. Sono adatti se vuoi creare un bot per questo tipo di piattaforme.

La configurazione di questi nodi è più complessa, perché richiede un account sviluppatore e chiavi di autenticazione per connettersi alle rispettive API. Consulta la documentazione ufficiale delle piattaforme per maggiori dettagli sulla configurazione.

Trigger Webhook

Il nodo Webhook avvia il flusso di lavoro quando l’URL del suo endpoint riceve una richiesta HTTP. È una soluzione adatta se vuoi attivare il chatbot tramite eventi diversi dall’invio diretto di un messaggio, ad esempio un click.

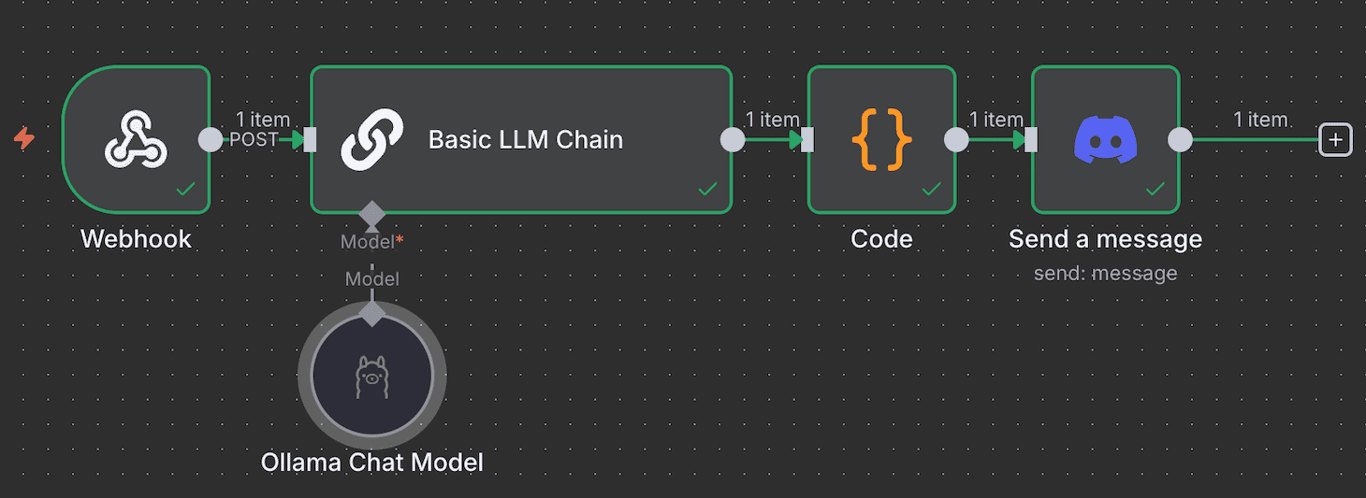

Nei passaggi seguenti useremo questo nodo per avviare il flusso di lavoro ogni volta che un chatbot Discord riceve un messaggio. Se vuoi seguire la procedura passo dopo passo, consulta prima la nostra guida su come integrare n8n con Discord per creare un bot Discord.

Importante! Se l’URL del webhook inizia con localhost, sostituiscilo con il dominio, l’hostname o l’indirizzo IP del tuo VPS. Puoi farlo modificando la variabile d’ambiente WEBHOOK_URL di n8n nel relativo file di configurazione.

Collegare il nodo Ollama consente al nodo trigger di inoltrare l’input dell’utente per l’elaborazione tramite il modello AI.

Il nodo Ollama Chat Model non si collega direttamente ai nodi trigger, ma si integra con un nodo AI. Quello predefinito è Basic LLM Chain, ma puoi utilizzare anche altri nodi Chain per scenari più complessi.

Alcuni nodi Chain supportano strumenti aggiuntivi per elaborare i dati. Ad esempio, il nodo AI Agent permette di aggiungere un parser per riformattare l’output o una memoria per memorizzare le risposte precedenti.

Per un chatbot che non richiede un’elaborazione avanzata dei dati, come il nostro esempio con Discord, il nodo Basic LLM Chain è sufficiente.

Collega quindi il nodo trigger al nodo Basic LLM Chain e definisci come passare l’input: usa Fixed per passare direttamente il messaggio come prompt, oppure seleziona Expression per utilizzare dati dinamici o manipolare l’input prima di inoltrarlo a Ollama.

Ad esempio, possiamo usare la seguente Expression per selezionare il campo JSON body.content come input, che varia in base ai messaggi inviati dagli utenti su Discord:

{{ $json.body.content }}Per consentire agli utenti di visualizzare la risposta generata dal nodo AI Agent o Basic LLM Chain, è necessario inoltrare l’output tramite un nodo appropriato. In questa fase, puoi visualizzare l’output solo nell’interfaccia chat o nel pannello di output del nodo.

Per inviare effettivamente la risposta, utilizza un nodo coerente con il trigger scelto. Ad esempio, se stai sviluppando un chatbot per WhatsApp, collega il nodo WhatsApp Send Message.

Se utilizzi il Chat trigger predefinito, puoi usare un nodo Webhook per inoltrare il messaggio al tuo bot personalizzato o alla tua interfaccia chatbot sviluppata su misura.

Nel nostro esempio, il flusso di lavoro del bot Discord utilizza il trigger Webhook, quindi possiamo usare un nodo compatibile anche per l’output. In alternativa, possiamo collegare il nodo Discord Send a Message per inviare direttamente la risposta tramite lo stesso bot. Il workflow completato avrà questa struttura:

n8n mette a disposizione diversi workflow pronti all’uso che puoi importare facilmente nel canvas. Questo ti permette di creare un sistema di automazione basato sull’AI senza dover sviluppare il flusso di lavoro da zero. Consulta il nostro tutorial sui migliori template n8n per scoprire flussi di lavoro selezionati e pronti all’uso per diversi casi d’uso.

Essendo uno degli strumenti di automazione AI più potenti, l’integrazione di n8n con gli LLM personalizzabili di Ollama ti consente di automatizzare un’ampia gamma di attività.

Ecco alcuni esempi di attività che puoi automatizzare con n8n e l’AI:

Ospitare i tuoi workflow n8n-Ollama su Hostinger offre diversi vantaggi rispetto all’utilizzo di una macchina personale o del piano di hosting ufficiale. Ecco alcuni dei principali benefici:

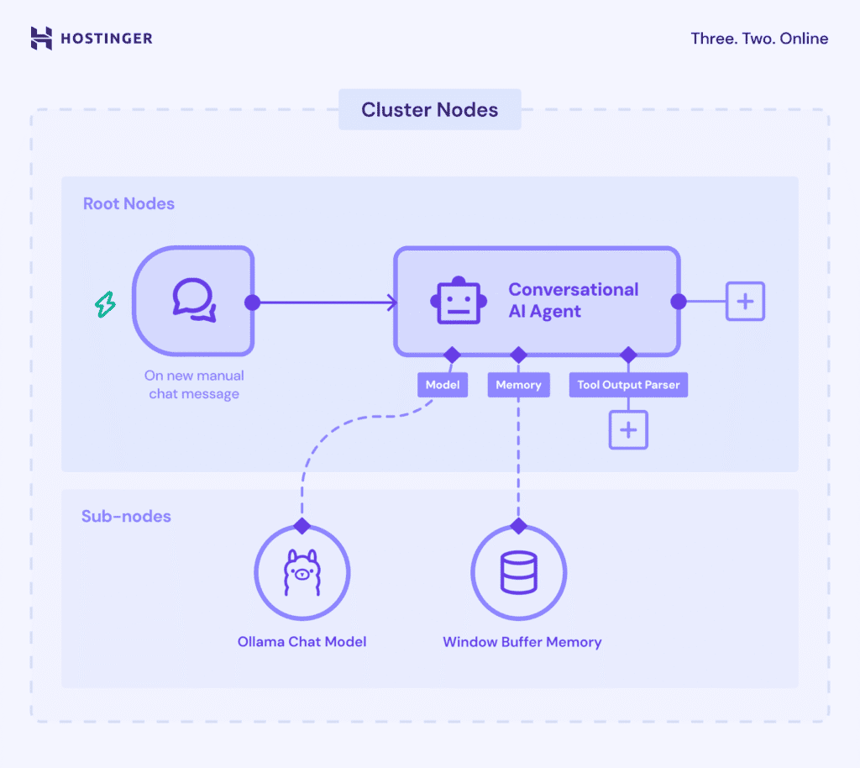

LangChain è un framework che facilita l’integrazione degli LLM nelle applicazioni. In n8n, questa implementazione prevede il collegamento di diversi nodi e modelli AI per ottenere funzionalità di elaborazione avanzate.

In n8n, la funzionalità LangChain utilizza i Cluster nodes, ovvero gruppi di nodi interconnessi che lavorano insieme per fornire funzionalità specifiche nel workflow.

I Cluster Node sono composti da due parti: i Root Node, che definiscono la funzionalità principale, e i Sub-node, che aggiungono capacità LLM o funzionalità aggiuntive.

La parte centrale dell’implementazione di LangChain in n8n è la Chain all’interno dei root nodes. Essa combina e configura la logica dei diversi componenti AI, come il modello Ollama e il nodo parser, per creare un sistema coerente.

Ecco le principali Chains disponibili in n8n e le relative funzioni:

Durante la creazione di un workflow in n8n, potresti incontrare anche gli Agents, sottoinsiemi delle Chains con capacità decisionali. Mentre le Chains operano seguendo regole predefinite, un Agent utilizza l’LLM collegato per determinare dinamicamente le azioni successive.

Con l’evoluzione costante delle tecnologie di automazione, implementare un sistema di elaborazione automatica dei dati ti aiuta a restare competitivo. In combinazione con l’AI, puoi sviluppare soluzioni che portano la gestione e lo sviluppo dei tuoi progetti a un livello superiore.

Integrare Ollama nel tuo workflow n8n significa abilitare un sistema di automazione AI che va oltre le funzionalità dei nodi standard. Inoltre, la compatibilità di Ollama con diversi LLM ti consente di scegliere e personalizzare i modelli più adatti alle tue esigenze.

Comprendere come collegare Ollama a n8n è solo il primo passo verso l’implementazione di un sistema di automazione AI nel tuo progetto. Vista l’ampia varietà di casi d’uso possibili, il passo successivo è sperimentare e sviluppare un workflow su misura per i tuoi obiettivi.

Se è la prima volta che utilizzi n8n o Ollama, Hostinger rappresenta un ottimo punto di partenza. Oltre a piani VPS completi e scalabili, offriamo un catalogo dettagliato di tutorial su n8n per accompagnarti nel tuo percorso di automazione.

Tutti i contenuti dei tutorial presenti su questo sito web sono soggetti ai rigorosi standard editoriali e ai valori di Hostinger.