Feb 04, 2026

Bruno S.

7min Ler

Como uma ferramenta poderosa para executar grandes modelos de linguagem (LLMs) localmente, o Ollama dá a desenvolvedores, cientistas de dados e usuários técnicos mais controle e flexibilidade para personalizar modelos.

Embora você possa usar o Ollama com interfaces gráficas de terceiros, como o Open WebUI, para interações mais simples, rodar a ferramenta pela interface de linha de comando (CLI) permite registrar respostas em arquivos e automatizar fluxos de trabalho com scripts.

Este guia vai mostrar como usar o Ollama via CLI – desde os comandos básicos e a interação com modelos até a automação de tarefas e a criação dos seus próprios modelos. Ao final, você vai conseguir adaptar o Ollama aos seus projetos com IA.

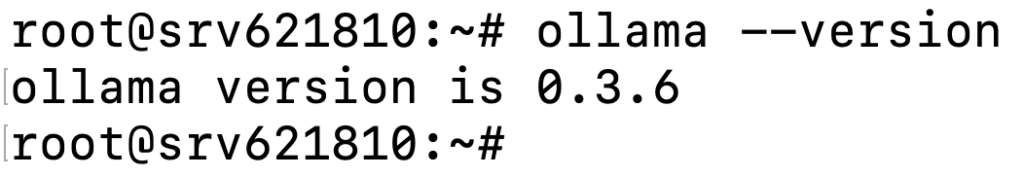

Antes de usar o Ollama na CLI, confirme que ele foi instalado corretamente no seu sistema. Para isso, abra o terminal e execute o comando abaixo:

ollama --version

Você deve ver uma saída parecida com esta:

Em seguida, vale conhecer os comandos essenciais do Ollama:

| Comando | Descrição |

|---|---|

ollama serve | Inicia o Ollama no seu sistema local. |

ollama create <novo_modelo> | Cria um novo modelo a partir de um existente, para personalização ou treinamento. |

ollama show <modelo> | Exibe detalhes de um modelo específico, como configuração e data de lançamento. |

ollama run <modelo> | Executa o modelo escolhido e o deixa pronto para uso. |

ollama pull <modelo> | Baixa o modelo especificado para o seu sistema. |

ollama list | Lista todos os modelos baixados. |

ollama ps | Mostra os modelos que estão rodando no momento. |

ollama stop <modelo> | Para a execução do modelo indicado. |

ollama rm <modelo> | Remove o modelo indicado do seu sistema. |

Esta seção mostra os principais usos do Ollama na CLI, desde interagir com modelos até salvar respostas em arquivos.

Para começar a usar modelos no Ollama, primeiro você precisa baixar o modelo desejado com o comando pull. Por exemplo, para baixar o Llama 3.2, execute:

ollama pull llama3.2

Aguarde o download terminar – o tempo pode variar conforme o tamanho do arquivo do modelo.

Se você não tiver certeza de qual modelo baixar, confira a biblioteca oficial de modelos do Ollama. Ela mostra detalhes importantes, como opções de personalização, suporte a idiomas e casos de uso recomendados.

Depois de baixar o modelo, você pode executá-lo com um prompt já definido, como neste exemplo:

ollama run llama3.2 "Explique os conceitos básicos de machine learning."

Aqui está o tipo de saída que você deve ver:

Como alternativa, você pode iniciar o modelo sem um prompt para abrir uma sessão interativa:

ollama run llama3.2

Nesse modo, você pode digitar suas perguntas ou instruções, e o modelo vai gerar as respostas. Também dá para fazer perguntas de acompanhamento para aprofundar o assunto ou esclarecer algo que ele respondeu antes, como:

Você pode explicar melhor como o machine learning é usado na área da saúde?

Quando terminar a sessão, digite:

/bye

Isso encerra a interação e te leva de volta ao terminal normal.

Aprenda a criar prompts de IA mais eficientes para melhorar seus resultados e suas interações com modelos do Ollama.

Embora modelos open source pré-treinados como o Llama 3.2 funcionem bem para tarefas gerais, como geração de conteúdo, eles nem sempre atendem às necessidades de casos de uso mais específicos. Para melhorar a precisão do modelo em um assunto específico, você precisa treiná-lo com dados relevantes.

No entanto, vale lembrar que esses modelos têm limitações de memória de curto prazo. Isso significa que os dados de treinamento só ficam disponíveis durante a conversa ativa. Quando você encerra a sessão e inicia outra, o modelo não vai se lembrar das informações que você ensinou anteriormente.

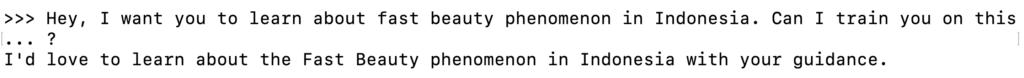

Para treinar o modelo, inicie uma sessão interativa. Em seguida, comece o treinamento digitando um prompt como:

Oi, eu quero que você aprenda sobre [tópico]. Posso te treinar sobre isso?

O modelo vai responder com algo parecido com:

Depois, você pode fornecer informações básicas sobre o tópico para ajudar o modelo a entender melhor:

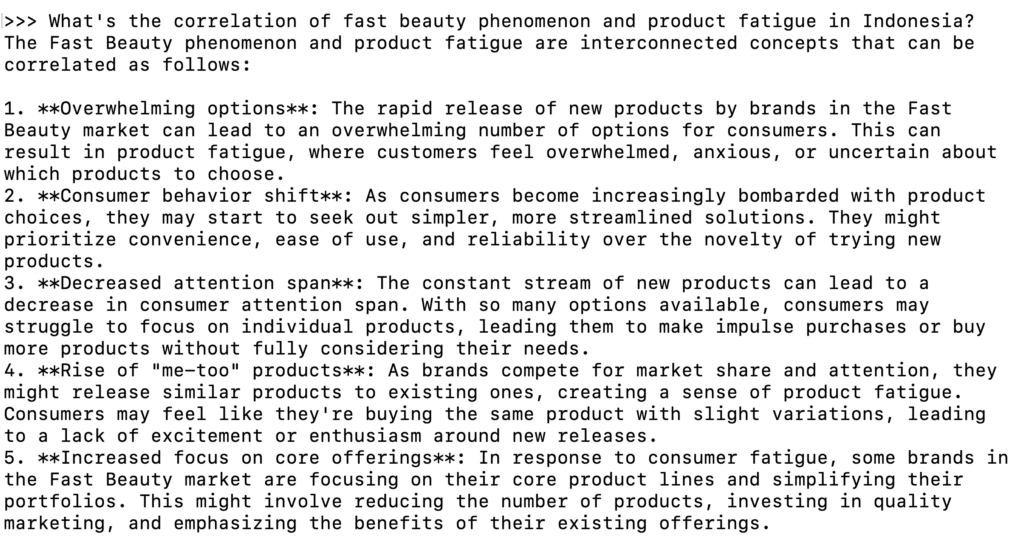

Para continuar o treinamento e passar mais informações, peça para o modelo te fazer perguntas sobre o assunto. Por exemplo:

Você pode me fazer algumas perguntas sobre [tópico] para entender melhor?

Quando o modelo já tiver contexto suficiente, você pode encerrar o treinamento e testar se ele consegue usar esse conhecimento.

No Ollama, você pode pedir para o modelo executar tarefas usando o conteúdo de um arquivo, como resumir um texto ou analisar informações. Isso é especialmente útil para documentos longos, pois elimina a necessidade de copiar e colar o texto sempre que você quiser dar uma instrução ao modelo.

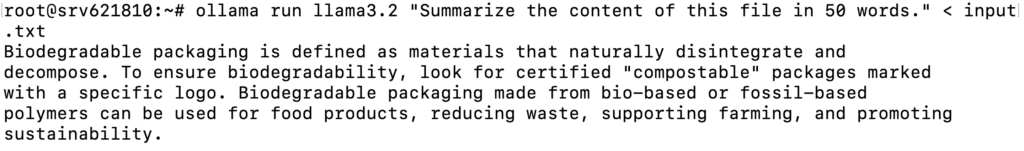

Por exemplo, se você tiver um arquivo chamado input.txt com as informações que deseja resumir, execute o comando abaixo:

ollama run llama3.2 "Resuma o conteúdo deste arquivo em 50 palavras." < input.txt

O modelo vai ler o conteúdo do arquivo e gerar um resumo:

O Ollama também permite salvar as respostas do modelo em um arquivo, o que facilita revisar ou ajustar o conteúdo depois. Veja um exemplo em que você faz uma pergunta e salva a saída em um arquivo:

ollama run llama3.2 "Me conte sobre energia renovável." > output.txt

Isso vai salvar a resposta do modelo em output.txt:

Agora que você já entendeu o básico, vamos explorar usos mais avançados do Ollama pelo terminal.

Ao rodar o Ollama via CLI, você pode criar um modelo personalizado de acordo com as suas necessidades.

Para isso, você vai criar um Modelfile, que funciona como o “molde” do seu modelo. Esse arquivo define configurações como o modelo base, parâmetros de ajuste e como o modelo deve responder aos prompts.

Veja o passo a passo para criar um modelo personalizado no Ollama:

1. Crie um novo Modelfile

Use um editor de texto como o nano para criar um novo Modelfile. Neste exemplo, vamos chamar o arquivo de custom-modelfile:

nano custom-modelfile

Depois, copie e cole este template básico de Modelfile (você vai personalizar no próximo passo):

# Use o Llama 3.2 como modelo base

FROM llama3.2

# Ajuste os parâmetros do modelo

PARAMETER temperature 0.7

PARAMETER num_ctx 3072

PARAMETER stop "assistant:"

# Defina o comportamento do modelo

SYSTEM "Você é um especialista em cibersegurança."

# Personalize o template da conversa

TEMPLATE """{{ if .System }}Consultor: {{ .System }}{{ end }}

Cliente: {{ .Prompt }}

Consultor: {{ .Response }}"""2. Personalize o Modelfile

Aqui estão os principais elementos que você pode ajustar no Modelfile:

FROM llama3.2

PARAMETER temperature 0.9

PARAMETER num_ctx 4096

SYSTEM "Você é um especialista em cibersegurança. Responda apenas perguntas relacionadas a cibersegurança. Se perguntarem algo fora desse tema, responda: 'Eu só respondo perguntas relacionadas a cibersegurança.'"

TEMPLATE """{{ if .System }}<|start|>system

{{ .System }}<|end|>{{ end }}

<|start|>user

{{ .Prompt }}<|end|>

<|start|>assistant

"""Depois de fazer os ajustes necessários, salve o arquivo e saia do nano pressionando Ctrl + X → Y → Enter.

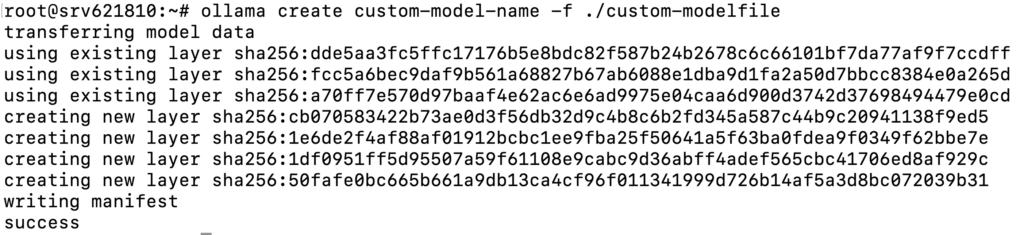

3. Crie e execute o modelo personalizado

Com o Modelfile pronto, use o comando abaixo para criar um modelo baseado nesse arquivo:

ollama create custom-model-name -f ./custom-modelfile

Você verá uma saída indicando que o modelo foi criado com sucesso:

Depois disso, execute o modelo como qualquer outro:

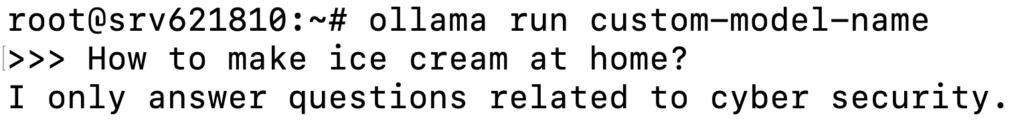

ollama run custom-model-name

Isso inicia o modelo com as personalizações aplicadas e você pode interagir normalmente:

Você pode ajustar e refinar o Modelfile sempre que quiser, alterando parâmetros, editando mensagens do sistema, adicionando templates mais avançados ou até incluindo seus próprios datasets. Depois, salve as mudanças e rode o modelo novamente para ver o resultado.

Automatizar tarefas repetitivas no Ollama pode economizar tempo e manter a consistência do seu fluxo de trabalho. Com scripts em bash, você consegue executar comandos automaticamente. Já com cron jobs, dá para agendar tarefas para rodarem em horários específicos. Veja como começar:

Criar e executar scripts em bash

Você pode criar um script em bash que executa comandos do Ollama. Veja como:

nano ollama-script.sh

#!/bin/bash # Execute o modelo e salve a saída em um arquivo ollama run llama3.2 "Quais são as tendências mais recentes em IA?" > ai-output.txt

chmod +x ollama-script.sh

./ollama-script.sh

Configurar cron jobs para automatizar tarefas

Você pode combinar seu script com um cron job para automatizar tarefas como executar modelos regularmente. Veja como configurar um cron job para rodar scripts do Ollama automaticamente:

crontab -e

0 0 * * 0 /path/to/ollama-script.sh

Aqui vão alguns exemplos reais de como usar a CLI do Ollama.

Geração de texto

Você pode usar modelos pré-treinados para criar resumos, gerar conteúdo ou responder perguntas específicas.

ollama run llama3.2 "Resuma o texto a seguir:" < documento-longo.txt

ollama run llama3.2 "Escreva um artigo curto sobre os benefícios de usar IA na área da saúde." > artigo.txt

ollama run llama3.2 "Quais são as tendências mais recentes em IA e como elas vão impactar a área da saúde?"

Processamento, análise e previsão de dados

O Ollama também permite lidar com tarefas de processamento de dados, como classificação de texto, análise de sentimento e previsões.

ollama run llama3.2 "Analise o sentimento desta avaliação de cliente: 'O produto é fantástico, mas a entrega foi lenta.'"

ollama run llama3.2 "Classifique este texto nas seguintes categorias: Notícia, Opinião ou Review." < arquivo-de-texto.txt

ollama run llama3.2 "Preveja a tendência do preço da ação para o próximo mês com base nos seguintes dados:" < dados-de-acao.txt

Integração com ferramentas externas

Outro uso comum da CLI do Ollama é combiná-la com ferramentas externas para automatizar o processamento de dados e ampliar as capacidades de outros programas.

curl -X GET "https://api.example.com/data" | ollama run llama3.2 "Analise os dados da API a seguir e resuma os principais insights."

import subprocess

result = subprocess.run(

['ollama', 'run', 'llama3.2', 'Me diga as tendências mais recentes do mercado de ações'],

capture_output=True

)

print(result.stdout.decode())

Neste artigo, você aprendeu o essencial para usar o Ollama via CLI, incluindo executar comandos, interagir com modelos e salvar respostas em arquivos.

Ao trabalhar pelo terminal, você também consegue fazer tarefas mais avançadas, como criar novos modelos a partir de modelos existentes, automatizar fluxos de trabalho com scripts e cron jobs e integrar o Ollama com ferramentas externas.

Agora, vale explorar as opções de personalização do Ollama para aproveitar todo o potencial da ferramenta e evoluir seus projetos com IA. Se você tiver dúvidas ou quiser compartilhar sua experiência usando o Ollama na CLI, deixe um comentário abaixo.

Com a versão CLI do Ollama, você pode executar modelos, gerar texto, fazer tarefas de processamento de dados (como análise de sentimento), automatizar fluxos com scripts, criar modelos personalizados e integrar o Ollama com ferramentas externas ou APIs para usos mais avançados.

Para instalar modelos via CLI, primeiro confirme que o Ollama está instalado no seu sistema. Depois, use o comando u003cstrongu003eollama pull u003c/strongu003eseguido do nome do modelo. Por exemplo, para instalar o Llama u003cstrongu003e3.2u003c/strongu003e, execute: u003cstrongu003eollama pull llama3.2u003c/strongu003e

Embora seja tecnicamente possível usar modelos multimodais como o LLaVA na CLI do Ollama, isso não é tão prático, já que o terminal é otimizado para tarefas em texto. Para trabalhos com imagens, o mais indicado é u003ca href=u0022/br/tutoriais/tutorial-ollama-guiu0022u003eusar o Ollama com uma interface gráfica (GUI)u003c/au003e.

Todo o conteúdo dos tutoriais deste site segue os rigorosos padrões editoriais e valores da Hostinger.