May 06, 2025

Faradilla A.

4menit Dibaca

Ollama cocok untuk menjalankan large language model (LLM) secara lokal dengan aman, meningkatkan privasi data serta menghemat biaya karena Anda tidak harus menggunakan cloud. Tool ini ideal bagi industri yang perlu menjaga kerahasiaan data, seperti layanan kesehatan dan keuangan, serta mendukung kebutuhan spesifik.

Di artikel ini, kami akan menjelaskan cara instal Ollama dengan mudah, mulai dari mendownload paket penginstalannya dari GitHub, menginstalnya di VPS, hingga mengonfigurasinya tanpa masalah.

Selain itu, kami akan membocorkan metode penginstalan yang jauh lebih praktis kalau Anda menggunakan Hostinger. Sudah penasaran? Yuk, simak tutorialnya di bawah ini!

Ollama adalah platform open-source yang bisa Anda gunakan untuk menjalankan LLM kustom secara lokal di sistem Anda. Platform ini mendukung berbagai LLM populer, seperti Llama 2, GPT-3.5, dan Mistral.

Dengan mengintegrasikan AI secara lokal pada aplikasi Anda, Ollama meningkatkan keamanan data dan privasi Anda, serta membantu Anda mengontrol berbagai aspek performa model ini secara lebih fleksibel.

Sebagai contoh, Anda bisa mengelola bobot model, konfigurasi, dan dataset melalui tampilan yang mudah digunakan. Anda pun bisa menyesuaikan berbagai model bahasa dengan kebutuhan spesifik Anda, yang biasanya sangat diperlukan oleh developer yang suka bereksperimen dengan AI.

Namun, apabila ingin mengintegrasikan Ollama dengan aplikasi web Anda tanpa bergantung pada API pihak ketiga, Anda perlu menyiapkannya dulu di sistem hosting Anda.

Sebelum memulai prosesnya, ada beberapa hal yang perlu Anda siapkan untuk menginstal Ollama di VPS. Mari kita bahas satu per satu.

VPS Hosting

Untuk menjalankan Ollama dengan baik, Anda memerlukan VPS (virtual private server) dengan RAM minimal 16 GB, ruang penyimpanan hard disk lebih dari 12 GB, dan 4 hingga 8 core CPU.

Perlu diingat bahwa spesifikasi di atas hanyalah persyaratan hardware minimum. Untuk hasil yang lebih optimal, Anda membutuhkan resource yang lebih besar, terutama kalau menggunakan model yang memiliki lebih banyak parameter.

Sistem operasi

Ollama dirancang untuk berjalan di sistem Linux. Agar hasilnya maksimal, pastikan sistem hosting Anda menggunakan Ubuntu 22.04 atau yang lebih tinggi, atau versi stabil terbaru Debian.

Akses dan hak istimewa

Untuk menginstal dan mengonfigurasikan Ollama, Anda memerlukan akses ke terminal atau command-line interface di VPS Anda. Pastikan Anda memiliki akses root atau akun dengan hak istimewa sudo pada Linux.

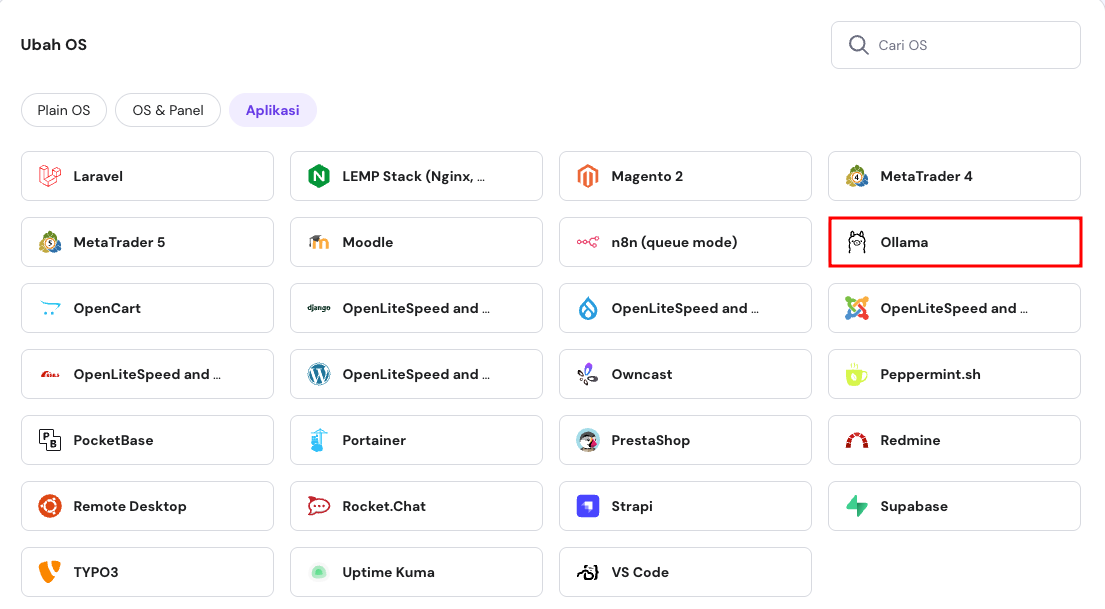

Setelah selesai dengan persiapan awalnya, mari lanjutkan ke cara instal Ollama dengan mudah di VPS menggunakan template siap pakai dari Hostinger.

Hostinger menyediakan cara yang sangat praktis bagi Anda untuk menginstal Ollama dengan template VPS Ubuntu 24.04 yang sudah dikonfigurasi sejak awal, hanya dengan biaya Rp77900.00/bulan.

Template ini menyertakan Ollama, Llama 3, dan Open WebUI yang sudah terinstal. Anda cukup memilih template, menunggu auto-installer menyelesaikan prosesnya, lalu login ke server untuk memverifikasi penginstalannya. Mudah, kan?

Begini cara kerjanya:

Selesai! Sekarang Anda siap untuk mulai menggunakan Ollama di VPS Hostinger untuk menjalankan aplikasi web Anda.

Karena template kami sudah menyertakan semua tool dan software yang diperlukan, Anda tidak perlu melakukan tindakan manual apa pun untuk mulai memanfaatkan LLM dari Ollama.

Apabila ingin menjalankan Ollama di VPS dari provider hosting lain, Anda bisa mengikuti cara instal Ollama secara manual berikut ini. Prosesnya akan lebih rumit daripada menggunakan template siap pakai, jadi kami akan memandu Anda langkah demi langkah.

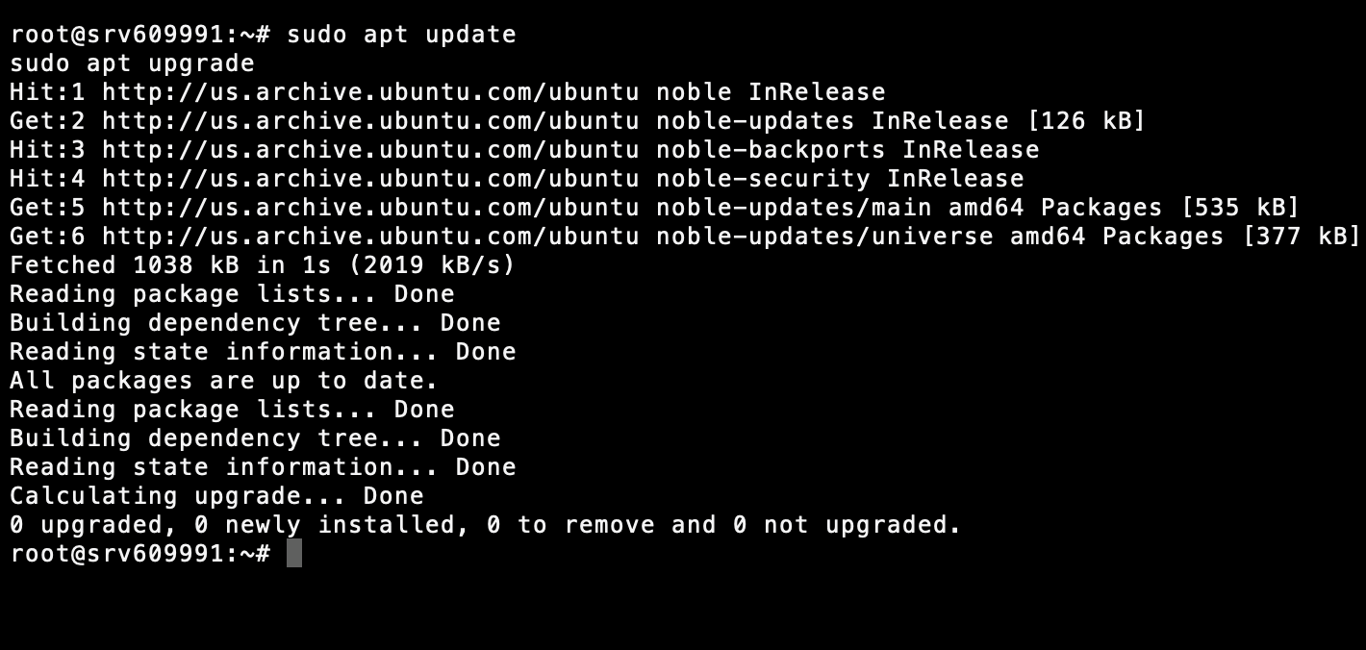

Sebelum menginstal software baru, pastikan VPS Anda sudah diupdate. Untuk mengupdate daftar package dan mengupgrade package penginstalan, jalankan perintah di bawah ini menggunakan command-line server Anda:

sudo apt update sudo apt upgrade

Dengan melakukan langkah ini, Anda akan terhindar dari masalah kompatibilitas dan memastikan penginstalan yang lancar dari awal hingga akhir.

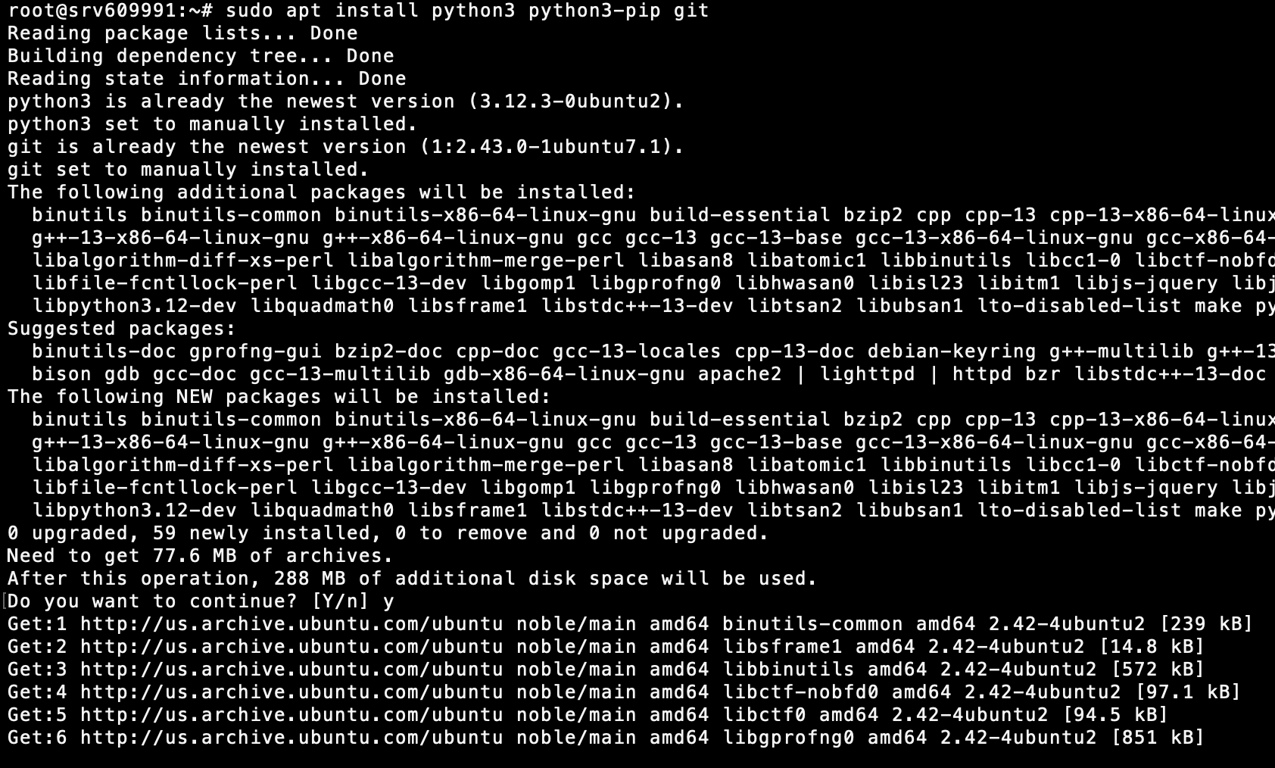

Ollama membutuhkan dependensi tertentu agar bisa berjalan lancar, termasuk versi terbaru Python, Pip, dan Git. Untuk menginstalnya, jalankan perintah berikut:

sudo apt install python3 python3-pip git

Verifikasikan bahwa penginstalan telah berhasil diselesaikan dengan menjalankan:

python3 --version pip3 --version git --version

Apabila VPS Anda menggunakan GPU NVIDIA, Anda membutuhkan driver CUDA tambahan untuk memaksimalkan performanya. Namun, langkah-langkahnya akan berbeda-beda tergantung pada konfigurasi server Anda.

Pelajari lebih lanjut dengan membaca panduan resmi NVIDIA untuk mendownload CUDA Toolkit.

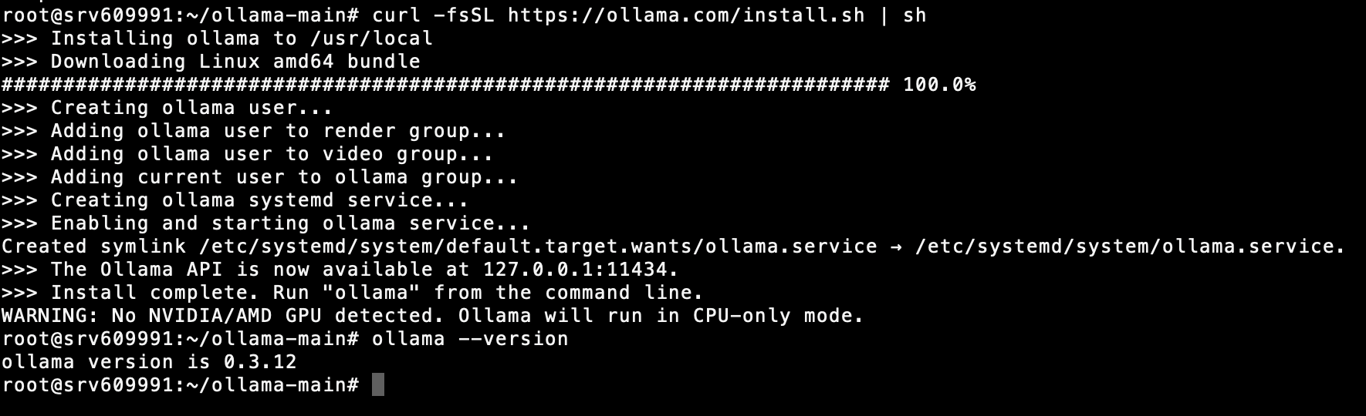

Selanjutnya, download paket penginstalan Ollama untuk Linux dari website resminya. Anda bisa melakukan langkah ini dengan menjalankan perintah berikut:

curl -fsSL https://ollama.com/install.sh | sh

Ollama akan didownload dan diinstal pada VPS Anda. Setelah prosesnya selesai, verifikasikan penginstalan dengan menjalankan:

ollama --version

Sekarang, Anda seharusnya sudah bisa menjalankan Ollama dengan menggunakan perintah berikut:

ollama serve

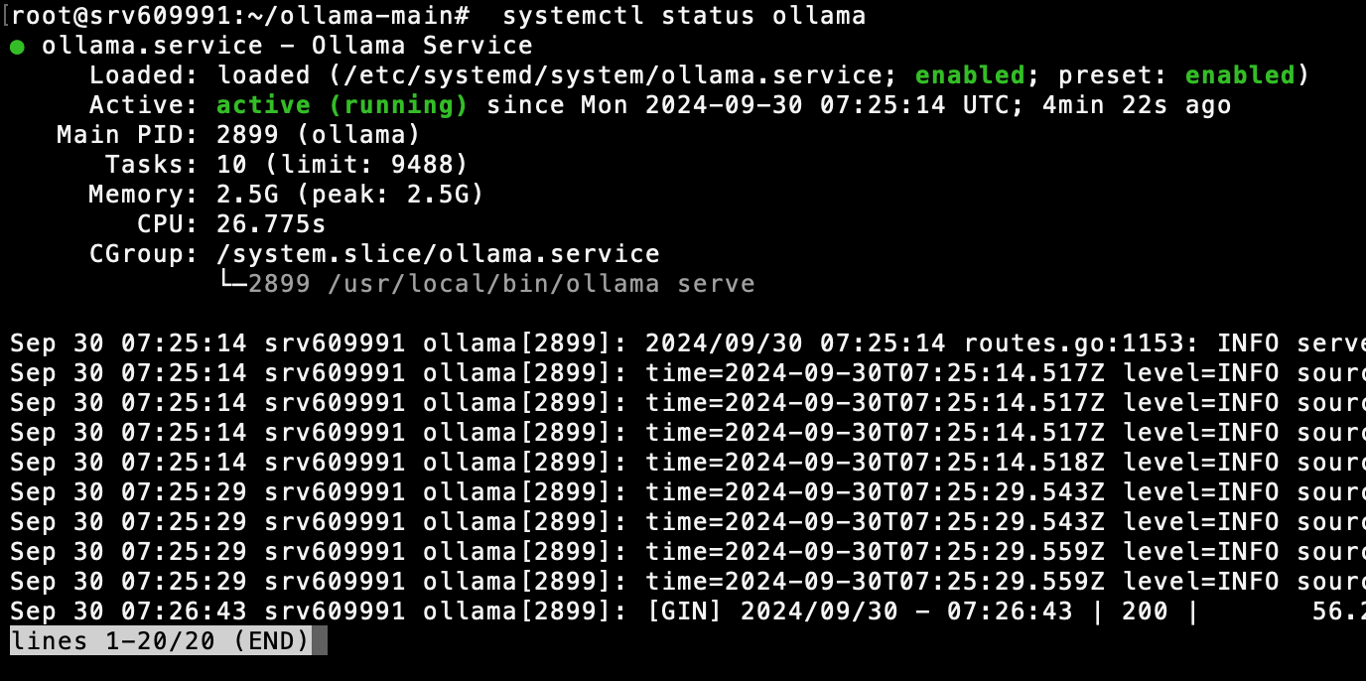

Sebelum lanjut ke langkah berikutnya, cek status layanan Ollama saat ini dengan menjalankan perintah di bawah ini melalui CLI Anda:

systemctl status ollama

Apabila menggunakan VPS Hostinger, Anda juga bisa memanfaatkan AI Assistant kami, Kodee, untuk mengonfirmasi apakah Ollama sudah berjalan di server Anda.

Dari dashboard VPS, buka menu Kodee melalui sidebar kiri. Kemudian, masukkan prompt Anda, seperti “Cek apakah Ollama sudah berjalan di server saya”

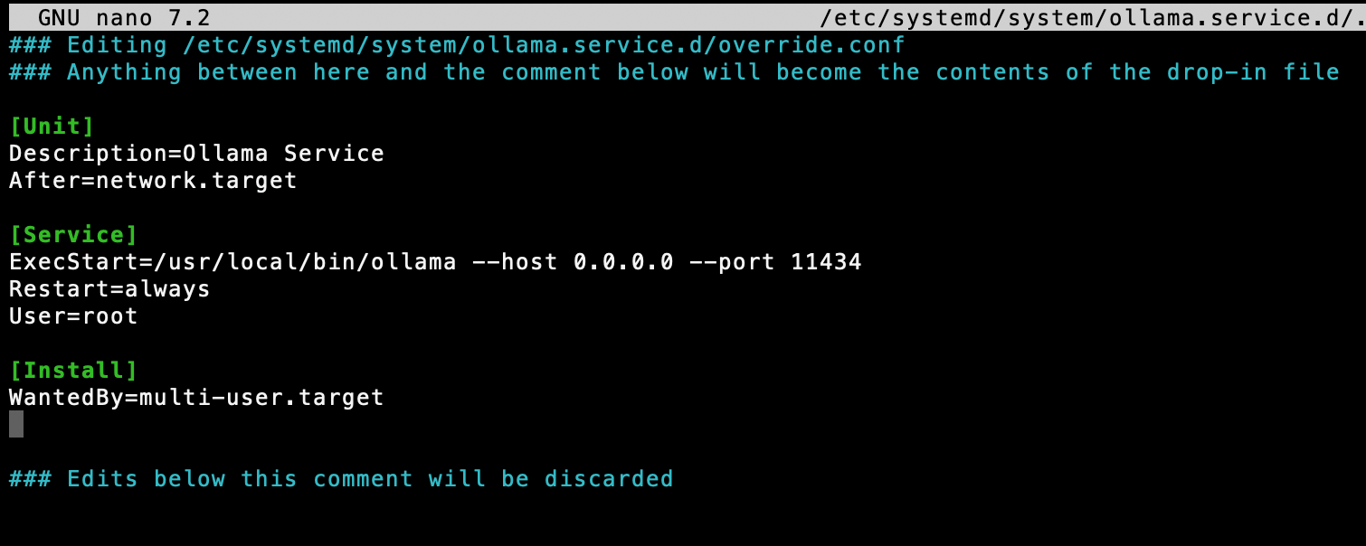

Selanjutnya, buat file layanan systemd agar Ollama bisa berjalan secara otomatis setiap kali Anda memulai (boot) VPS:

sudo nano /etc/systemd/system/ollama.service

Tambahkan skrip berikut ini ke file layanan systemd Anda:

[Unit] Description=Ollama Service After=network.target [Service] ExecStart=/usr/local/bin/ollama --host 0.0.0.0 --port 11434 Restart=always User=root [Install] WantedBy=multi-user.target

Kemudian, gunakan perintah berikut ini untuk memuat ulang sistem:

systemctl daemon-reload systemctl restart ollama

Selesai! Ollama pun akan diluncurkan secara otomatis pada saat Anda memulai VPS.

Perlu diingat, meskipun Ollama menyediakan banyak opsi konfigurasi untuk memodifikasi perilaku model, menyelaraskan performa, dan mengubah pengaturan server, platform ini dirancang agar sudah siap digunakan dengan konfigurasi default.

Konfigurasi default ini sudah cukup untuk sebagian besar skenario sehingga Anda bisa langsung menggunakannya dengan mengambil file model yang dibutuhkan. Caranya, cukup jalankan perintah “ollama pull <nama_model>”.

Setelah berhasil menginstal Ollama di VPS, Anda bisa mengakses berbagai tool untuk menyempurnakan LLM pilihan Anda sebelum menjalankannya secara lokal di server. Platform ini memudahkan pekerjaan sehari-hari para developer, peneliti, hingga para penggemar AI.

Beberapa contoh penggunaan Ollama yang paling umum adalah untuk membuat chatbot dan asisten virtual khusus guna melayani kebutuhan spesifik.

Misalnya, Anda bisa merancang asisten coding sendiri untuk membantu Anda membuat aplikasi web dan seluler, brainstorming proyek-proyek terkait desain, atau menemukan peluang penggunaan LLM dalam strategi dan pembuatan konten.

Semua konten tutorial di website ini telah melalui peninjauan menyeluruh sesuai standar dan komitmen editorial Hostinger.