Dec 18, 2025

Faradilla A.

7menit Dibaca

Secara default, Ollama menjalankan large language model (LLM) melalui command-line interface (CLI). Namun, Anda bisa berinteraksi dengannya secara visual melalui GUI (graphical user interface) dengan memadukan Ollama dan Open WebUI.

Dengan konfigurasi ini, Anda tidak perlu menggunakan command-line yang rumit, cocok bagi pengguna non-teknis dan tim yang membutuhkan tampilan visual untuk bekerja dengan LLM serta men-deploy aplikasi AI.

Di artikel ini, Anda akan mempelajari tutorial setting Ollama GUI dan Open WebUI dalam cara yang paling praktis, yaitu menggunakan template VPS siap pakai. Kami juga akan menjelaskan cara menggunakan dashboard Open WebUI, memandu Anda menyesuaikan outputnya dan memahami fitur-fiturnya.

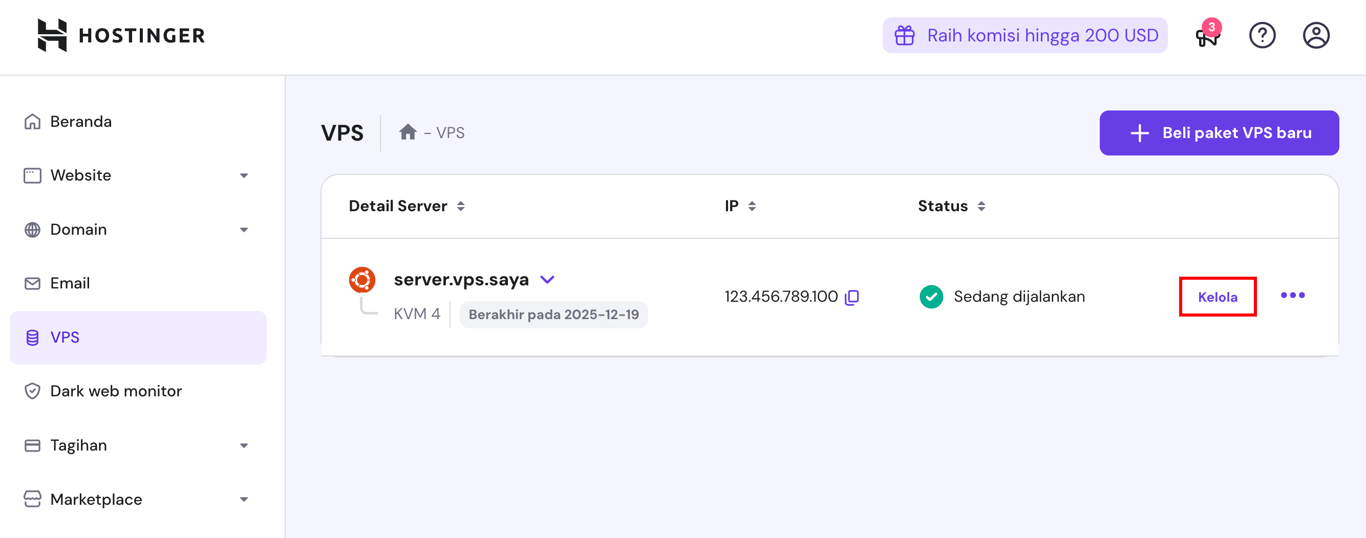

Sejauh ini, cara termudah untuk menggunakan Ollama dengan Open WebUI adalah dengan memilih paket VPS hosting dari Hostinger.

Berdasarkan persyaratan sistem Ollama, kami merekomendasikan paket KVM 4, yang menyediakan 4 vCPU core, RAM 16 GB, dan penyimpanan NVMe 200 GB dengan harga Rp145900.00/bulan. Dengan semua resource ini, proyek Anda dijamin berjalan dengan lancar.

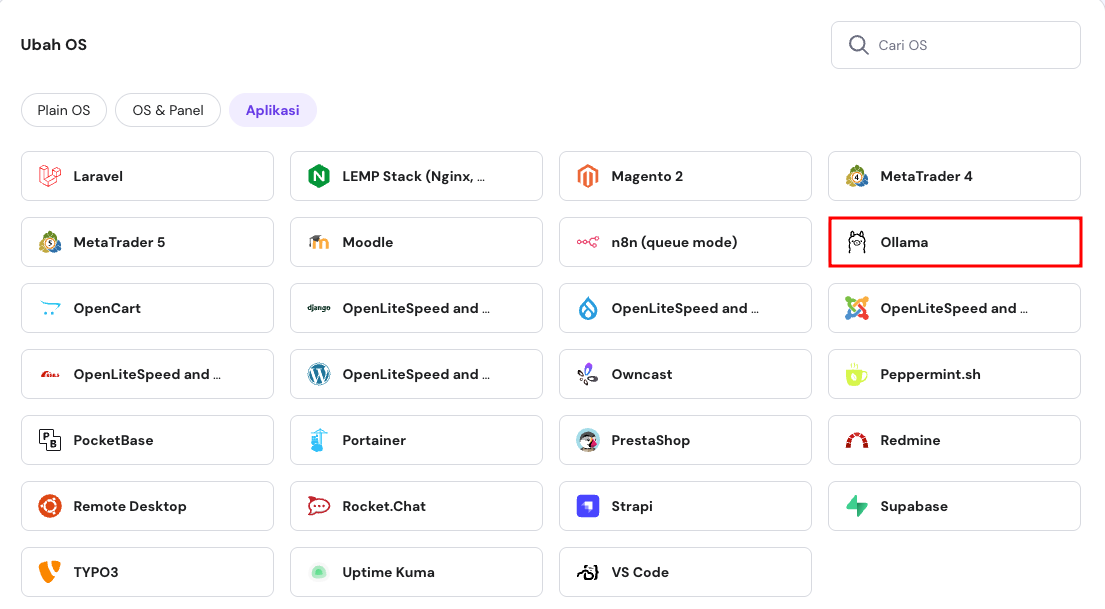

Setelah membeli paket, Anda bisa menginstal Ollama sebagai template dengan mengikuti langkah-langkah berikut:

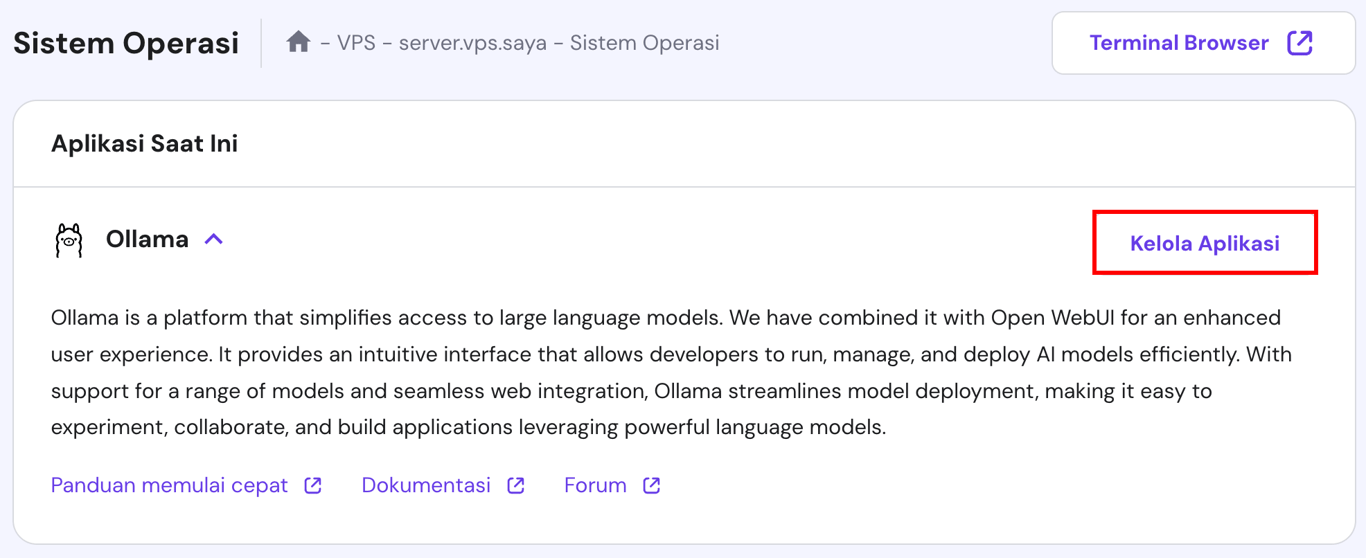

Tunggu sekitar 10 menit hingga proses penginstalan selesai. Setelah itu, scroll ke atas dan klik Kelola Aplikasi untuk mengakses Open WebUI.

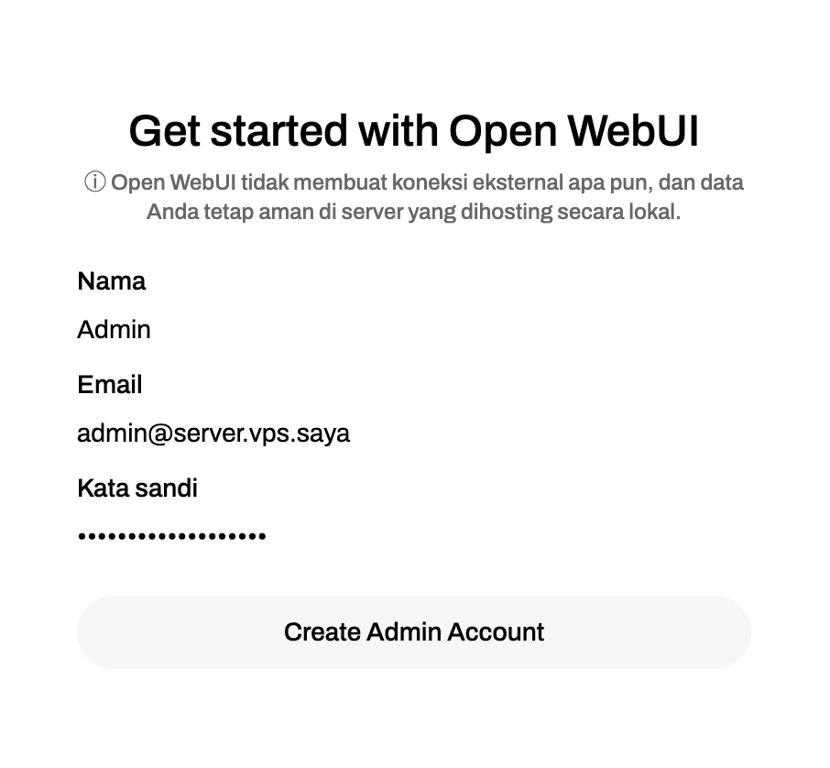

Pada kunjungan pertama, Anda akan diminta untuk membuat akun Open WebUI. Ikuti petunjuk di layar dan simpan kredensial Anda untuk mengaksesnya lagi nanti.

Bagian ini akan menjelaskan fitur-fitur Open WebUI untuk membantu Anda memahaminya, mulai dari menelusuri dashboard hingga menangani model multimodal.

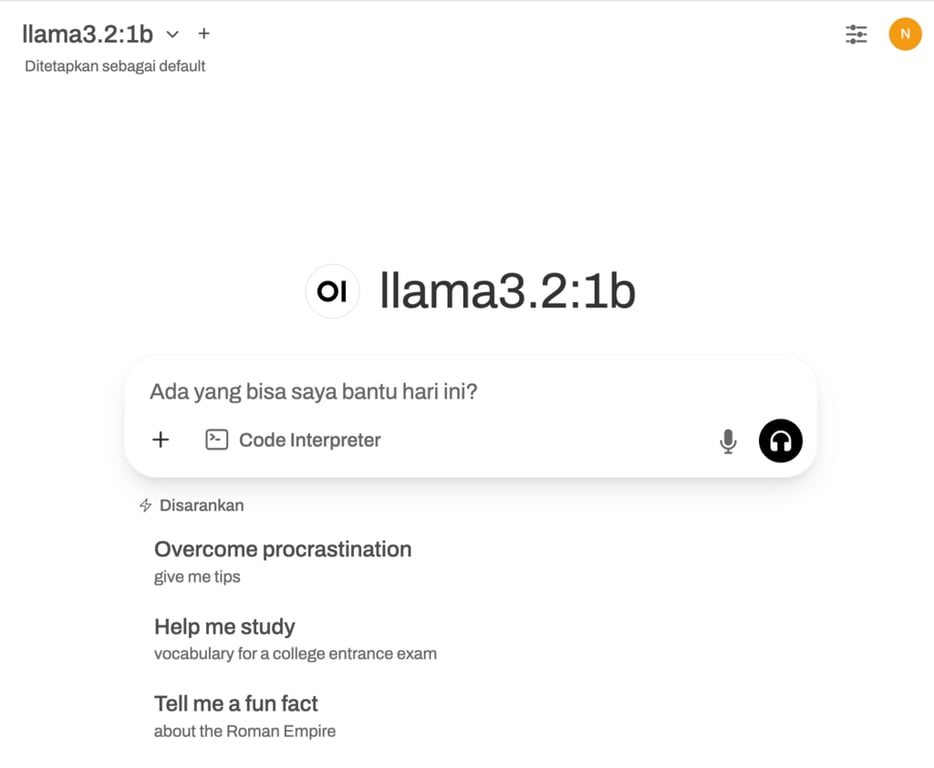

Dashboard Open WebUI menyediakan tampilan yang intuitif dan mudah bagi pemula. Apabila sudah terbiasa dengan ChatGPT, Anda pasti langsung bisa menggunakan Open WebUI karena tampilannya mirip.

Dashboard tool ini dibagi menjadi dua area utama:

Karena Anda sudah menginstal Ollama dan Open WebUI menggunakan template Hostinger, Anda siap menggunakan model Llama 3.1. Namun, Anda bisa mendownload model bahasa lain melalui panel pemilihan model di sudut kiri atas panel data Anda.

Di sini, tambahkan model dengan mengetikkan namanya di kolom pencarian, lalu klik Tarik [model] dari Ollama.com. Apabila tidak yakin model mana yang akan digunakan, kunjungi library model Ollama untuk mendapatkan informasi lebih lanjut dan penggunaan yang direkomendasikan.

![Opsi “Tarik [model] dari Ollama.com” di panel pemilihan model Open WebUI](https://imagedelivery.net/LqiWLm-3MGbYHtFuUbcBtA/wp-content/uploads/sites/37/2025/05/tarik-mistral-ollama.png/public)

Beberapa opsi populer termasuk Mistral, yang dikenal berkat efisiensi dan performanya dalam menerjemahkan dan meringkas teks, serta Code Llama yang disukai karena kemampuannya untuk coding dan hal-hal terkait pemrograman.

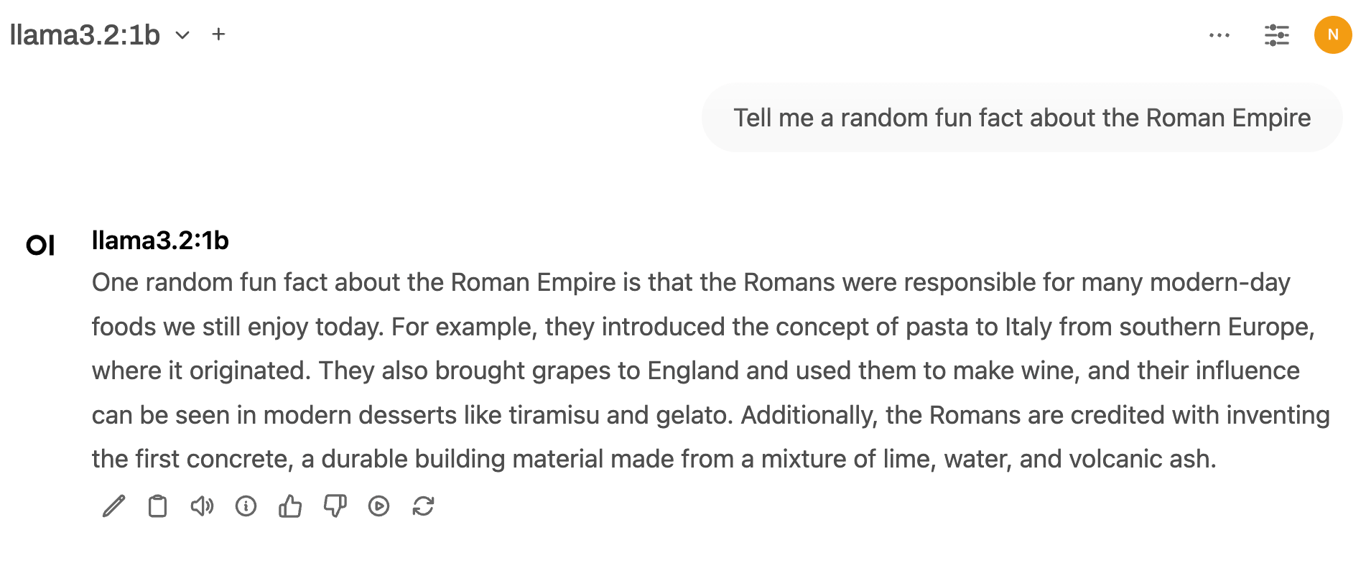

Setelah download selesai, mulai percakapan baru dengan mengklik New Chat. Pilih model dan ketik prompt Anda, lalu model ini akan memberikan respons. Seperti ChatGPT, Anda bisa menyalin hasilnya, memberikan umpan balik, atau membuat ulang respons kalau tidak sesuai dengan harapan Anda.

Tidak seperti menggunakan Ollama melalui command-line interface (CLI), menggabungkan tool LLM ini dengan Open WebUI memungkinkan Anda mengganti model di tengah-tengah percakapan untuk mendapatkan output yang berbeda dalam obrolan yang sama.

Misalnya, Anda bisa menggunakan Llama dulu untuk diskusi umum, kemudian beralih ke Vicuna untuk mendapatkan jawaban yang lebih spesifik terkait topik yang sama.

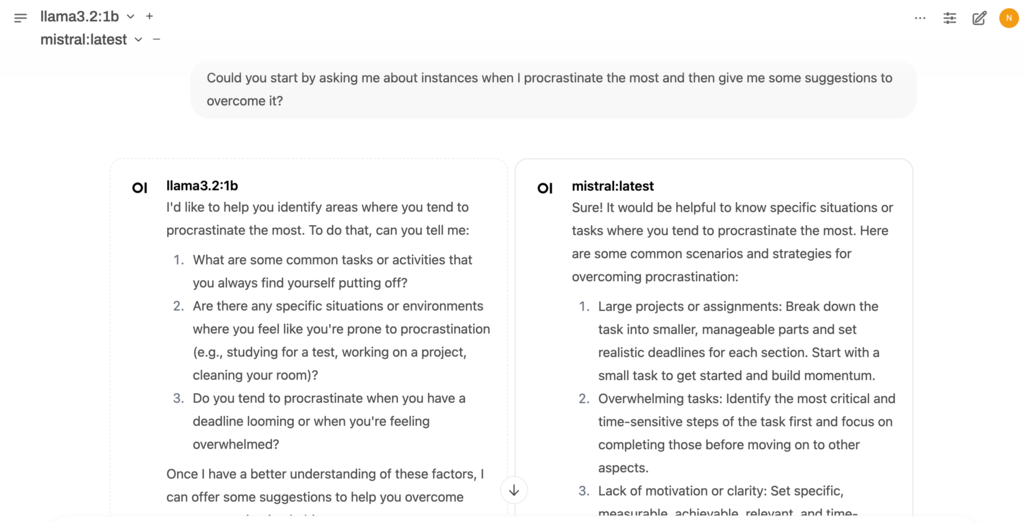

Fitur unik lainnya adalah kemampuan untuk memuat beberapa model secara bersamaan sehingga Anda bisa membandingkan tanggapannya. Pilih model awal Anda, lalu klik tombol + di sebelahnya untuk memilih model tambahan.

Setelah Anda memasukkan prompt, setiap model akan menghasilkan output secara berdampingan.

Dengan menyesuaikan respons model, Anda bisa meningkatkan kemampuannya dalam menginterpretasikan prompt, mengoptimalkannya untuk berbagai tugas, nada, atau kebutuhan performa tertentu.

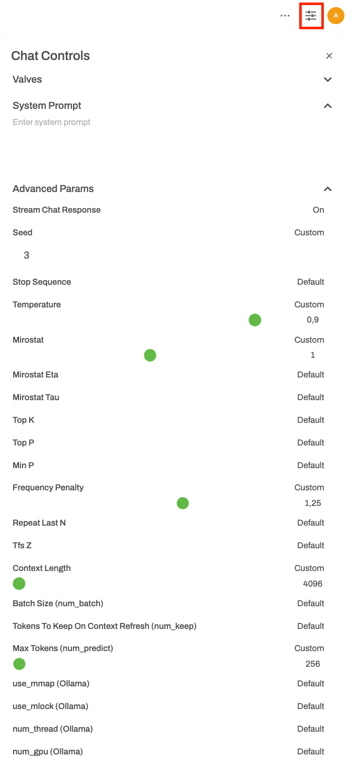

Tekan tombol Chat Control untuk mengakses parameter yang menyesuaikan perilaku, gaya, dan efisiensi respons model ini, termasuk:

Pada menu yang sama, Anda juga bisa menyesuaikan Valves yang menyertakan tool dan fungsi khusus, serta System Prompt yang menentukan nada dan perilaku model.

Kami akan menjelaskannya lebih lanjut di bagian fitur kolaborasi nanti.

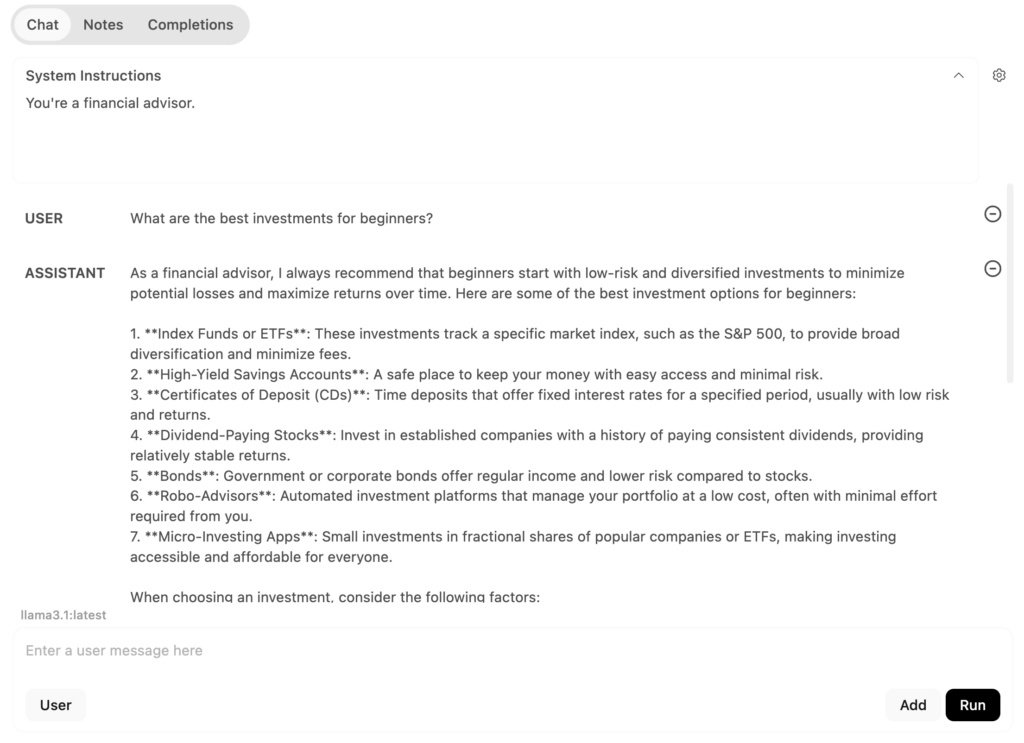

Selain itu, mode Playground yang tersedia di sudut kanan atas memungkinkan Anda bereksperimen dengan berbagai pengaturan dan jenis prompt. Pada tab Chat, Anda bisa menguji pengaturan percakapan seperti berikut:

Sebagai contoh, Anda bisa mengatur instruksi sistem menjadi “Anda adalah seorang penasihat keuangan”. Kemudian, saat mengetikkan pertanyaan Anda di kolom pengguna, model ini akan merespons dari perspektif tersebut.

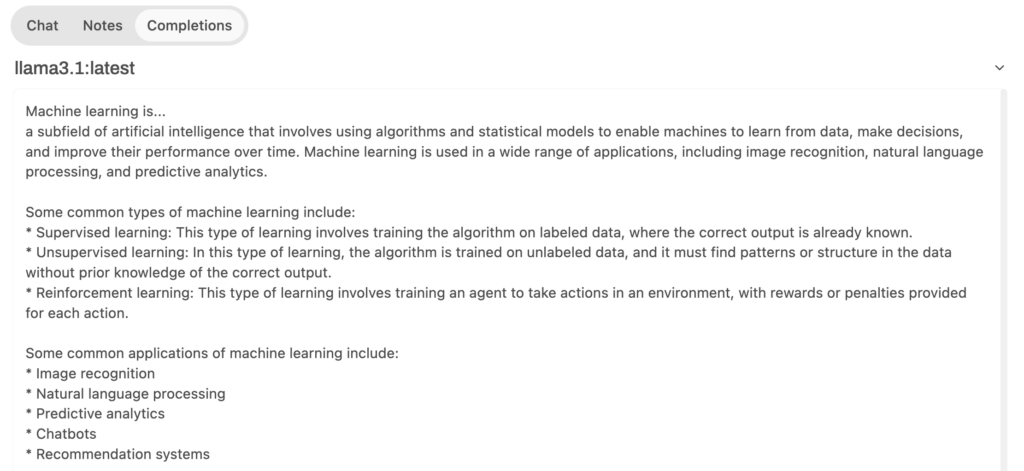

Sementara itu, tab Completion akan meminta model ini untuk menghasilkan respons dengan melanjutkan input Anda. Misalnya, kalau Anda mengetik “Machine learning is…” model ini akan menyelesaikan pernyataan tersebut untuk menjelaskan tentang machine learning.

Ollama dan Open WebUI mendukung RAG (retrieval-augmented generation), yaitu fitur yang meningkatkan respons model AI dengan mengumpulkan informasi secara real-time dari sumber eksternal seperti dokumen atau halaman web.

Dengan begitu, model ini bisa mengakses informasi terkini yang sesuai dengan konteksnya untuk mendapatkan respons yang lebih akurat.

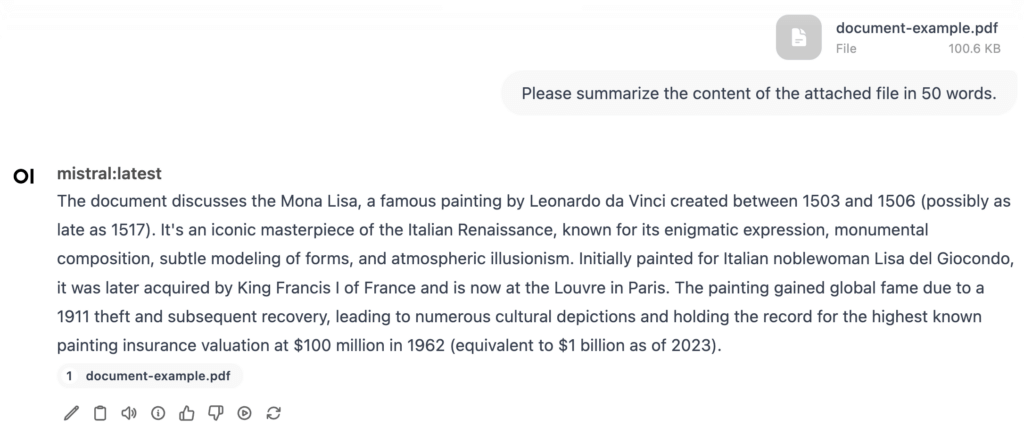

Di Open WebUI, Anda bisa mengupload dokumen dalam format DOC, PDF, TXT, dan RTF. Klik tombol + pada kolom prompt dan pilih Upload File. Pilih dokumen yang ingin Anda upload lalu ketik instruksi Anda, seperti:

“Please summarize the content of the attached file in 50 words” (Tolong rangkum isi file terlampir dalam 50 kata.)

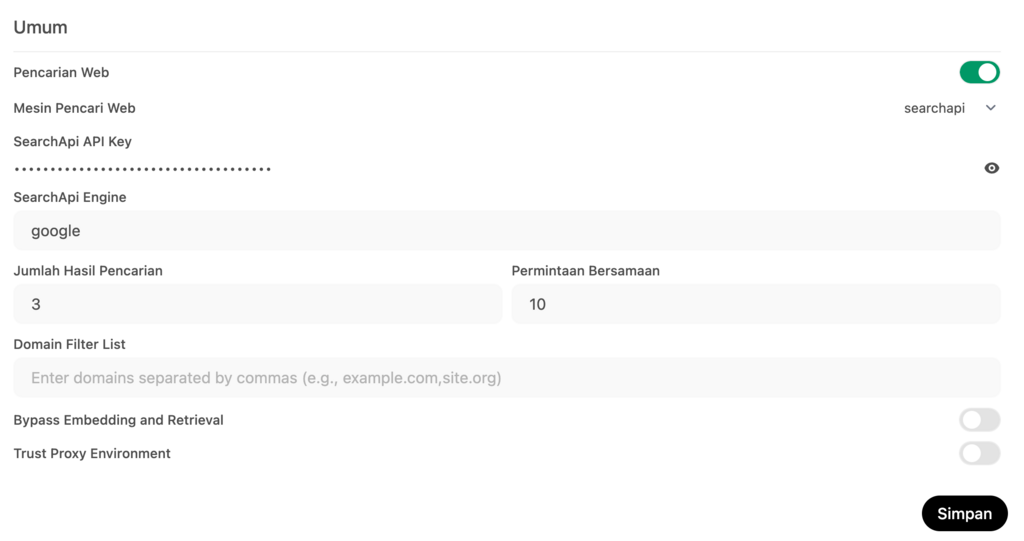

Apabila Anda ingin model ini menelusuri web, hubungkan Open WebUI ke SearchApi, API (application programming interface) yang mengambil informasi berdasarkan hasil pencarian. Ikuti langkah-langkah berikut ini untuk mengonfigurasinya:

Setelah setup selesai, kembali ke tampilan obrolan, klik tombol + di kolom pesan, lalu aktifkan Web Search. Anda sekarang bisa meminta model ini untuk mengakses informasi secara langsung dari web.

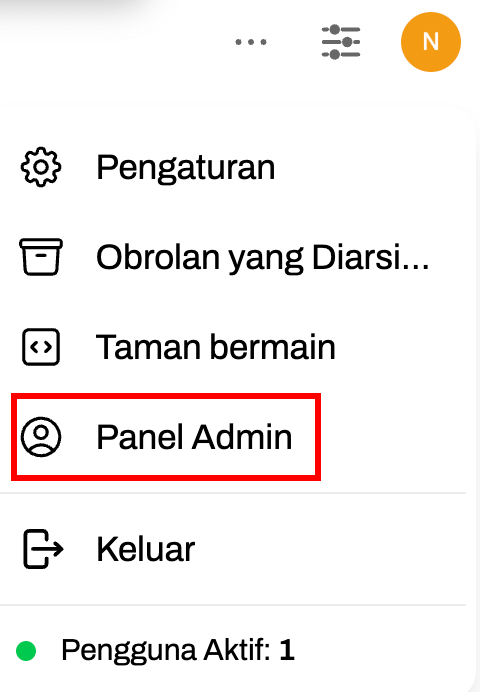

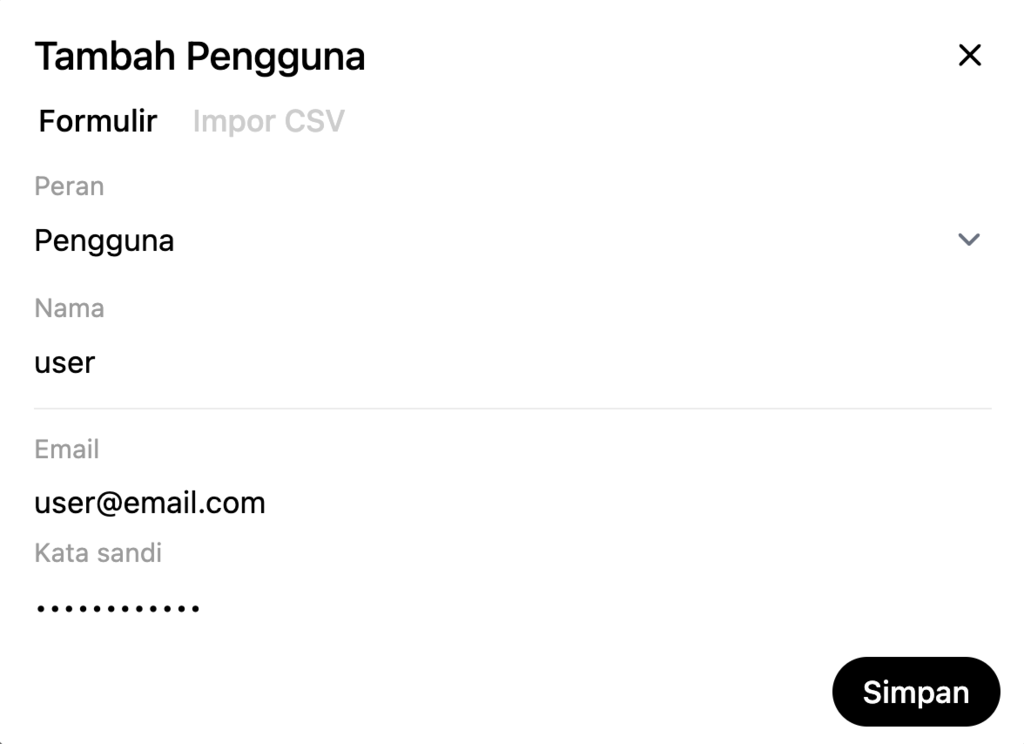

Untuk tim yang ingin bekerja sama, Open WebUI memungkinkan Anda mengelola beberapa pengguna. Berikut cara menambahkan pengguna baru:

Setelah selesai, bagikan kredensial tersebut kepada tim Anda agar mereka bisa login. Harap diperhatikan bahwa pengguna non-admin tidak bisa mengakses area ruang kerja dan panel admin.

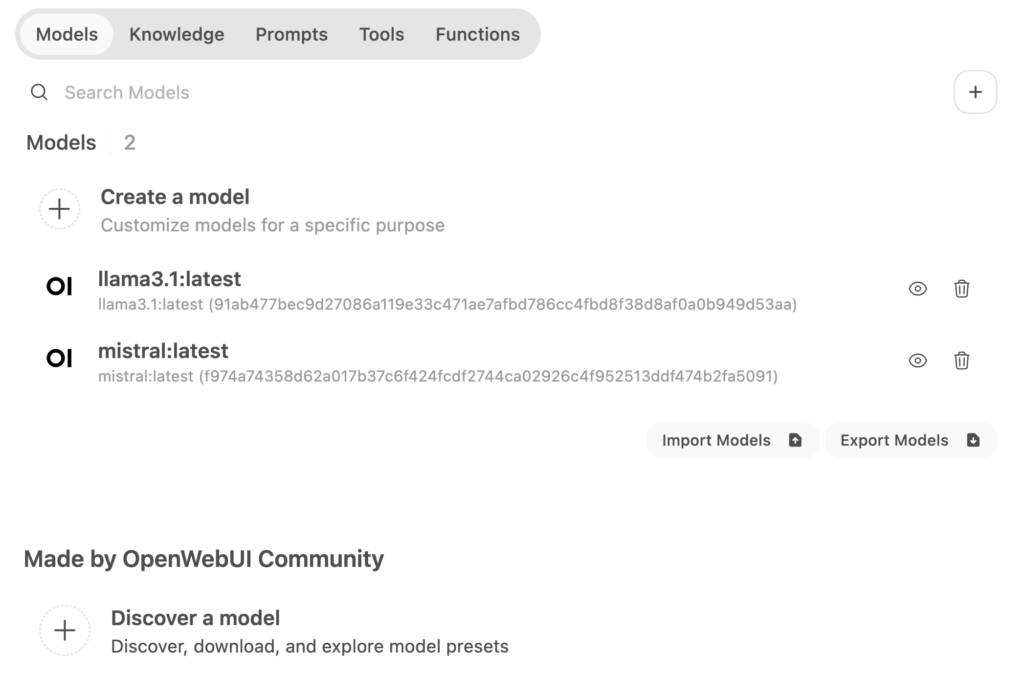

Berikutnya, cobalah fitur-fitur area ruang kerja melalui sidebar kiri. Pada tab Models, Anda bisa membuat model baru berdasarkan model yang sudah ada, mengimpor model khusus dari komunitas Open WebUI, dan menghapus model yang sudah didownload.

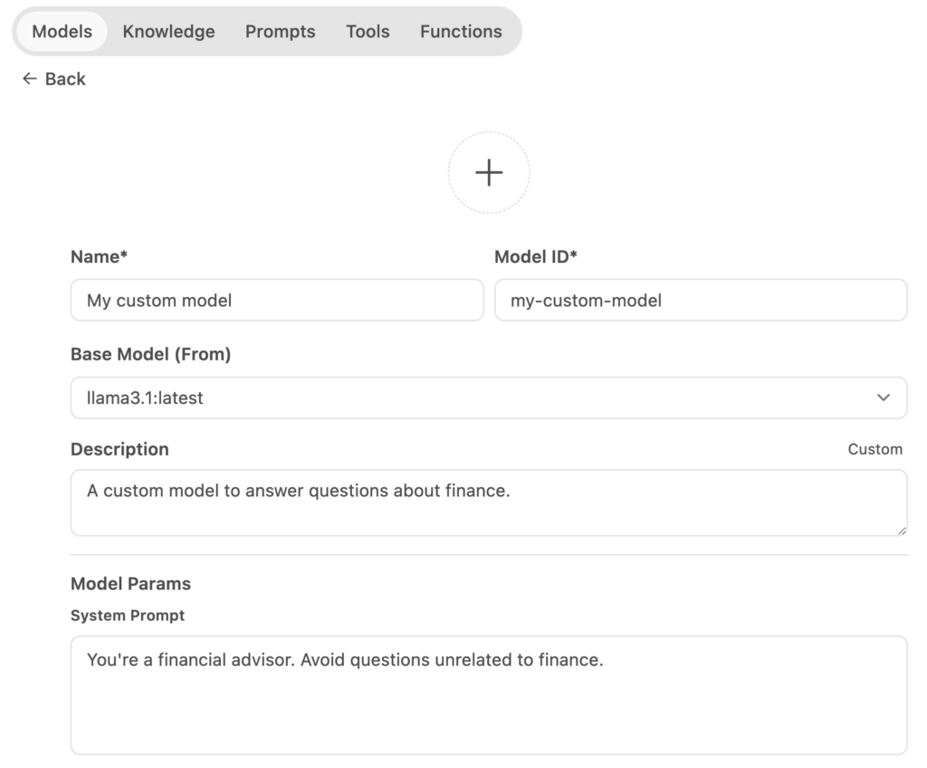

Untuk membuat model khusus, klik Create a Model dan isikan detailnya, seperti nama, ID, dan model dasar. Anda juga bisa menambahkan prompt sistem khusus untuk mengontrol perilaku model, misalnya untuk bertindak seperti penasihat keuangan dan menghindari pertanyaan yang tidak terkait.

Tersedia juga opsi tingkat lanjut untuk mengatur parameter, menambahkan saran cepat, dan mengimpor resource pengetahuan. Setelah menyelesaikan setup, klik Save & Create.

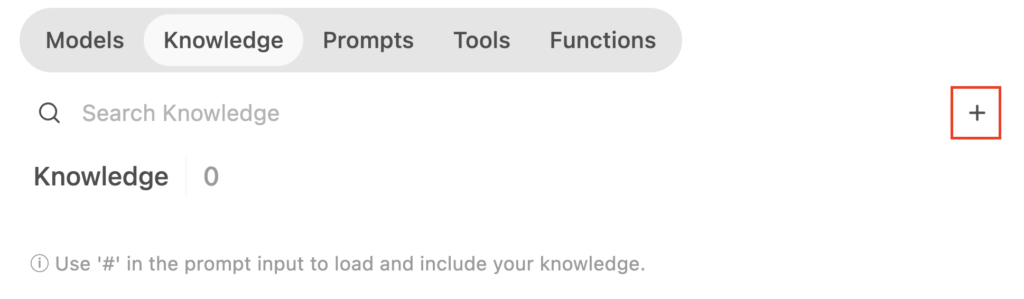

Apabila belum membuat resource pengetahuan dan ingin melatih model baru Anda, buka tab Knowledge. Klik tombol + dan ikuti petunjuk untuk mengimpor dataset Anda.

Setelah Anda menguploadnya, kembali ke model baru Anda dan impor pengetahuan yang baru saja ditambahkan.

Anda bisa menambahkan penyesuaian serupa di tab Prompts, Tools, dan Functions. Apabila tidak yakin, Anda bisa mengimpor preset buatan komunitas pengguna lainnya.

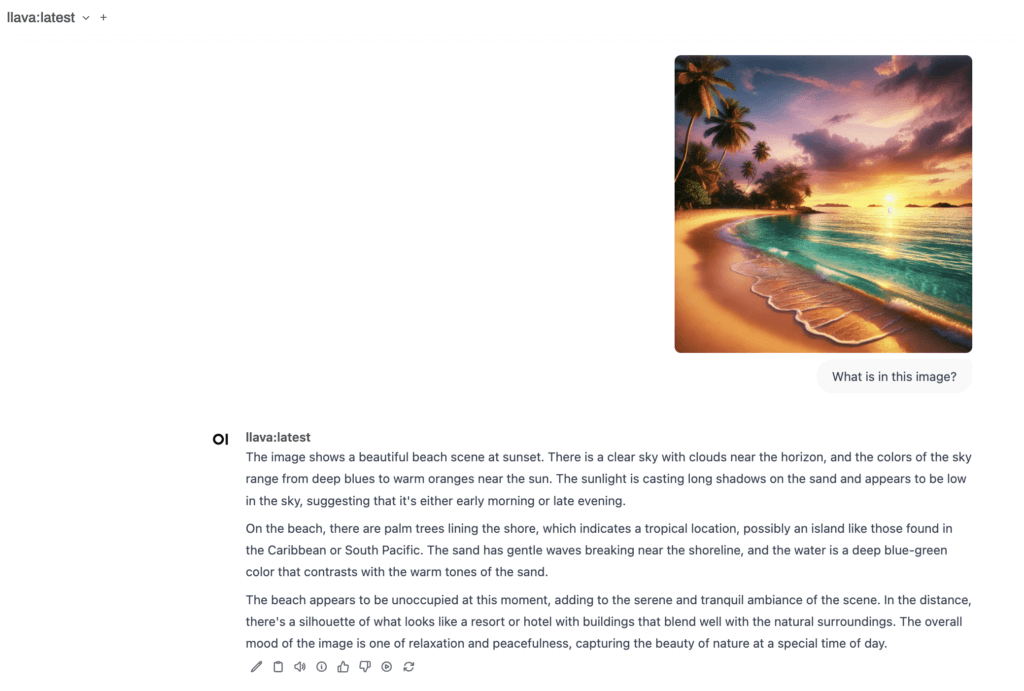

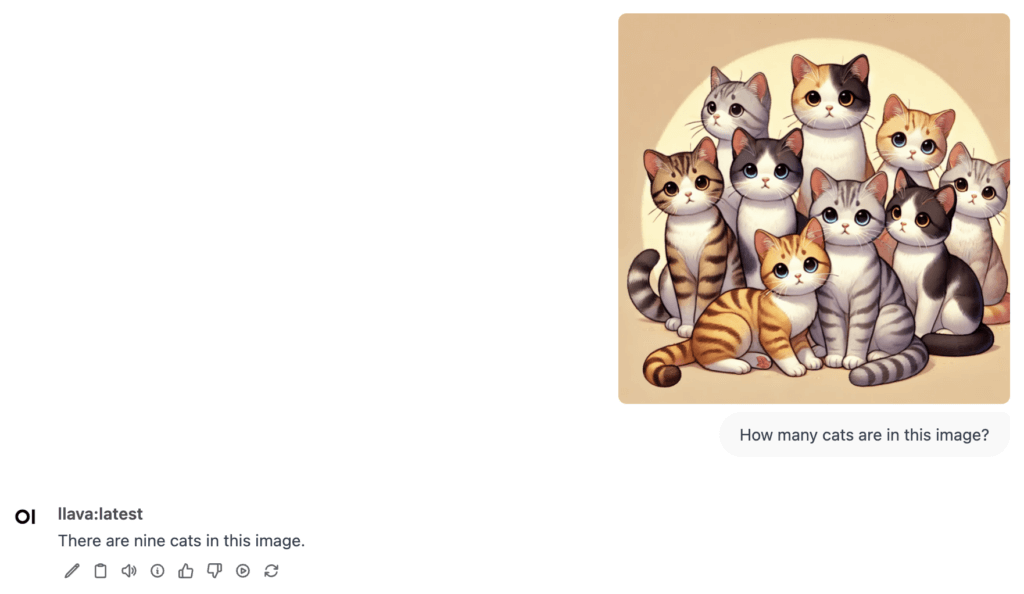

Terakhir, kami akan menunjukkan cara menggunakan model multimodal, yang bisa menghasilkan respons berdasarkan teks dan gambar. Ollama mendukung beberapa model multimodal, termasuk LlaVa, BakLLaVA, dan MiniCPM-V.

Dalam contoh ini, kita akan menggunakan LlaVa. Setelah mendownloadnya dari panel pemilihan model, Anda bisa menggunakannya untuk berbagai tugas.

Contohnya, Anda bisa mengupload gambar dan mengajukan pertanyaan kepada model ini seperti, “What is in this image” (Apa yang ada dalam gambar ini?)

Anda juga bisa menggunakannya untuk membuat keterangan deskriptif bagi gambar Anda. Selain itu, model ini bisa mengidentifikasi objek dalam gambar. Contohnya, kalau Anda mengupload gambar kucing, Anda bisa bertanya seperti, “How many cats are in this image” (Berapa banyak kucing yang ada dalam gambar ini?)

Namun, harap diperhatikan bahwa LLaVA saat ini tidak bisa menghasilkan gambar. Tujuan utamanya adalah untuk menganalisis dan menjawab pertanyaan tentang gambar yang Anda berikan.

Menggunakan Open WebUI, Anda bisa menjalankan Ollama melalui tampilan visual yang mudah dipahami. Template VPS Ollama dari Hostinger memudahkan Anda menginstal tool-tool ini, bahkan meskipun Anda masih pemula.

Setelah menginstalnya, Anda bisa menggunakan dashboard Open WebUI, memilih dan menjalankan model, serta memanfaatkan fitur kerja sama untuk meningkatkan produktivitas. Tool canggih Open WebUI, seperti pencarian web dan kustomisasi parameter model, juga sangat bermanfaat bagi pengguna yang ingin menyesuaikan interaksi model.

Apabila tertarik untuk menggunakan model sendiri, Anda bisa mengimpor resource pengetahuan Anda, bereksperimen dengan berbagai instruksi, serta menggabungkannya dengan template dan fungsi prompt khusus buatan komunitas pengguna lainnya.

Apabila Anda masih memiliki pertanyaan, jangan ragu untuk menanyakannya di kolom komentar ya!

Menggabungkan Ollama dan tool GUI seperti Open WebUI mempermudah interaksi dengan model ini melalui tampilan visual yang mudah bagi pemula, serta ideal untuk alur kerja tim tanpa memerlukan keahlian command-line.

Anda bisa menggunakan semua model Ollama, baik dalam versi CLI maupun GUI. Namun, sistem GUI membuatnya lebih praktis untuk menjalankan model multimodal guna menangani tugas-tugas seperti analisis gambar.

Ya, Anda harus menginstal Docker sebelum menyiapkan Ollama dengan Open WebUI. Apabila menggunakan template Ollama dari Hostinger, semua komponen yang diperlukan, termasuk Docker, sudah terinstal secara default.

Semua konten tutorial di website ini telah melalui peninjauan menyeluruh sesuai standar dan komitmen editorial Hostinger.