Dec 18, 2025

Diego B.

6min de lectura

Ollama te permite ejecutar varios modelos lingüísticos de gran tamaño (LLM) en un servidor privado o en una máquina local para crear un agente de IA personal. Por ejemplo, puedes configurarlo con DeepSeek R1, un modelo de IA muy popular conocido por su precisión y asequibilidad.

En este artículo, explicaremos cómo ejecutar DeepSeek con Ollama. Te guiaremos a través de los pasos, desde la instalación de la plataforma hasta la configuración del chat para tu caso de uso.

Antes de configurar Ollama, asegúrate de que dispones de un servidor VPS Linux, que utilizaremos para alojar el agente de IA. Si deseas instalarlo localmente, puedes utilizar tu ordenador personal Linux.

En cualquier caso, tu sistema debe cumplir los requisitos mínimos de hardware. Dado que las plataformas de IA como Ollama exigen muchos recursos, necesitarás como mínimo:

Para el sistema operativo, puedes utilizar distribuciones de Linux populares como Ubuntu y CentOS. Es importante que ejecutes la versión más reciente para evitar problemas de compatibilidad y seguridad.

Si no tienes un sistema que cumpla los requisitos, compra uno en Hostinger. A partir de 9.99 euros al mes, nuestro plan KVM 4 ofrece 4 núcleos de CPU, 16 GB de RAM y 200 GB de almacenamiento SSD NVMe.

Nuestro VPS también cuenta con varias plantillas de SO que te permiten instalar aplicaciones con un solo clic, incluyendo Ollama. Esto hace que el proceso de configuración sea más rápido y más amigable para los principiantes.

Además, el VPS de Hostinger tiene incorporado el asistente con IA Kodee que puede ayudarte a solucionar problemas o guiarte en la gestión de tu servidor. Mediante prompts, puedes pedirle que compruebe tu sistema o genere comandos para diversas necesidades.

Tras asegurarte de que cumples los requisitos previos, sigue estos pasos para instalar Ollama en un sistema Linux.

Los usuarios de Hostinger pueden instalar fácilmente Ollama seleccionando la plantilla correspondiente durante el onboarding o en el menú Sistema Operativo de hPanel.

De lo contrario, deberás utilizar comandos. Para empezar, conéctate a tu servidor vía SSH usando PuTTY o Terminal. Si deseas instalar Ollama localmente, omite este paso y simplemente abre el terminal de tu sistema.

¡Importante! Si utilizas distribuciones basadas en Red Hat Enterprise Linux como CentOS o AlmaLinux, sustituye apt por dnf.

Una vez conectado, sigue estos pasos para instalar Ollama:

sudo apt update

sudo apt install python3 python3-pip python3-venv

curl -fsSL https://ollama.com/install.sh | sh

python3 -m venv ~/ollama-webui && source ~/ollama-webui/bin/activate

pip install open-webui

screen -S Ollama

open-webui serve

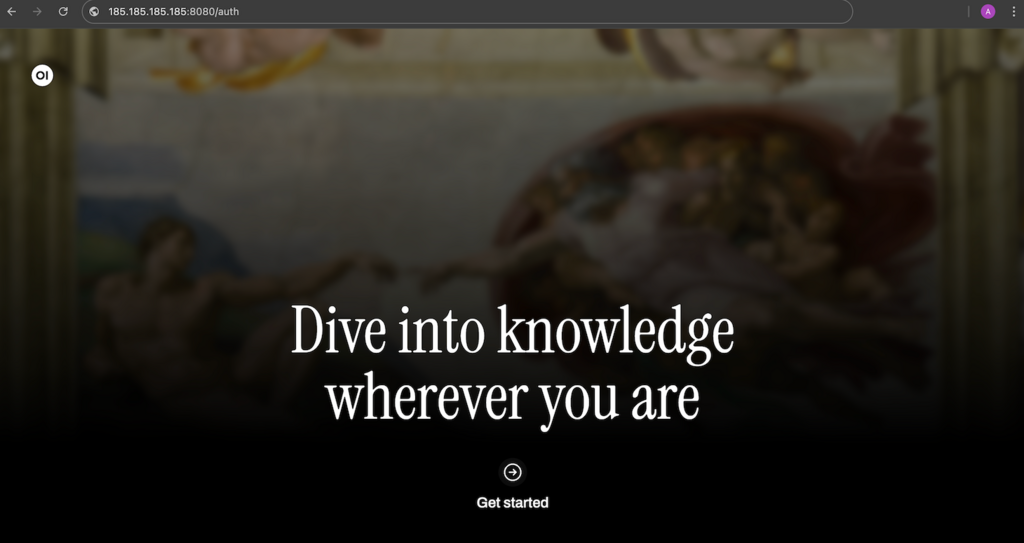

¡Ya está! Ahora, puedes acceder a Ollama introduciendo la siguiente dirección en tu navegador web. Recuerda sustituir 185.185.185.185 por la dirección IP real de tu VPS:

185.185.185.185:8080

Después de confirmar que Ollama puede ejecutarse correctamente, vamos a configurar el LLM DeepSeek R1. Para ello, vuelve a la interfaz de línea de comandos del sistema del host y pulsa Ctrl + C para detener Ollama.

Si instalas Ollama usando la plantilla SO de Hostinger, simplemente conéctate a tu servidor vía SSH. La forma más sencilla de hacerlo es utilizar el terminal del navegador.

A continuación, ejecuta este comando para descargar el modelo Deepseek R1. Utilizaremos la versión 7b:

ollama run deepseek-r1:7b

Si planeas utilizar otra versión, como la 1.5b, cambia el comando en consecuencia. Para obtener más información sobre las diferencias y los requisitos de cada versión, consulta la biblioteca Ollama DeepSeek.

Espera a que tu sistema termine de descargar DeepSeek. Dado que el tamaño del archivo LLM es de unos 5 GB, este proceso puede tardar bastante, dependiendo de tu velocidad de Internet.

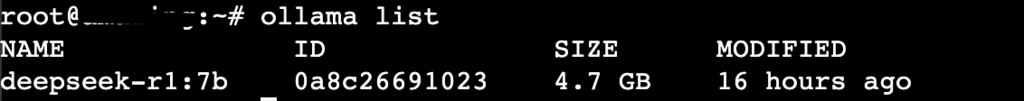

Una vez finalizada la descarga, pulsa Ctrl + d para volver al intérprete de comandos principal. A continuación, ejecuta el siguiente comando para comprobar si DeepSeek está configurado correctamente:

ollama list

Si ves DeepSeek en la lista de LLM de Ollama, la configuración se ha realizado correctamente. Ahora, reinicia la interfaz web:

open-webui serve

Accede a tu GUI de Ollama y crea una nueva cuenta. Este usuario será el administrador por defecto de tu agente de IA.

Una vez iniciada la sesión, verás el panel principal de datos donde podrás interactuar con DeepSeek. Empieza a chatear para comprobar si el LLM funciona correctamente.

Por ejemplo, pregunta “Explica qué es el alojamiento VPS”. Si DeepSeek puede responderla, el LLM y tu agente de IA funcionan según lo previsto.

Dependiendo de la conexión a Internet del host y del consumo de recursos, el tiempo que DeepSeek necesita para responder varía.

Aunque Ollama y DeepSeek funcionan bien con la configuración por defecto, puedes ajustar la configuración del chat según tu caso de uso.

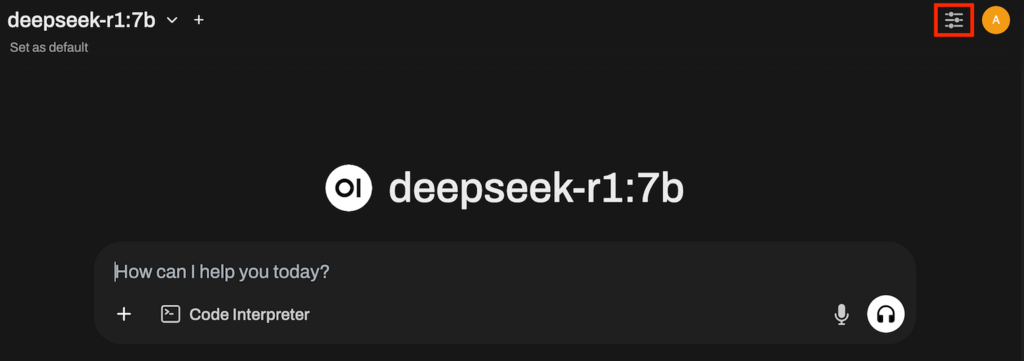

Para acceder al menú, haz clic en el icono deslizante situado en la parte superior derecha de tu panel de control de Ollama, junto al icono de perfil. En la sección Ajustes avanzados, puedes configurar varias opciones, entre ellas:

Por ejemplo, si utilizas DeepSeek para ayudarte a escribir ficción, establecer un valor alto de Temperatura puede ser útil. Por el contrario, puede que quieras bajarlo y aumentar el esfuerzo de Razonamiento al generar código.

Si quieres saber más sobre los ajustes, menús y configuración, te recomendamos que eches un vistazo a nuestro tutorial sobre la interfaz gráfica de Ollama.

Ollama es una plataforma que te permite ejecutar varios LLM en tu servidor privado u ordenador para crear un agente de IA personal. En este artículo, hemos explicado cómo configurar el famoso modelo de IA, DeepSeek, en Ollama.

Para configurarlo, necesitas un sistema Linux con al menos 4 núcleos de CPU, 16 GB de RAM y 12 GB de espacio de almacenamiento. Una vez que tengas una máquina que cumpla estos requisitos, instala Ollama y la Open WebUI utilizando la plantilla de SO o los comandos de Hostinger.

Descarga DeepSeek para Ollama a través de la línea de comandos. Una vez terminado, ejecuta la plataforma ejecutando open-webui serve. Ahora, accede al dashboard utilizando la IP del host y el puerto 8080.

Para ajustar la respuesta de Ollama en función de tus casos de uso, edita los parámetros de configuración del chat. Además, utiliza técnicas adecuadas de prompting de IA para mejorar la calidad de la respuesta de DeepSeek.

Para ejecutar DeepSeek con Ollama, necesitas un sistema de host Linux con al menos una CPU de 4 núcleos, 16 GB de RAM y 12 GB de espacio de almacenamiento. Puedes utilizar distribuciones populares como Ubuntu y CentOS para el sistema operativo.

Recuerda utilizar una versión más reciente del sistema operativo para evitar problemas de compatibilidad y seguridad.

DeepSeek es un LLM famoso por ser más asequible y eficiente que otros modelos populares como OpenAI o1, a la vez que ofrece un nivel de precisión similar. Su uso con Ollama permite configurar un agente de IA personal asequible aprovechando la capacidad del LLM.

En teoría, puedes instalar Ollama y ejecutar DeepSeek en cualquier versión de Ubuntu. Sin embargo, recomendamos instalar el agente de IA en una versión más reciente del sistema operativo, como Ubuntu 20.04, 22.04 y 24.04.

El uso de las nuevas versiones ayuda a evitar problemas de compatibilidad y seguridad.

Todo el contenido de los tutoriales en este sitio web está sujeto a los rigurosos estándares y valores editoriales de Hostinger.