May 06, 2025

Diego B.

5min de lectura

Ollama es ideal para ejecutar de forma segura grandes modelos lingüísticos a nivel local, proporcionar una sólida privacidad de los datos y reducir costes al eliminar las dependencias de la nube.

Es especialmente valioso para los sectores que requieren confidencialidad de los datos, como la sanidad y las finanzas, a la vez que permite la personalización para casos de uso específicos.

En este artículo explicaremos paso a paso el proceso de instalación de Ollama. Aprenderás a descargar el paquete de instalación desde GitHub, a instalarlo en tu VPS y a realizar la primera configuración para que todo funcione correctamente.

Como extra, también te mostraremos cómo reducir todo este tiempo de instalación a solo unos segundos con Hostinger.

Ollama es una plataforma de código abierto que te permite ejecutar localmente grandes modelos lingüísticos (LLM) en tu máquina.

Es compatible con diversos LLM populares, como Llama 2, GPT-3.5 y Mistral. Al integrar localmente las capacidades de IA en sus aplicaciones, Ollama aumenta la seguridad, mejora la privacidad y proporciona un mayor control sobre el rendimiento del modelo.

Con Ollama, puedes gestionar los pesos del modelo, las configuraciones y los conjuntos de datos a través de una interfaz fácil de usar. Esto facilita la adaptación de los modelos lingüísticos a casos de uso específicos.

En muchos sentidos, es un sueño hecho realidad para los desarrolladores a los que les gusta experimentar con la IA.

Pero, si quieres integrar Ollama en tus aplicaciones web sin depender de API de terceros, primero tienes que configurarlo en tu entorno de hosting.

Antes de comenzar el proceso de instalación, necesitas algunas cosas para instalar Ollama en tu VPS. Veámoslas ahora.

Hosting VPS

Para ejecutar Ollama eficazmente, necesitarás un servidor virtual privado (VPS) con al menos 16 GB de RAM, más de 12 GB de espacio en disco duro y de 4 a 8 núcleos de CPU.

Ten en cuenta que estos son sólo los requisitos mínimos de hardware. Para una configuración óptima, es necesario disponer de más recursos, especialmente para los modelos con más parámetros.

Sistema operativo

Ollama está diseñado para funcionar en sistemas Linux. Para obtener los mejores resultados, tu entorno de alojamiento debería funcionar con Ubuntu 22.04 o superior, o con la última versión estable de Debian.

Acceso y privilegios

Para instalar y configurar Ollama, necesitas tener acceso al terminal o a la interfaz de línea de comandos de tu VPS. También necesitas tener acceso root o poseer una cuenta con privilegios sudo en Linux.

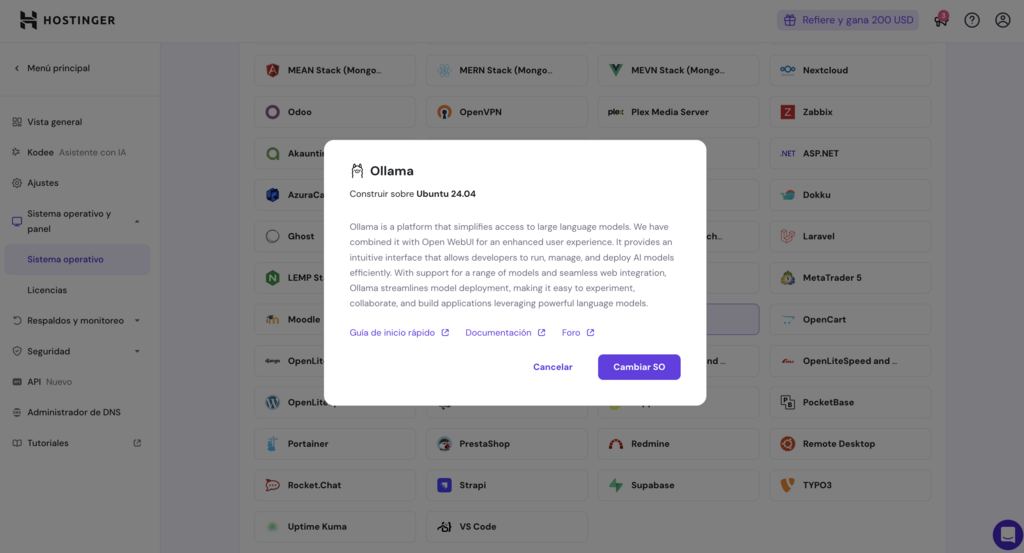

Ahora que hemos cubierto los requisitos previos, vamos a explorar cómo se puede instalar fácilmente Ollama en tu VPS utilizando una plantilla pre-construida de Hostinger.

Hostinger ha simplificado el proceso de instalación de Ollama proporcionando una plantilla preconfigurada de Ubuntu 24.04 VPS por sólo 4.99 € al mes.

Viene con Ollama, Llama 3, y Open WebUI ya instalado. Todo lo que tienes que hacer es seleccionar la plantilla, esperar a que el instalador automático termine, y acceder a tu servidor para verificar la instalación.

Así es como funciona:

¡Ya está! Ahora deberías estar listo para empezar a usar Ollama en tu VPS Hostinger para potenciar tus aplicaciones web.

Como la plantilla ya tiene todas las herramientas y el software necesarios preinstalados y configurados, no necesitas hacer nada más antes de sumergirte en los LLM.

Si quieres ejecutar Ollama en tu VPS pero utilizas un proveedor de alojamiento diferente, aquí te explicamos cómo puedes instalarlo manualmente. Es un proceso más complicado que usar una plantilla preconstruida, así que te guiaremos paso a paso.

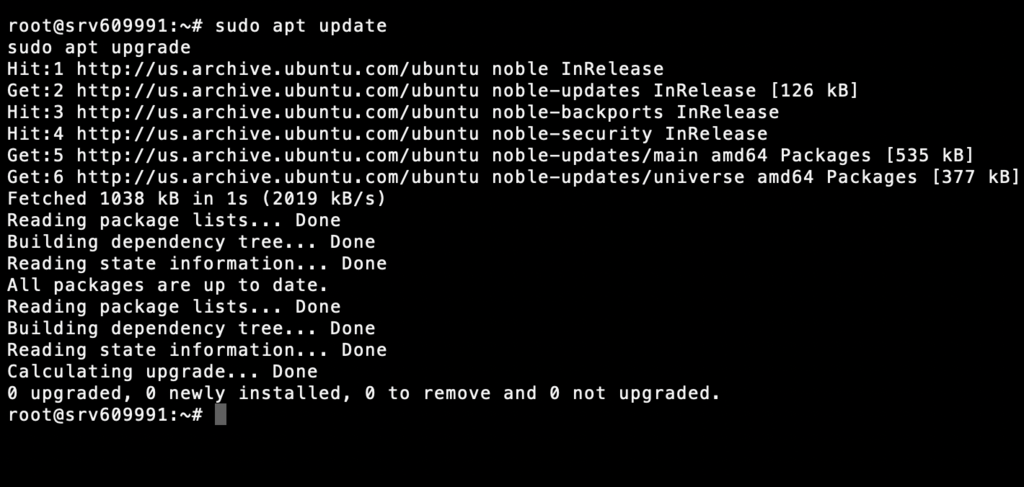

Debes asegurarte de que tu VPS está actualizado antes de instalar cualquier software nuevo. Para actualizar tu lista de paquetes y actualizar los paquetes de instalación, ejecuta los siguientes comandos utilizando la línea de comandos de tu servidor:

sudo apt update sudo apt upgrade

Mantener el sistema actualizado ayuda a evitar problemas de compatibilidad y garantiza una instalación sin problemas de principio a fin.

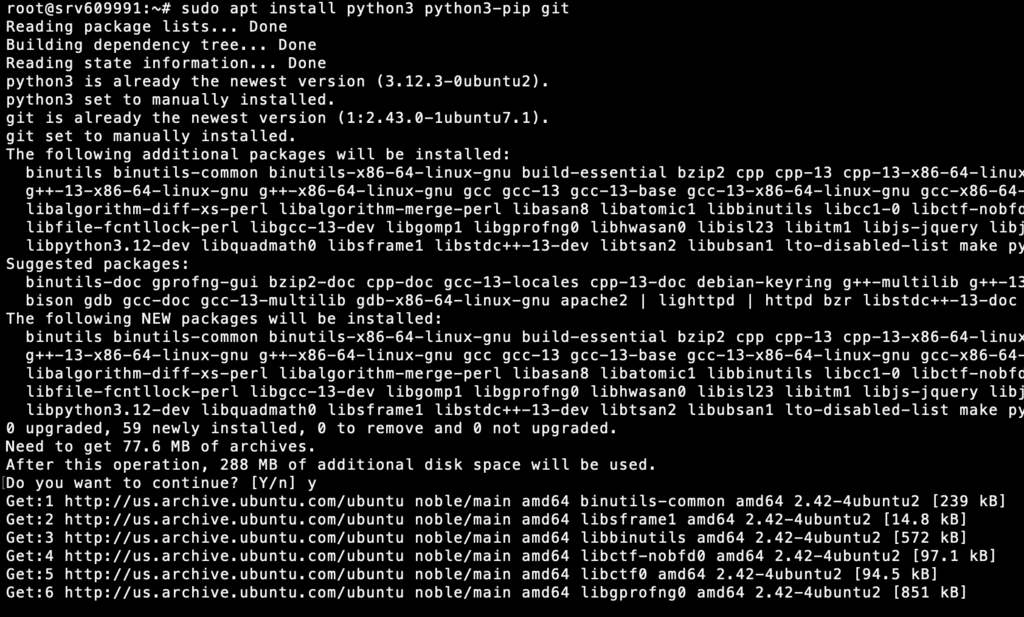

Ollama requiere ciertas dependencias para funcionar sin problemas. Estas incluyen las últimas versiones de Python, Pip y Git. Para instalarlas, ejecuta este comando:

sudo apt install python3 python3-pip git

Verifica que la instalación se ha completado con éxito ejecutando:

python3 --version pip3 --version git --version

Si tu VPS tiene una GPU NVIDIA, necesitarás controladores CUDA adicionales para aprovechar el rendimiento mejorado de la GPU. Pero estos pasos variarán en función de la configuración de tu servidor.

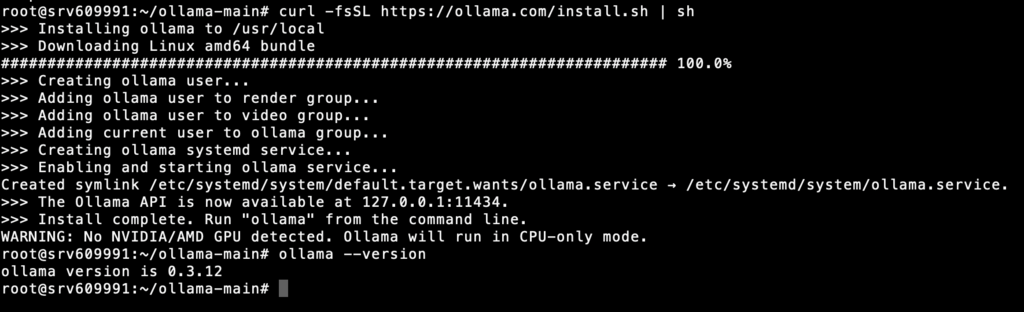

A continuación, descarga el paquete de instalación de Ollama para Linux desde su sitio web oficial. Puedes hacerlo ejecutando:

curl -fsSL https://ollama.com/install.sh | sh

Esto descargará e instalará Ollama en tu VPS. Ahora, verifica la instalación ejecutando:

ollama --version

Ahora deberías poder ejecutar Ollama cuando quieras, utilizando el siguiente comando:

ollama serve

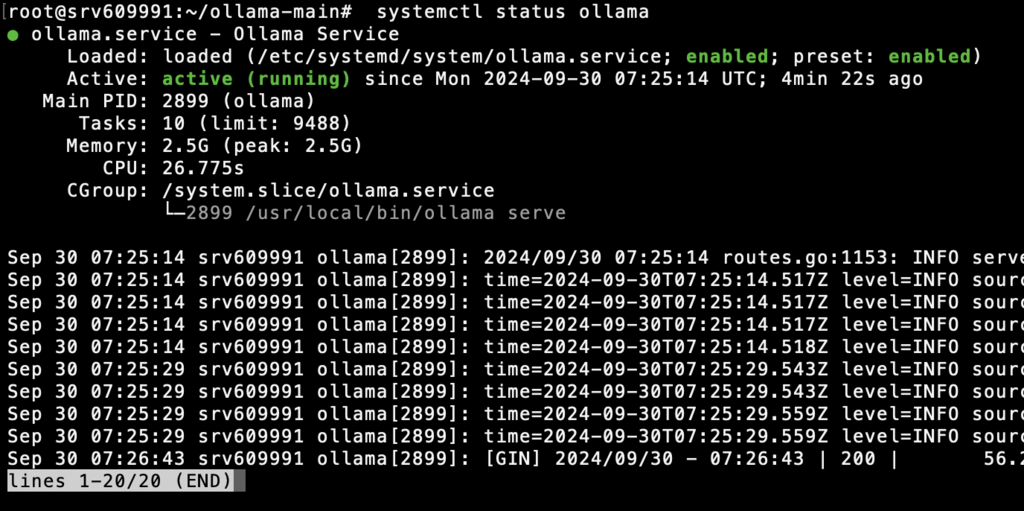

Antes de continuar, deberías comprobar el estado actual del servicio Ollama ejecutando esto en tu CLI:

systemctl status ollama

Si eres cliente de Hostinger VPS, también puedes utilizar el asistente con IA Kodee para confirmar si Ollama ya se está ejecutando en tu servidor.

Desde el panel de control de tu VPS, abre el menú Kodee a través de la barra lateral izquierda. A continuación, escribe tu prompt como “¿Puedes comprobar si Ollama se está ejecutando en mi servidor?”.

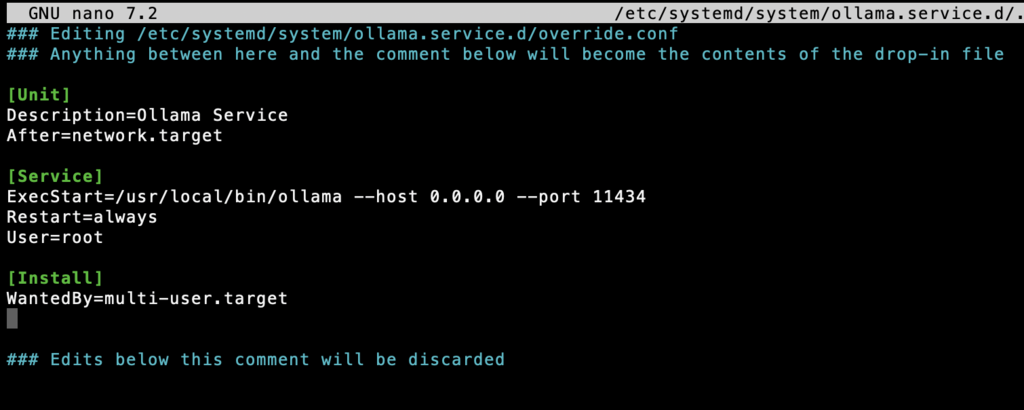

A continuación, crea un archivo de servicio systemd para que Ollama se ejecute automáticamente cada vez que arranques tu VPS:

sudo nano /etc/systemd/system/ollama.service

Añade el siguiente contenido a tu archivo de servicio systemd:

[Unit] Description=Ollama Service After=network.target [Service] ExecStart=/usr/local/bin/ollama --host 0.0.0.0 --port 11434 Restart=always User=root [Install] WantedBy=multi-user.target

A continuación, utiliza el siguiente comando para recargar el entorno:

systemctl daemon-reload systemctl restart ollama

¡Y ya está! Ollama debería iniciarse automáticamente la próxima vez que inicies tu VPS.

Nota: Aunque proporciona muchas opciones de configuración para modificar el comportamiento del modelo, ajustar el rendimiento y cambiar la configuración del servidor, Ollama está diseñado para ejecutarse de forma inmediata utilizando su configuración predeterminada.

Esta configuración funciona bien para la mayoría de los escenarios, por lo que puedes empezar de inmediato obteniendo los archivos de modelo necesarios. Puedes hacerlo ejecutando “ollama pull <model_name>”.

Ahora que has instalado Ollama en tu VPS con éxito, tienes acceso a una gran cantidad de herramientas para afinar una variedad de grandes modelos de lenguaje antes de ejecutarlos localmente en tu servidor. Ollama abre un mundo de posibilidades para desarrolladores, investigadores y entusiastas de la IA.

Algunos de los casos de uso más comunes de Ollama incluyen la creación de chatbots y asistentes virtuales personalizados para satisfacer necesidades específicas.

Por ejemplo, puedes crear tu propio asistente de codificación para ayudarte con el desarrollo de aplicaciones web y móviles, crear un compañero de intercambio de ideas para proyectos centrados en el diseño o explorar las posibilidades de los grandes modelos lingüísticos en la estrategia y creación de contenidos.

Todo el contenido de los tutoriales en este sitio web está sujeto a los rigurosos estándares y valores editoriales de Hostinger.