Dec 18, 2025

Diego B.

8min de lectura

Por defecto, Ollama ejecuta grandes modelos lingüísticos (LLM) a través de una interfaz de línea de comandos (CLI). Sin embargo, puedes emparejar Ollama con Open WebUI, una herramienta de interfaz gráfica de usuario (GUI), para interactuar con estos modelos en un entorno visual.

Esta configuración reduce las entradas de línea de comandos complejas y propensas a errores, por lo que es ideal para usuarios y equipos no técnicos que necesitan una forma visual y colaborativa de trabajar con LLM e implementar aplicaciones de IA.

En este artículo, aprenderás a configurar Ollama y Open WebUI de la forma más sencilla, utilizando una plantilla de servidor virtual privado (VPS) preconfigurada.

También te guiaremos a través del panel de control de Open WebUI, te mostraremos cómo personalizar los resultados del modelo y exploraremos las funciones de colaboración.

La forma más fácil de utilizar Ollama con Open WebUI es elegir un plan de alojamiento LLM de Hostinger. De esta manera todos los componentes necesarios como Docker, Ollama, Open WebUI, y el modelo Llama 3.1 están preconfigurados.

Basándonos en los requisitos del sistema de Ollama, recomendamos el plan KVM 4, que proporciona cuatro núcleos vCPU, 16 GB de RAM y 200 GB de almacenamiento NVMe por 9.99 euros al mes. Estos recursos garantizarán que tus proyectos se ejecuten sin problemas.

Tras adquirir el plan, puedes acceder al panel Open WebUI introduciendo la dirección IP de tu VPS seguida de :8080 en tu navegador. Por ejemplo:

http://22.222.222.84:8080

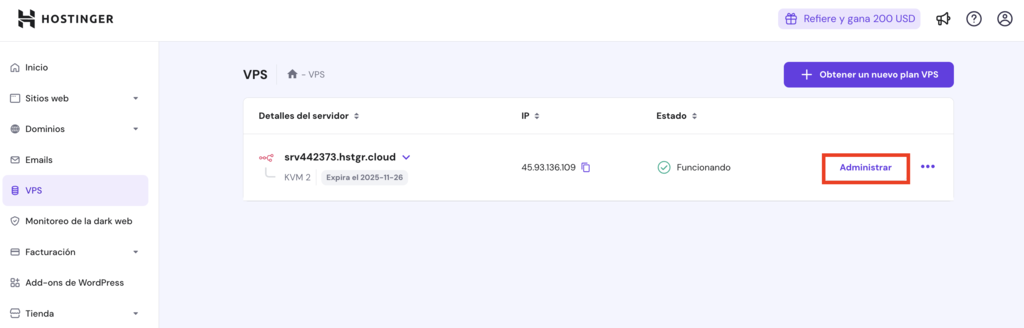

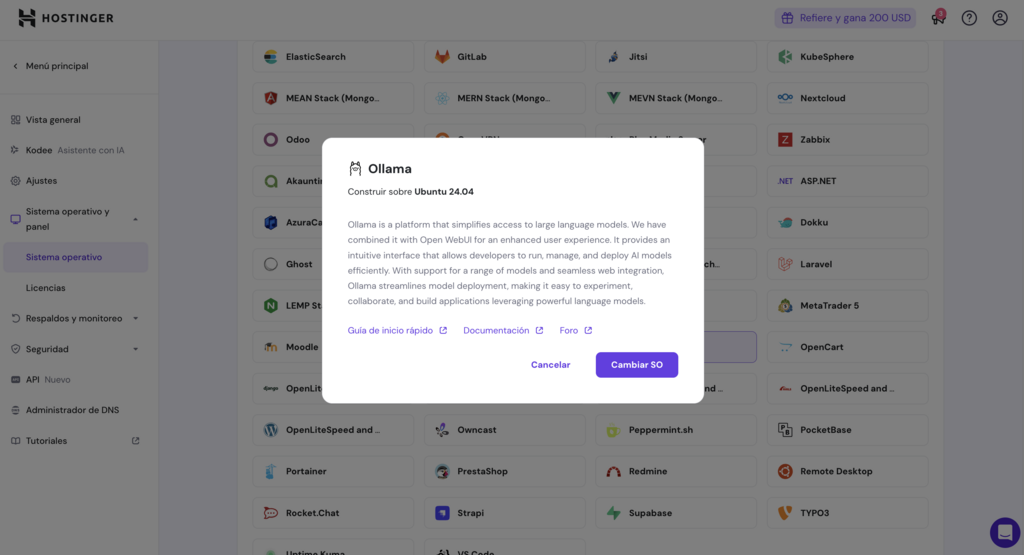

Sin embargo, si has cambiado de sistema operativo desde la configuración inicial o utilizas un plan VPS normal de Hostinger, puedes instalar Ollama como plantilla siguiendo estos pasos:

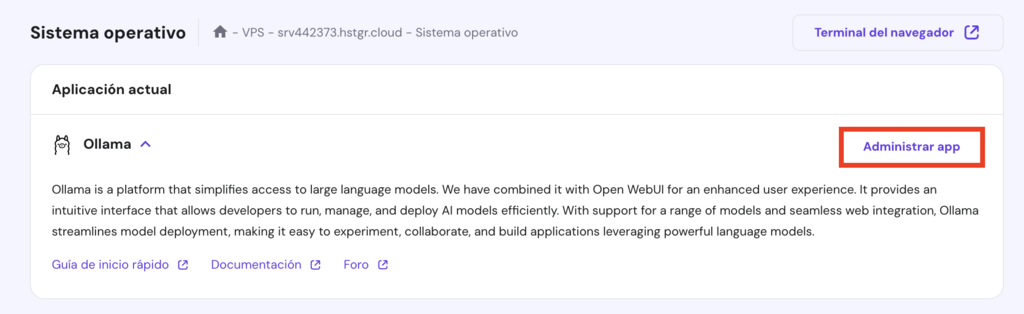

Espera unos 10 minutos a que finalice el proceso de instalación. Una vez hecho esto, desplázate hacia arriba y haz clic en Administrar app para acceder a Open WebUI.

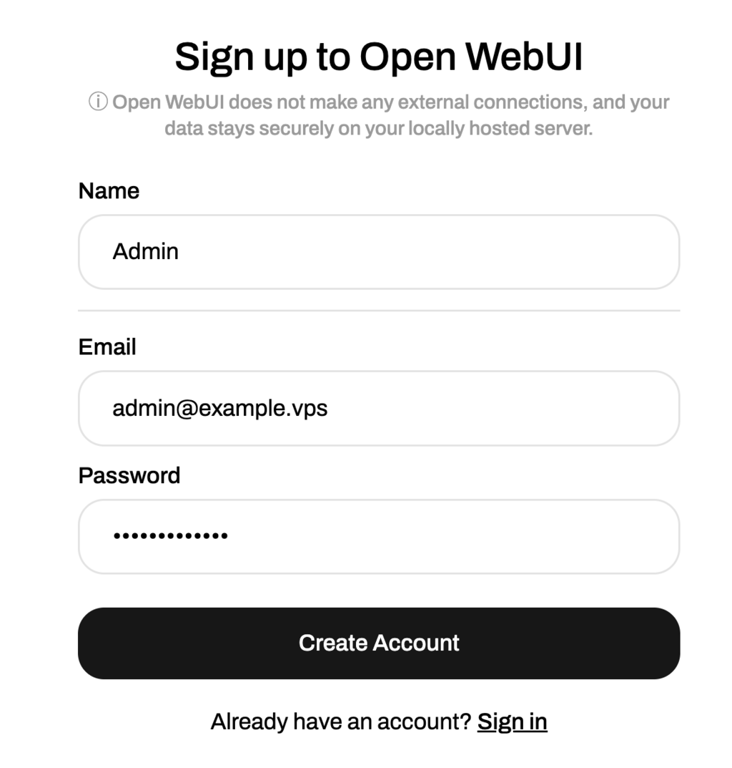

En tu primera visita, se te pedirá que crees una cuenta Open WebUI. Sigue las instrucciones en pantalla y guarda tus credenciales para futuros accesos.

Esta sección te ayudará a familiarizarte con las características de Open WebUI, desde navegar por el panel hasta trabajar con modelos multimodales.

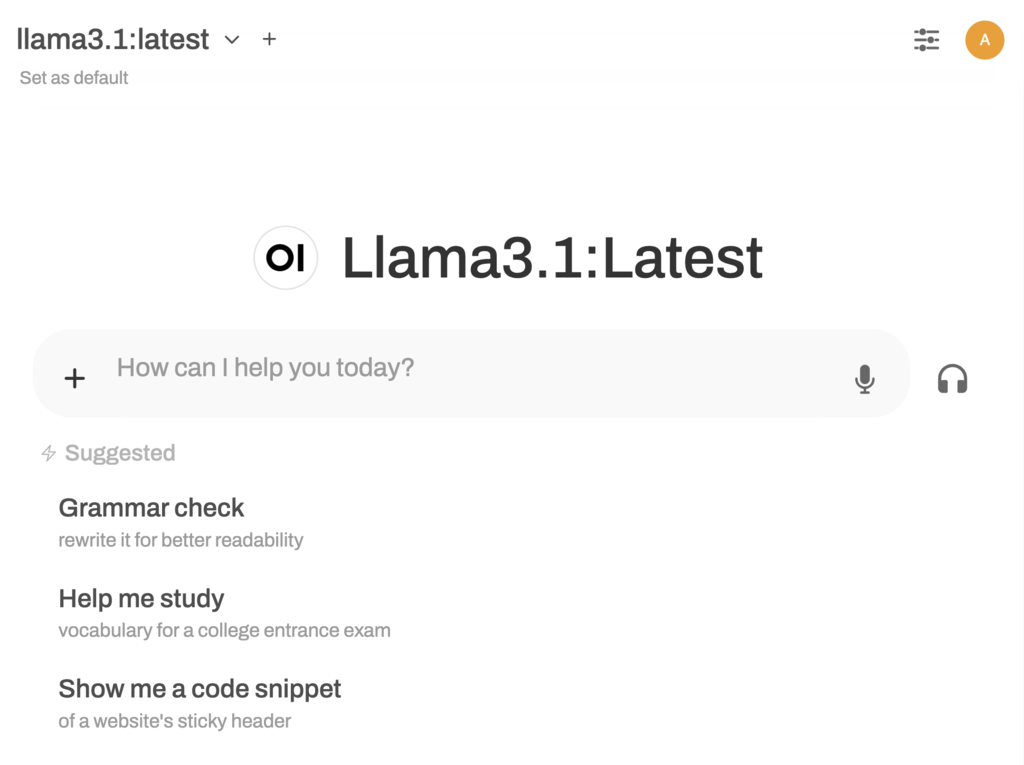

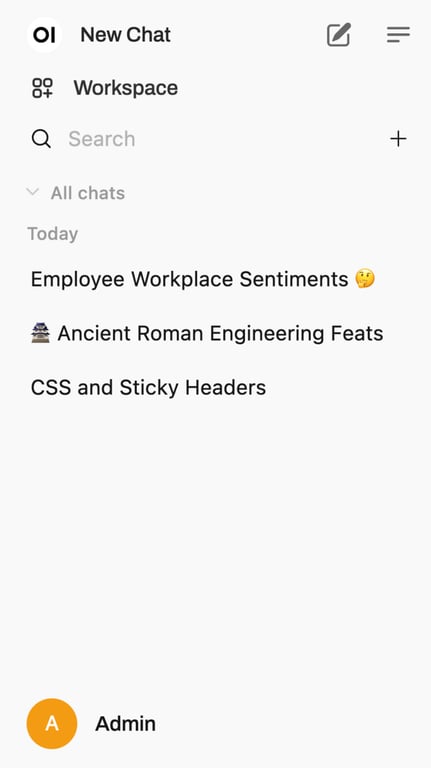

El panel de control de Open WebUI ofrece un diseño intuitivo y fácil de usar para principiantes. Si estás familiarizado con ChatGPT, adaptarte a Open WebUI será aún más fácil, ya que comparten una interfaz similar.

El panel de control se divide en dos secciones principales:

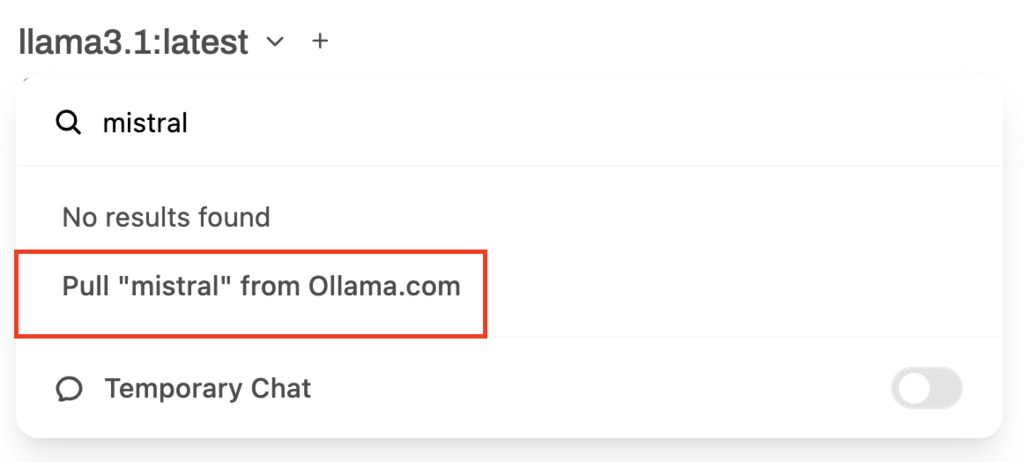

Dado que has instalado Ollama y Open WebUI utilizando la plantilla Hostinger, el modelo Llama 3.1 está listo para usar. Sin embargo, puedes descargar otros modelos de lenguaje a través del panel de selección de modelos en la esquina superior izquierda de tu panel de datos.

Aquí, añade un modelo escribiendo su nombre en la barra de búsqueda y pulsa Pull [model] from Ollama.com. Si no estás seguro de qué modelo utilizar, visita la biblioteca de modelos de Ollama para ver descripciones detalladas y casos de uso recomendados.

Algunas opciones populares son Mistral, conocida por su eficacia y rendimiento en la traducción y el resumen de textos, y Code Llama, favorecida por su solidez en la generación de código y las tareas relacionadas con la programación.

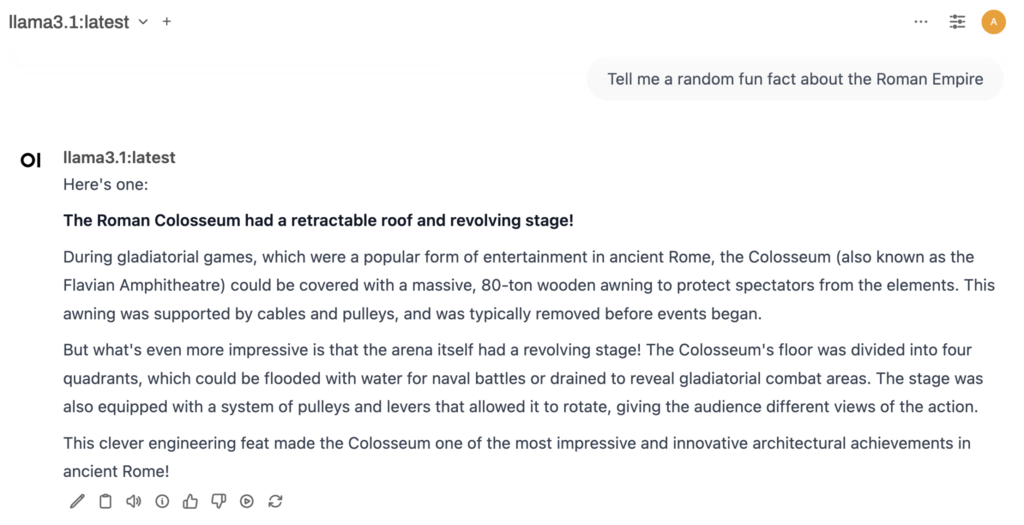

Una vez descargado, inicia una nueva conversación haciendo clic en Nuevo chat. Elige el modelo y escribe tu pregunta, entonces el modelo generará una respuesta. Al igual que ChatGPT, puedes copiar el resultado, hacer comentarios o regenerar las respuestas si no cumplen tus expectativas.

A diferencia del uso de Ollama a través de la interfaz de línea de comandos (CLI), la combinación de esta herramienta LLM con Open WebUI te permite cambiar de modelo a mitad de conversación para explorar diferentes resultados dentro del mismo chat.

Por ejemplo, puedes empezar con Llama para una discusión general y luego cambiar a Vicuna para una respuesta más especializada sobre el mismo tema.

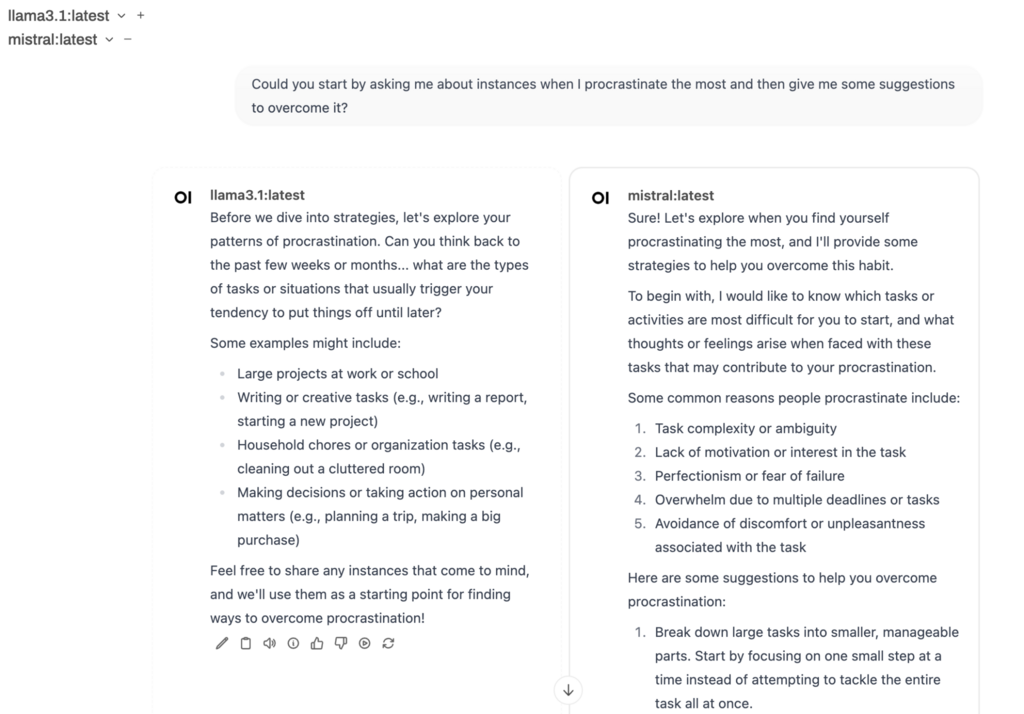

Otra característica única es la posibilidad de cargar varios modelos simultáneamente, lo que resulta ideal para comparar respuestas. Selecciona tu modelo inicial y, a continuación, haz clic en el botón + situado junto a él para elegir modelos adicionales.

Una vez introducida la pregunta, cada modelo generará sus resultados uno al lado del otro.

Aprende a escribir mejores prompts con nuestra guía de técnicas de ingeniería de prompt con IA.

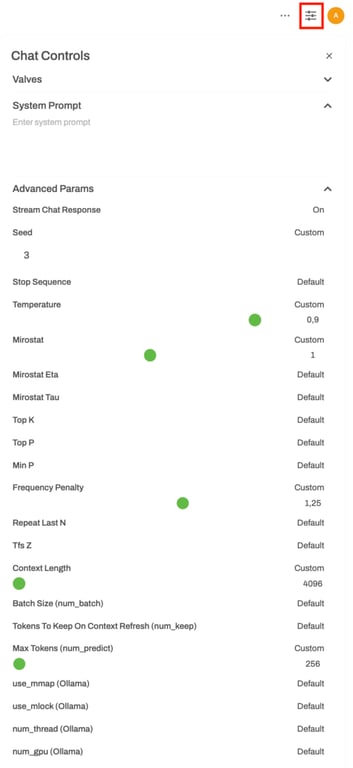

Ajustar las respuestas del modelo te permite afinar la forma en que el modelo interpreta las indicaciones, optimizándolo para tareas específicas, tonos o necesidades de rendimiento.

Pulsa el botón Control de chat para acceder a los parámetros que ajustan el comportamiento, el estilo y la eficacia de la respuesta, incluidos:

En el mismo menú, también puedes personalizar Valves, que incluye herramientas y funciones personalizadas, y System Prompt, que define el tono y el comportamiento del modelo. Lo explicaremos con más detalle en la sección de funciones de colaboración.

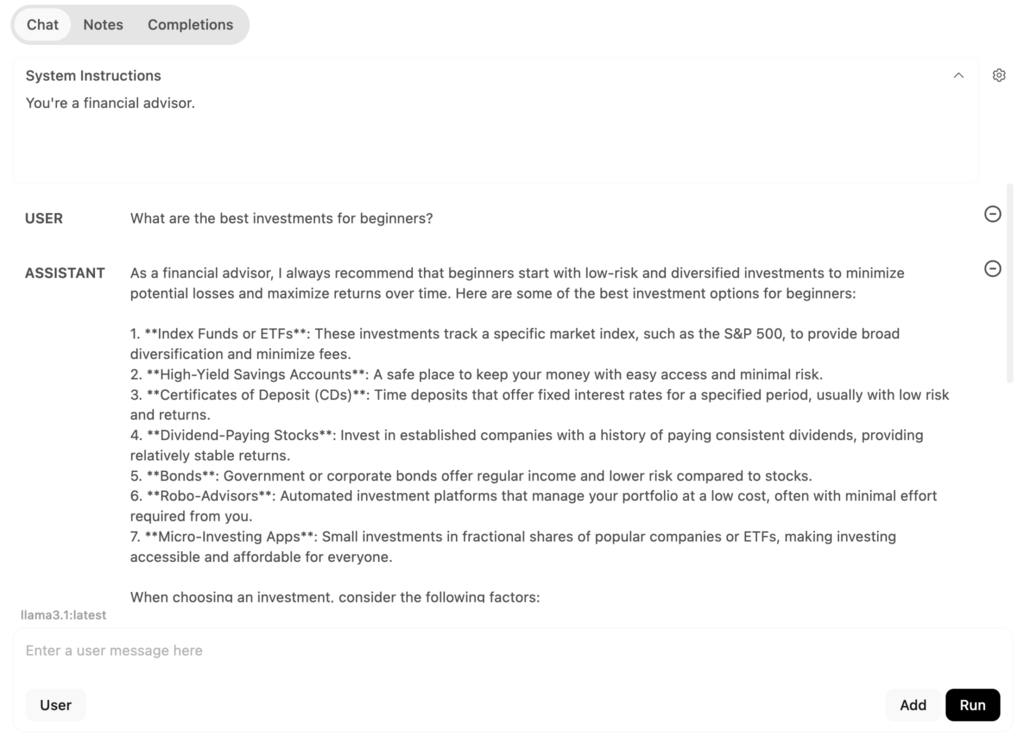

Además, el modo Playground, accesible desde la esquina superior derecha, te permite experimentar con diferentes configuraciones y tipos de aviso. En la pestaña Chat, puedes probar configuraciones conversacionales:

Por ejemplo, si se establecen las instrucciones del sistema en “Eres un asesor financiero” y se escribe una pregunta en el campo del usuario, el modelo responderá desde esa perspectiva.

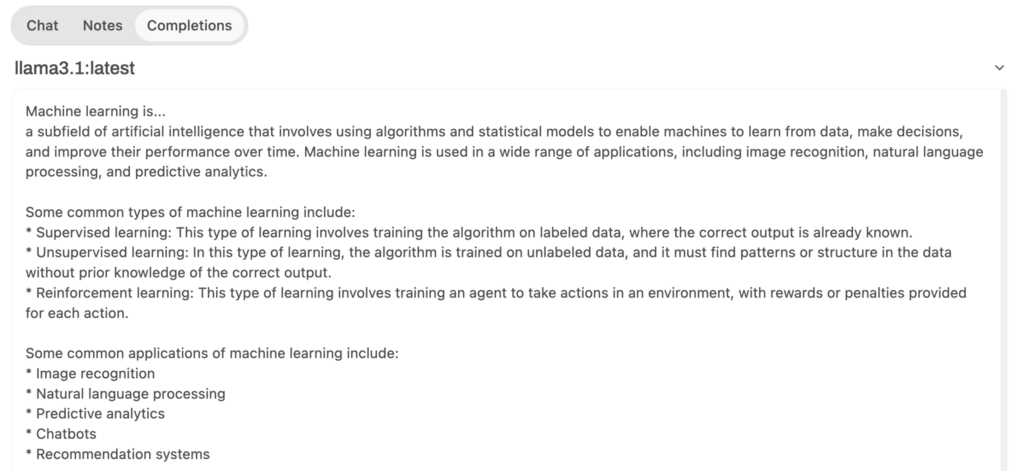

Mientras tanto, la pestaña Completar pide al modelo que genere respuestas continuando a partir de tus entradas. Por ejemplo, si escribes “El aprendizaje automático es…”, el modelo completará el enunciado, explicando el aprendizaje automático.

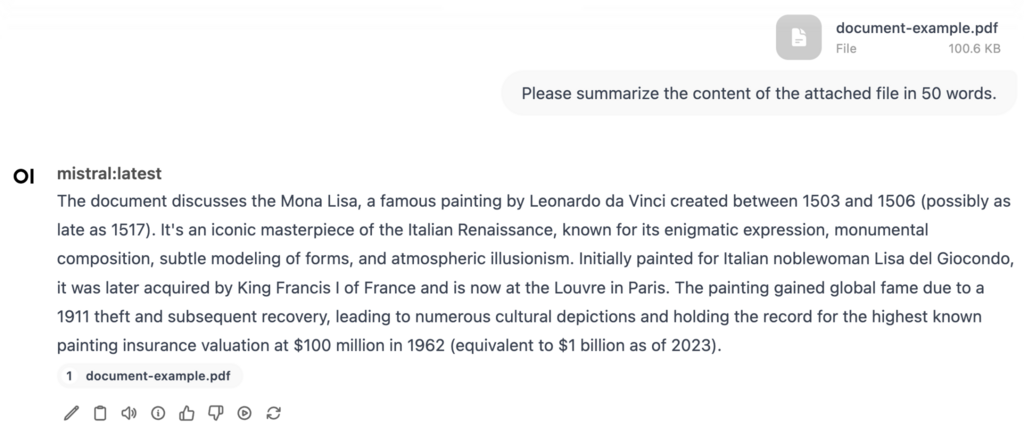

Ollama y Open WebUI admiten la generación aumentada por recuperación (RAG), una función que mejora las respuestas del modelo de IA recopilando información en tiempo real de fuentes externas como documentos o páginas web.

De este modo, el modelo puede acceder a información actualizada y específica del contexto para obtener respuestas más precisas.

Open WebUI te permite subir documentos en formato DOC, PDF, TXT y RTF. Haz clic en el botón + del campo de solicitud y selecciona Cargar archivos. Elige el documento que quieres subir y escribe una instrucción para el modelo, como por ejemplo:

“Por favor, resume el contenido del archivo adjunto en 50 palabras”.

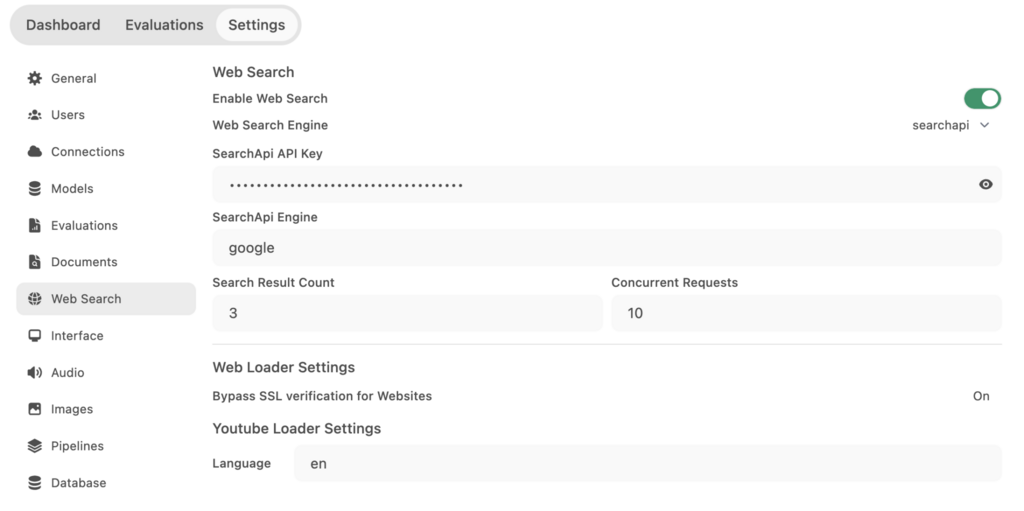

Si deseas que el modelo navegue por la web, puedes conectar Open WebUI a SearchApi, una interfaz de programación de aplicaciones (API) que recupera información basada en resultados de búsqueda. Sigue estos pasos para configurarlo:

Una vez finalizado el proceso de configuración, vuelve a la interfaz de chat, haz clic en el botón + del campo de mensaje y activa la Búsqueda web. Ahora puedes pedir al modelo que acceda a información directamente desde la web. Por ejemplo:

“Encuentra las últimas noticias sobre energías renovables y resume los puntos más importantes”.

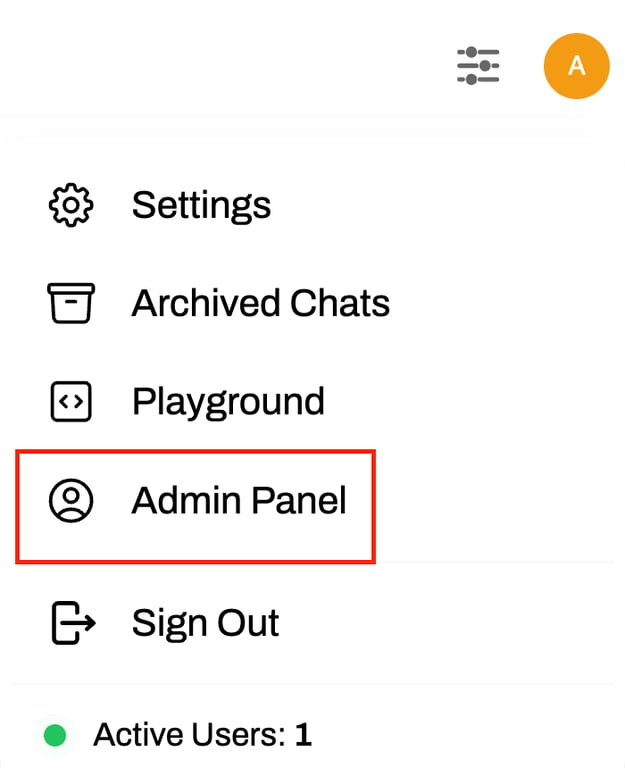

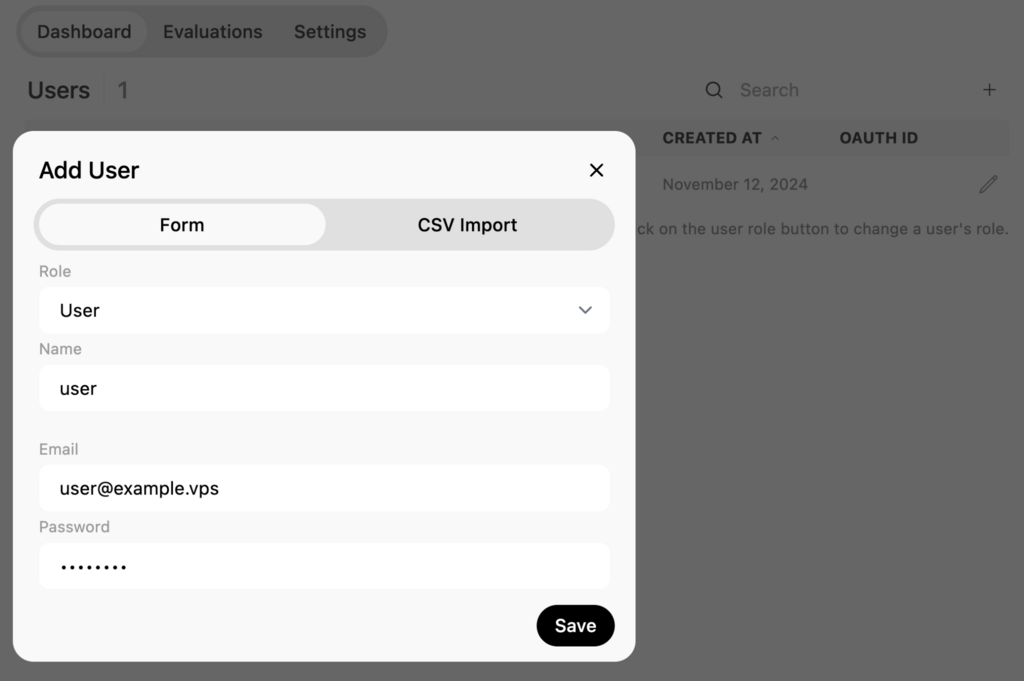

Para equipos que buscan colaborar, Open WebUI te permite gestionar múltiples usuarios. Para añadir un nuevo usuario:

Una vez completado, comparte las credenciales con el usuario para que pueda iniciar sesión. Ten en cuenta que los usuarios que no son administradores no pueden acceder al área de trabajo ni al panel de administración.

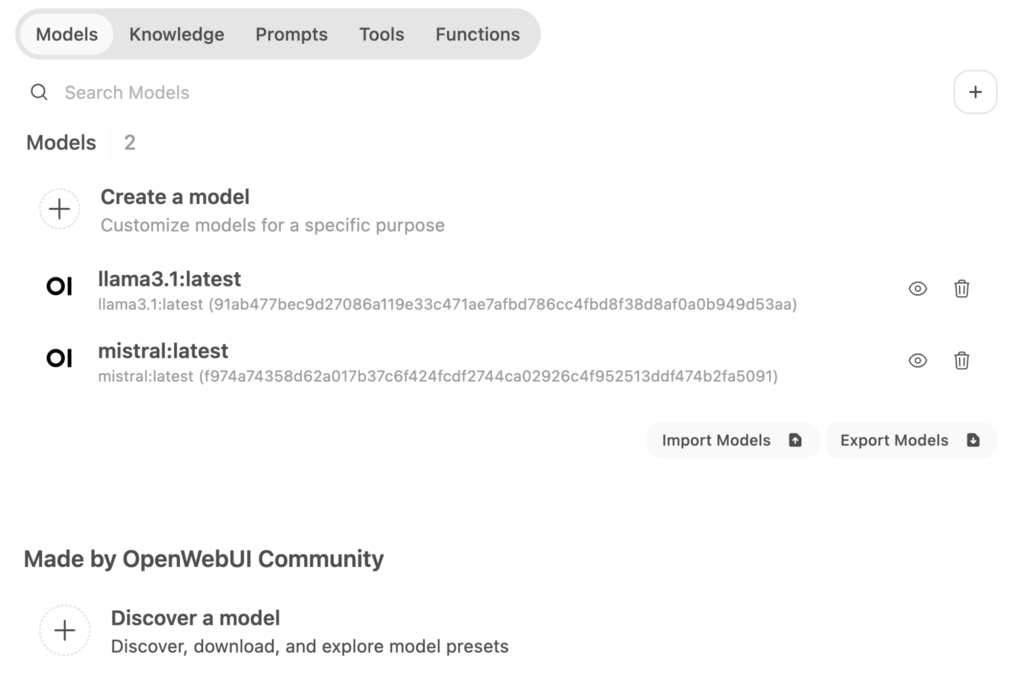

A continuación, puedes explorar el área de trabajo a través de la barra lateral izquierda. En la pestaña Modelos, puedes crear nuevos modelos basados en los existentes, importar modelos personalizados de la comunidad Open WebUI y eliminar modelos descargados.

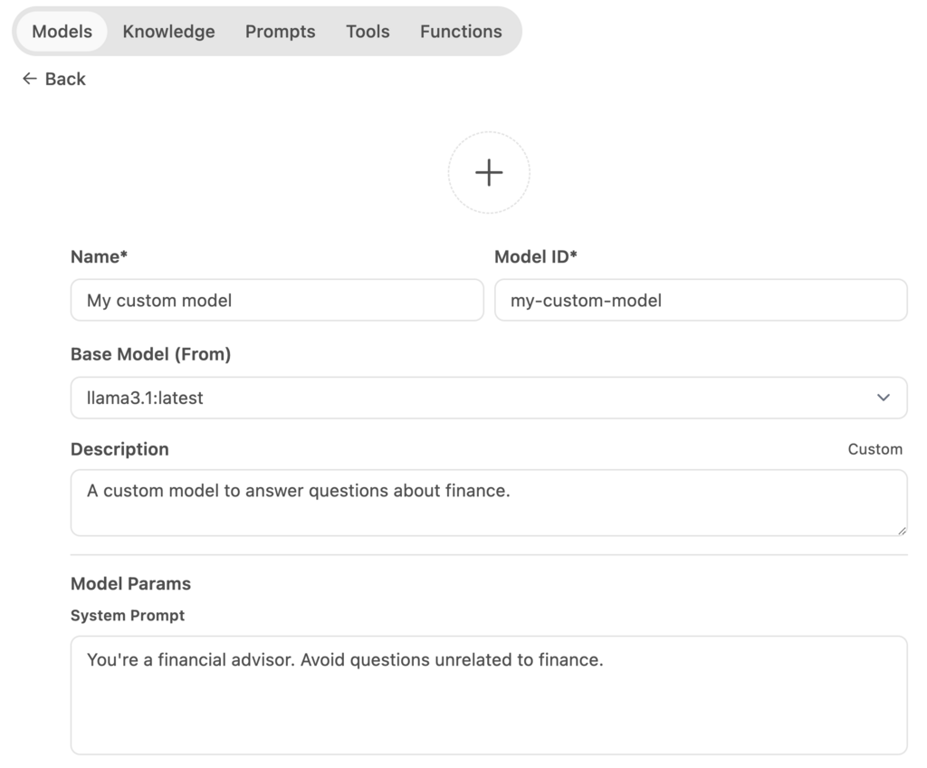

Para crear un modelo personalizado, haz clic en Crear un modelo y rellena detalles como el nombre, el ID y el modelo base.

También puedes añadir una sugerencia personalizada del sistema para guiar el comportamiento del modelo, por ejemplo, indicándole que actúe como un asesor financiero y evite preguntas no relacionadas.

También dispone de opciones avanzadas para establecer parámetros, añadir sugerencias e importar recursos de conocimiento. Una vez completada la configuración, haz clic en Guardar y crear.

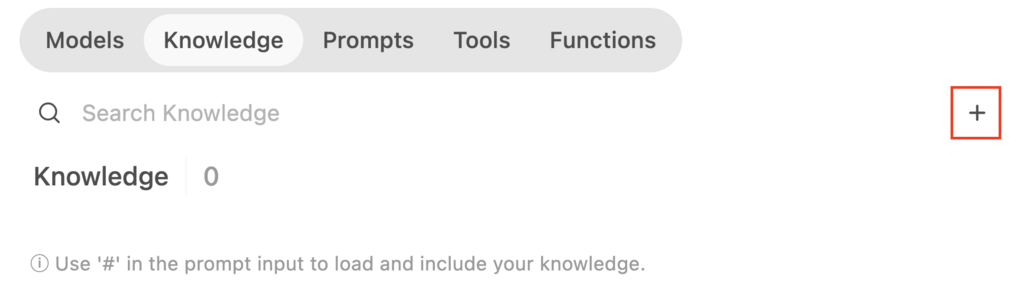

Si aún no has creado recursos de conocimiento y quieres entrenar tu nuevo modelo, ve a la pestaña Conocimiento. Haz clic en el botón + y sigue las instrucciones para importar tu conjunto de datos. Una vez cargado, vuelve a tu nuevo modelo e importa los conocimientos que acabas de añadir.

Puedes añadir personalizaciones similares en las pestañas Avisos, Herramientas y Funciones. Si no estás seguro de cómo empezar, importa los preajustes de la comunidad.

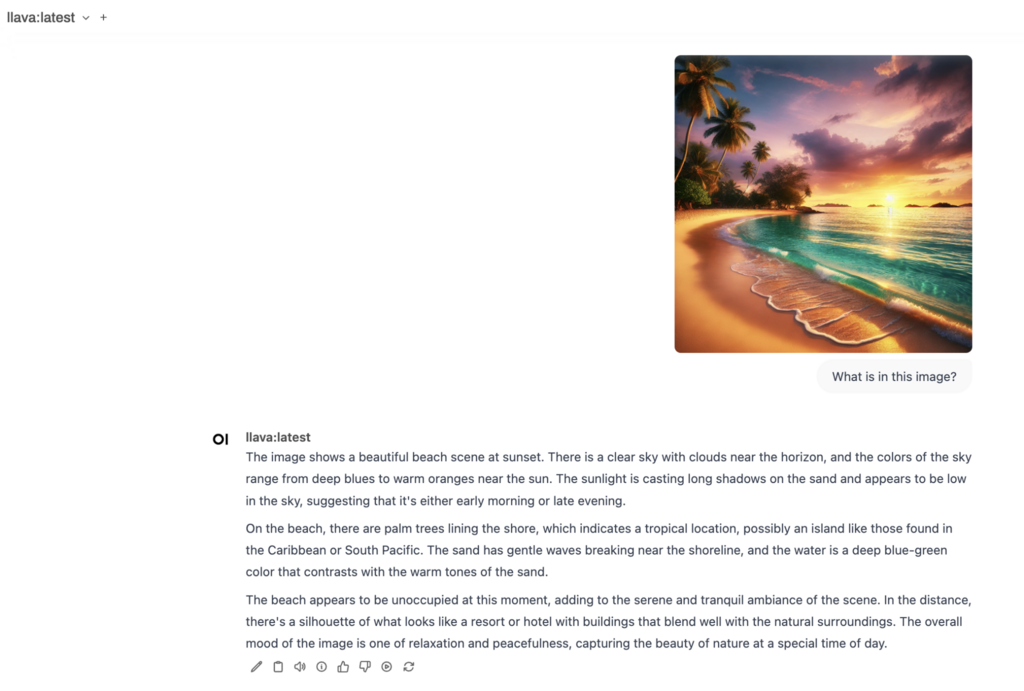

Por último, demostraremos cómo trabajar con modelos multimodales, que pueden generar respuestas basadas en texto e imágenes. Ollama soporta varios modelos multimodales, incluyendo LlaVa, BakLLaVA, y MiniCPM-V.

En este ejemplo, utilizaremos LlaVa. Tras descargarlo del panel de selección de modelos, puedes utilizarlo para diversas tareas. Por ejemplo, puedes cargar una imagen y hacerle preguntas al modelo sobre ella, como “¿Qué hay en esta imagen?”.

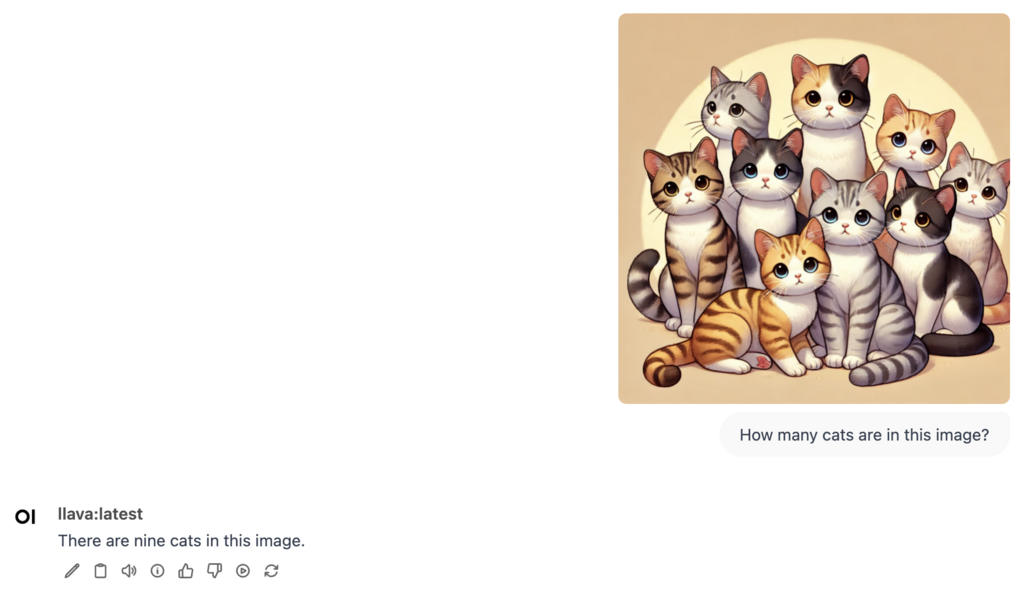

También puedes utilizarlo para crear pies de foto descriptivos para tus imágenes. Además, el modelo puede identificar objetos dentro de una imagen. Por ejemplo, si subes una foto de gatos, puedes preguntarle al modelo: “¿Cuántos gatos hay en esta imagen?”.

Sin embargo, recuerda que actualmente LLaVA no puede generar imágenes. Su objetivo principal es analizar y responder a preguntas sobre imágenes existentes.

El uso de Ollama con Open WebUI te permite ejecutar modelos a través de una interfaz visual y fácil de usar para principiantes. La plantilla Ollama VPS de Hostinger facilita la instalación de estas herramientas, incluso para usuarios no especializados.

Una vez instalado, puedes navegar por el panel de control, seleccionar y ejecutar modelos, y explorar las funciones de colaboración para aumentar la productividad.

Las herramientas avanzadas de Open WebUI (como la búsqueda web y la personalización de los parámetros del modelo) son ideales para los usuarios que desean adaptar las interacciones del modelo.

Los interesados en desplegar sus propios modelos pueden importar sus conjuntos de conocimientos, experimentar con distintas instrucciones y combinarlas con plantillas de instrucciones y funciones personalizadas creadas por la comunidad.

Si tienes alguna pregunta, no dudes en hacerla en los comentarios.

El uso de Ollama con una herramienta de interfaz gráfica de usuario como Open WebUI simplifica las interacciones del modelo a través de una interfaz visual, por lo que es fácil de usar para principiantes e ideal para flujos de trabajo colaborativos basados en equipos sin necesidad de conocimientos de línea de comandos.

Puedes utilizar todos los modelos de Ollama tanto en la versión CLI como en la GUI. Sin embargo, el entorno GUI hace que sea más cómodo ejecutar modelos multimodales para tareas como el análisis de imágenes.

Sí, debes instalar Docker antes de configurar Ollama con Open WebUI. Si utilizas la plantilla Ollama de Hostinger, todos los componentes necesarios, incluido Docker, están preinstalados.

Todo el contenido de los tutoriales en este sitio web está sujeto a los rigurosos estándares y valores editoriales de Hostinger.